云计算数据中心设计方案案例.docx

《云计算数据中心设计方案案例.docx》由会员分享,可在线阅读,更多相关《云计算数据中心设计方案案例.docx(17页珍藏版)》请在冰豆网上搜索。

云计算数据中心设计方案案例

云计算数据中心设计方案案例

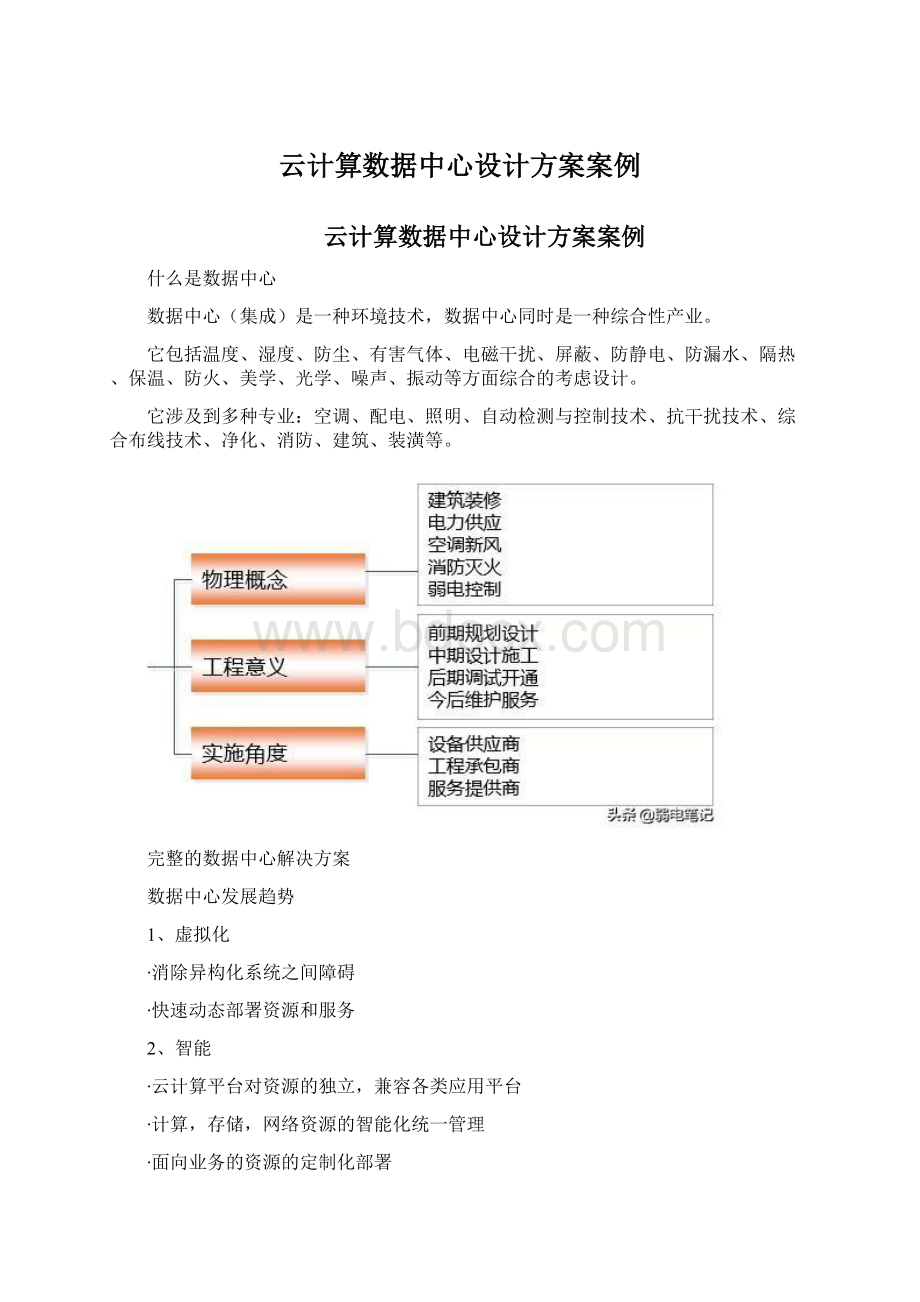

什么是数据中心

数据中心(集成)是一种环境技术,数据中心同时是一种综合性产业。

它包括温度、湿度、防尘、有害气体、电磁干扰、屏蔽、防静电、防漏水、隔热、保温、防火、美学、光学、噪声、振动等方面综合的考虑设计。

它涉及到多种专业:

空调、配电、照明、自动检测与控制技术、抗干扰技术、综合布线技术、净化、消防、建筑、装潢等。

完整的数据中心解决方案

数据中心发展趋势

1、虚拟化

∙消除异构化系统之间障碍

∙快速动态部署资源和服务

2、智能

∙云计算平台对资源的独立,兼容各类应用平台

∙计算,存储,网络资源的智能化统一管理

∙面向业务的资源的定制化部署

3、绿色

∙虚拟化技术与绿色科技结合,降低能耗

∙先进、高效、智能的系统散热方案

∙智能化的环境控制和能效管理系统

4、低成本

∙虚拟化提高资源利用率,

∙简化管理维度,节省维护成本

∙支持异构资源兼容,实现业务的平滑升级

云计算服务类型

1、SaaS软件即服务

∙资源管理应用系统,如客户关系管理系统CRM

∙文档编辑处理,如GoogleDoc

∙地图服务,如GoogleMap

∙应用程序定制使用,如Saleforce应用软件超市

2、PaaS平台即服务

∙应用程序开发/运行平台,如GoogleAppEngine

∙在线数据库服务,如亚马逊在线简单数据库服务(AmazonSDB)

∙云操作系统,如WindowAzure

3、IaaS架构即服务

∙云主机

∙云存储

∙云容灾备份

∙虚拟防火墙

∙弹性计算平台

数据中心机房等级划分

数据中心的定级取决于整个系统中最低等级的部件

云数据中心解决方案构成

数据中心组成元素

数据中心基础设施建设

物理设施建设

机房服务

1、机房装修系统

∙吊顶

计算机机房吊顶板:

表面应平整,不得起尘、变色和腐蚀;其边缘应整齐、无翘曲,封边处理后不得脱胶;填充顶棚的保温、隔音材料应平整、干燥,并做包缝处理;

按设计及安装位置严格放线;

安装位置准确:

定准吊顶上的灯具、各种风口、火灾探测器底座及灭火喷嘴等位置,并与龙骨和吊顶紧密配合安装。

∙地面工程

整个机房区的地面在铺设地板之前,需作防尘、防潮处理,活动地板下的建筑面应平整、光滑并做保温防尘处理,机房内防静电地板需做等电位体。

∙隔断工程

无框玻璃隔断,应采用槽钢、全钢结构框架。

石膏板、吸音板等隔断墙的沿地、沿顶及沿墙龙骨建筑围护结构内表面之间应衬垫弹性密封材料后固定。

竖龙骨准确定位并校正垂直后与沿地、沿顶龙骨可靠固定。

全钢防火大玻璃隔断,钢管架刷防火漆,玻璃厚度不小于12mm,无气泡。

∙门窗工程

铝合金门框、窗框、隔断墙的规格型号应符合设计要求,安装应牢固、平整,其间隙用非腐蚀性材料密封。

当设计无明确规定时隔断墙沿墙立柱固定点间距不宜大于800mm

2、机房供配电系统

数据中心由市电、UPS、柴油发电机协同供电

∙电气系统

供配电系统:

应为380V/200V、50HZ,计算机供电质量达到A级。

供配电方式:

为双路供电系统加UPS电源及柴油发电机设备,并对空调系统和其他用电设备单独供电,以避免了空调系统启停对重要用电设备的干扰。

供电系统的负荷包括如下:

1.服务器功率:

单台服务器功率╳服务器台数=总功率

2.UPS总功率:

一般采用n+1备份方案,亦即并联UPS台数多加壹台,以防止某一台机组出现故障。

目前UPS效率均在90%以上,故按照服务器总功率可以计算出UPS的总KVA数。

3.恒温恒湿精密空调负荷:

工作区面积╳200~250kcal/hr/m2=总的空调所需制冷量

4.办公区空调、照明

等负荷

5.其它用负荷

由上可以计算出一个数据中心机房所需的用电负荷总功率。

∙电源

UPS—一类电源

一是应急使用,防止突然断电而影响设备正常工作,给用电设备造成损害;

二是消除市电上的电涌、瞬间高电压、瞬间低电压、电力线噪声和频率偏移等“电源污染”,改善电源质量,为用电设备提供高质量的电源。

市电供电电源—二类电源

由电源互投柜分别送至空调、照明配电箱和插座配电箱,再分路送至灯具及墙面插座。

电缆用阻燃电缆,照明支路用塑铜线,穿金属线槽及钢管敷设。

柴油发电机组—三类电源

由电源互投柜分别送至空调、照明配电箱和插座配电箱,再分路送至灯具及墙面插座。

电缆用阻燃电缆,照明支路用塑铜线,穿金属线槽及钢管敷设。

3、机柜系统

机柜分类:

服务器机柜、网络机柜、控制台机柜等

尺寸:

机柜高一般在1.8m~2.2m左右

结构:

封闭式,半封闭式,敞开式机柜

摆放方式:

面对面,背对背,形成冷热通道

间距:

背部间距最小需要间隔0.6m,推荐间隔1米;前部间隔最小为1米推荐间隔1.2m与吊顶间距:

至少0.4m。

功率:

考虑到供电及散热,单机柜功率3~5KW,规划时建议不超过4KW。

根据服务器的功率(PC服务器正常功耗300~500W)计算出机柜的数量,推荐每个机柜放置8~10台PC服务器。

4、数据中心制冷系统

∙空调系统

精密空调

机房室内环境参数

夏季:

温度23±2℃,相对湿度50%

冬季:

温度20±2℃,相对湿度50%

∙机房散热风道设计

冷风道/热风道

电缆布置

天花板导管辅助

5、防雷接地系统

防雷接地系统

∙等电位接地的处理

接地是避雷技术最重要的环节,而且小型机以上的计算机系统对接地要求也很高,其接地地阻通常要求小于1欧姆以下。

但对于避雷技术来说,地阻小于4欧姆即可。

应将避雷接地、电器安全接地、交流地、直流接地统一为一个接地装置,避免不同的地之间产生反击。

∙电源部分防雷设计

根据雷电流大、防雷器存在残压及设备耐冲击水平低的特性,应遵循多级保护,层层泻能的原则,选择安装避雷器,进行电源线路的过压保护。

∙信号系统的防雷设计

机房的数据通信线路有以太网双绞线、DDN专线、光纤线路以及电话线备份线路,必须对进出机房的的所有通信线路进行防雷处理,才能保护机房的安全。

6、数据中心机房的走线方式

∙地板下走线

数据线,电源线和冷风管道从数据中心架空的地板下安装;

应用场景-大部分数据中心

优点-冷气从地板送入机架,热气从数据中心顶部抽走,有利于热循环;数据线、电源线安装在地板下,避免直接接触,更加安全;同时地板布线便于维修。

∙上走线

数据线,电源线和从数据中心的吊顶安装;冷风管道也在吊顶安置;机柜高度一般为2m,空气流动所需机柜顶面至天花板的距离一般为500-700mm,所以机房净高不小于2.6m。

应用场景-应用于中小型数据中心

优点-投资低于地板走线方式,占用地板空间少,利于小型数据中心;

缺点-冷却系统设计复杂;电源插座可靠性降低,存在因为插座重力作用导致脱落的可能;建议采用交叉插座进行固定。

∙架空走线

弱电、强电、光纤分层架空走线,避免干扰,火灾隐患容易及时发现。

应用场景-大型数据中心

缺点-机房层高要求;扩展难度大,维护困难。

各种走线方式优势对比

7、消防系统

消防控制中心包括智能火灾报警控制主机,用于集中报警及控制。

消防控制中心外围报警及控制包括光电感烟探测器、感温探测器、组合控制器和气瓶等。

上述设备位于各楼层现场和端子箱内。

有管网七氟丙烷自动灭火系统为全淹没灭火系统,分为单元独立系统和组合分配系统。

有管网灭火系统需设单独储瓶间,气体喷放需通过放在保护区内的管网系统进行。

8、安保系统

∙视频监控系统

视频监控系统对建筑物内外的主要出数据中心各区域入口、通道、电梯厅、电梯轿厢、中心机房及其他重要部位进行视频监视,实时地显示和记录被控现场或被控目标的详细情况,以便保安人员及时采取措施。

∙门禁系统

门禁管理系统的主要目的是保证重要区域设备和资料的安全。

系统实现对来访者的身份确认和通道控制。

卡片采用感应式卡片、指纹、瞳孔等技术。

卡出入系统具有权限设置的功能,即每张卡可进出的时间、可进出哪道门,可为不同的卡片持有者不同的权限。

每次有效的进入都有存档或统计。

电锁应采用安全可靠的产品,有电闭锁或无电闭锁根据用户要求可调。

紧急情况下或电锁出现故障的情况下应有应急钥匙可将门打开。

门禁系统最好采用计算机控制系统。

全套系统最好有备用电源。

9、动力环境监控系统

被监控对象按功能分为动力和环境两大类,动力类包括高配电、低压配电、UPS、油机、电源、电池组、空调等,环境类包括、烟感、温度、湿度等。

数据中心基础网络设计

∙模块化

数据中心以应用群为单位整合成模块部件

根据数据中心不同业务区域性质设计安全模块要素

安全模块可集中部署数据中心访问控制策略

∙标准化

对数据中心模块设计规范化

相同架构要求的业务区采用同样的基础网络组件

扩展数据中心区域可直接进行模块复制

∙结构化

适当的冗余性

一般进行双节点冗余性设计,过度的冗余不便于运行维护

网络的对称性

对称性有助于拓扑直观,有助于协议设计分析

网络业务的适度分隔

有利于网络的策略部署,减少对关键业务的影响,缩小故障范围

网络基础架构

安全架构

安全&优化模型

数据中心解决方案

数据中心解决方案框架

基础物理设计架构

机房整体布局示例