1CentOS下搭建hadoop伪分布式.docx

《1CentOS下搭建hadoop伪分布式.docx》由会员分享,可在线阅读,更多相关《1CentOS下搭建hadoop伪分布式.docx(12页珍藏版)》请在冰豆网上搜索。

1CentOS下搭建hadoop伪分布式

CentOS下搭建hadoop伪分布式

1.打开配置好JDK的CentOS7,输入mkdir/usr/local/hadoop创建一个hadoop的文件夹

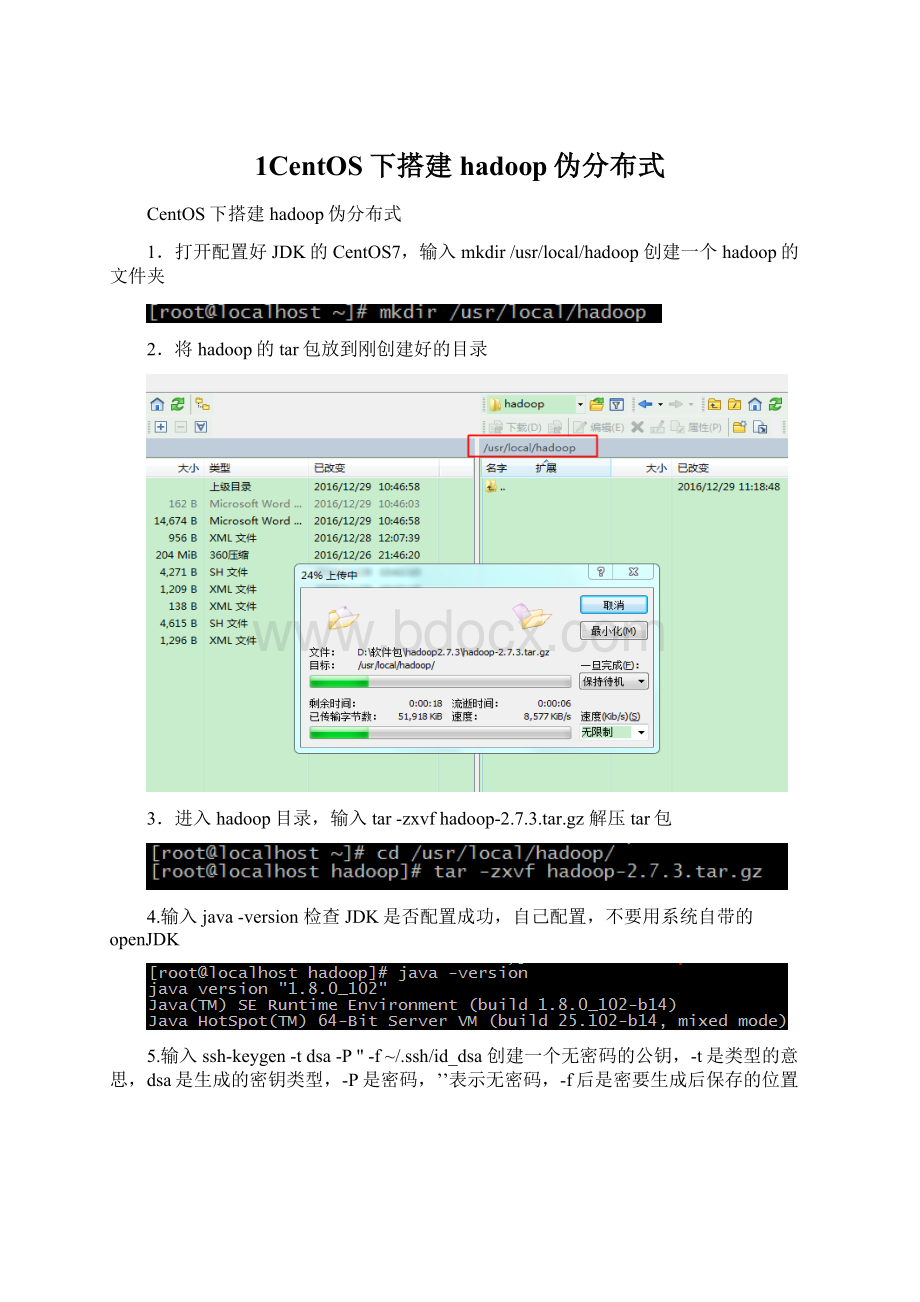

2.将hadoop的tar包放到刚创建好的目录

3.进入hadoop目录,输入tar-zxvfhadoop-2.7.3.tar.gz解压tar包

4.输入java-version检查JDK是否配置成功,自己配置,不要用系统自带的openJDK

5.输入ssh-keygen-tdsa-P''-f~/.ssh/id_dsa创建一个无密码的公钥,-t是类型的意思,dsa是生成的密钥类型,-P是密码,’’表示无密码,-f后是密要生成后保存的位置

6.输入cat~/.ssh/id_dsa.pub>>~/.ssh/authorized_keys将公钥id_dsa.pub添加进keys,这样就可以实现无密登陆ssh

7.输入sshlocalhost验证,第一次登陆有询问,输入yes,登陆成功且不需要密码

8.输入vi/etc/hostname修改主机名

9.将localhost.localdomain修改为localhost,保存并退出

10.创建3个之后要用到的文件夹,分别如下:

mkdir/usr/local/hadoop/tmp

mkdir-p/usr/local/hadoop/hdfs/name

mkdir/usr/local/hadoop/hdfs/data

11.输入vi~/.bash_profile修改环境变量,这个和之前配JDK那个不同,profile是超级用户所有,这个是每个用户独立所有的,就在~目录下,是隐藏文件,可以用ll-a查看

12.根据hadoop的解压位置,配置环境变量如下所示

13.按ESC切换到命令模式,然后输入:

wq!

保存并退出

14.输入source~/.bash_profile使环境变量生效,将source简写为.也可以

15.进入hadoop解压后的/etc/hadoop目录,里面存放的是hadoop的配置文件,接下来要修改这里面一些配置文件

16.有2个.sh文件,需要指定一下JAVA的目录,首先输入vihadoop-env.sh修改配置文件

17.将原有的JAVA_HOME注释掉,根据自己的JDK安装位置,精确配置JAVA_HOME如下

18.按ESC,输入:

wq!

保存并退出,这里和之后的保存并退出就不再截图

19.输入viyarn-env.sh修改配置文件

20.在如下位置添加exportJAVA_HOME=/usr/local/java/jdk1.8.0_102指定JAVA_HOME,保存并退出

21.输入vicore-site.xml修改配置文件

22.在configuration标签中,添加如下内容,保存并退出,注意这里配置的hdfs:

localhost:

9000是不能在网页访问的,可以在本机访问,等配好并启动hadoop后,可以输入hadoopfs-lshdfs:

localhost:

9000命令进行访问,查看hdfs的文件目录及文件

fs.defaultFS

hdfs:

//localhost:

9000

HDFS的URI

hadoop.tmp.dir

/usr/local/hadoop/tmp

namenode上本地的hadoop临时文件夹

23.输入vihdfs-site.xml修改配置文件

24.在configuration标签中,添加如下内容,保存并退出

dfs.namenode.name.dir

file:

/usr/local/hadoop/hdfs/name

namenode上存储hdfs名字空间元数据

dfs.datanode.data.dir

file:

/usr/local/hadoop/hdfs/data

datanode上数据块的物理存储位置

dfs.replication

1

副本个数,默认是3,应小于datanode机器数量

25.输入cpmapred-site.xml.templatemapred-site.xml将mapred-site.xml.template文件复制到当前目录,并重命名为mapred-site.xml

26.输入vimapred-site.xml修改配置文件

27.在configuration标签中,添加如下内容,保存并退出

mapreduce.framework.name

yarn

指定mapreduce使用yarn框架

28.输入viyarn-site.xml修改配置文件

29.在configuration标签中,添加如下内容,保存并退出

yarn.nodemanager.aux-services

mapreduce_shuffle

NodeManager上运行的附属服务。

需配置成mapreduce_shuffle,才可运行MapReduce程序

30.进入hadoop的bin目录,输入./hdfsnamenode-format格式化namenode,第一次使用需格式化一次,之后就不用再格式化,如果改一些配置文件了,可能还需要再次格式化

31.格式化完成

32.进入hadoop的sbin目录,输入./start-all.sh启动hadoop

33.输入yes,这里是因为防火墙没有关,有一些警告

34.输入jps查看当前java的进程,该命令是JDK1.5开始有的,作用是列出当前java进程的PID和Java主类名,除了JPS,有5个进程都是hadoop启动的进程,启动成功

35.虚拟机内打开网页,输入localhost:

8088,查看hadoop进程管理界面

36.虚拟机内打开网页,输入localhost:

50070,查看hdfs的界面

37.能访问8088和50070两个端口看到如上两个界面,说明hadoop搭建完成,接下来通过本地web访问这两个端口,IP输入虚拟机的IP

38.如上所示,访问失败,这是因为没有关闭虚拟机的防火墙,输入systemctlstopfirewalld.service关闭防火墙,

39.若想重启后,防火墙不再开启,输入systemctldisablefirewalld.service

40.继续在本地网页访问hadoop的8088和50070端口,访问成功