hadoop虚拟机安装文档Word格式文档下载.docx

《hadoop虚拟机安装文档Word格式文档下载.docx》由会员分享,可在线阅读,更多相关《hadoop虚拟机安装文档Word格式文档下载.docx(11页珍藏版)》请在冰豆网上搜索。

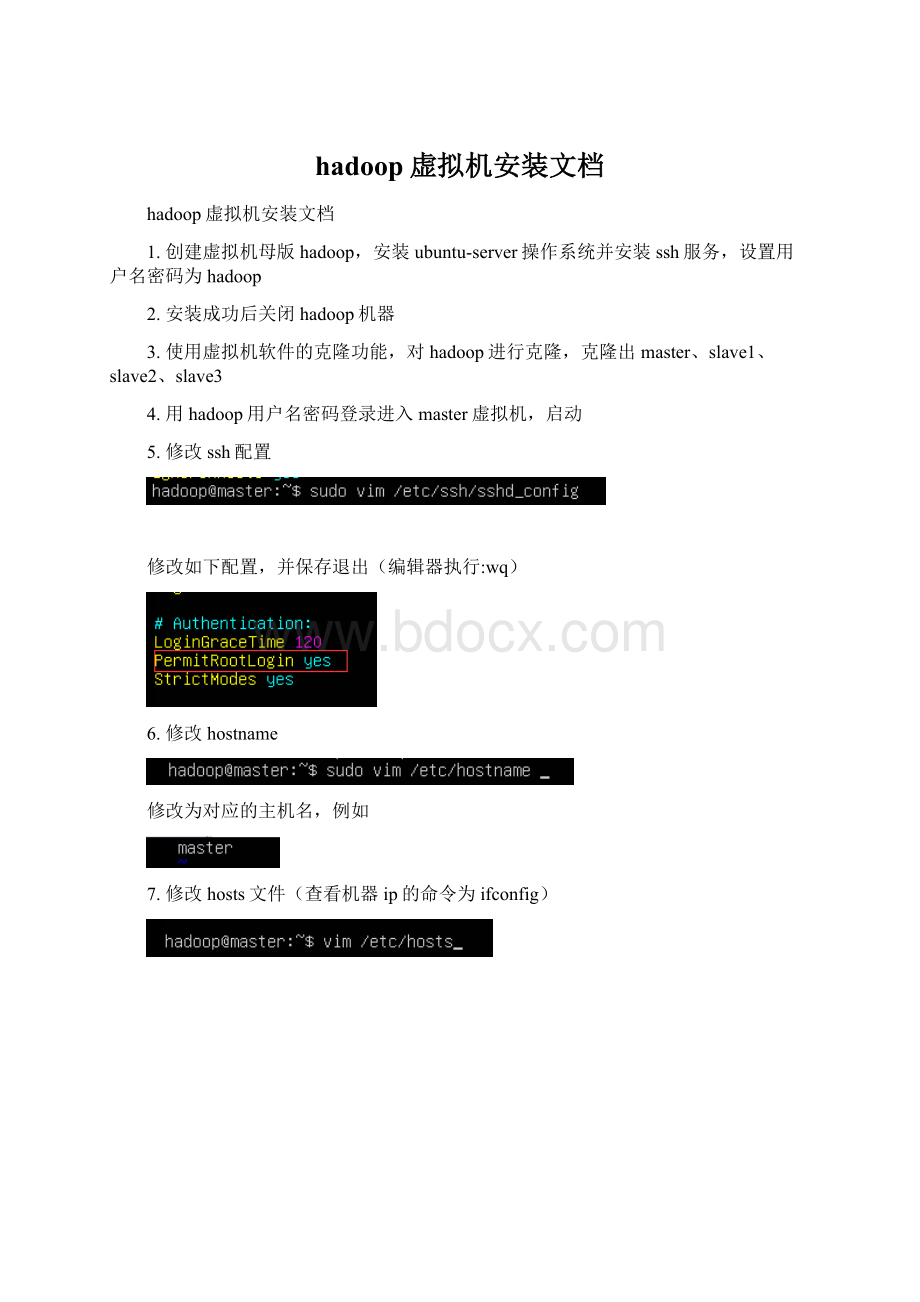

12.在xshell中新建上述4台机器的ip进行连接,以用户root登录

13.验证主机名是否修改,查看4台机器的如下方位

14.进行ssh免登录配置

1)在每台机子上执行如下命令(使用xshell的全部会话功能)

提示yesorno输入yes

2)在每台机子打开如下文件夹

3)在每台机子当前文件夹下执行如下命令生成密钥

ssh-keygen

-t

dsa

-P

'

-f

~/.ssh/id_dsa

4)在master机子上执行:

catid_dsa.pub>

>

authorized_keys

5)在slave1执行:

scpid_dsa.pubmaster:

/root/.ssh/id_dsa.pub.s1

6)在slave2执行:

/root/.ssh/id_dsa.pub.s2

7)在slave3执行:

/root/.ssh/id_dsa.pub.s3

(执行14-5,6,7步时根据提示输入密码)

8)在master机子执行:

catid_dsa.pub.s1>

authorized_keys

catid_dsa.pub.s2>

authorized_keys

catid_dsa.pub.s3>

9)查看authorized_keys文件内容

10)将authorized_keys复制到其他机器上

scpauthorized_keysslave1:

/root/.ssh/

scpauthorized_keysslave2:

scpauthorized_keysslave3:

11)验证免登陆

在master机器上执行:

sshslave1连接slave1(首次连接会有提示,直接输入yes)

1.进入opt目录下安装hadoop和jdk

2.选择xftp上传tar包

3.拉取tar包进入master机器

4.解压安装包,依次执行如下命令

tar-xvfhadoop-2.6.0-cdh5.5.0.tar.gz

tar-xvfjdk-7u79-linux-x64.gz

mvhadoop-2.6.0-cdh5.5.0.tar.gzhadoop

mvjdk-7u79-linux-x64.gzjdk

5.修改环境变量

在最下方填入如下内容

exportJAVA_HOME=/opt/jdk/

exportCLASS_PATH=$JAVA_HOME/lib:

$JAVA_HOME/jre/lib

exportPATH=$PATH:

$JAVA_HOME/bin

6.保存退出后执行命令

7.执行java-version查看jdk是否安装成功

8.hadoop安装

在每台机器上执行命令

mkdir-p/var/data/hadoop/hdfs/nn

mkdir-p/var/data/hadoop/hdfs/snn

mkdir-p/var/data/hadoop/hdfs/dn

mkdir-p/opt/hadoop/logs

9.进入hadoop配置文件目录

1)配置core-site.xml

#vimcore-site.xml

添加如下配置:

<

configuration>

property>

name>

fs.default.name<

/name>

value>

hdfs:

//master:

9000<

/value>

/property>

hadoop.http.staticuser.user<

hdfs<

hadoop.tmp.dir<

/hadoop/tmp<

description>

Abaseforothertemporarydirectories.<

/description>

/configuration>

2)配置hdfs-site.xml

同上,添加如下配置:

dfs.replication<

2<

dfs.namenode.name.dir<

file:

/var/data/hadoop/hdfs/nn<

fs.checkpoint.dir<

/var/data/hadoop/hdfs/snn<

fs.checkpoint.edits.dir<

dfs.datanode.data.dir<

/var/data/hadoop/hdfs/dn<

dfs.hosts.exclude<

/opt/hadoop/etc/hadoop/exclude<

dfs.permissions<

false<

3)配置mapred-site.xml(配置前执行cpmapred-site.xml.templatemapred-site.xml)

mapred.job.history.server.embedded<

true<

mapreduce.jobhistory.address<

master:

10020<

mapreduce.jobhistory.webapp.address<

50060<

mapreduce.jobhistory.intermediate-done-dir<

/mr-history/tmp<

mapreduce.jobhistory.done-dir<

/mr-history/done<

mapreduce.framework.name<

yarn<

4)配置yarn-site.xml

<

yarn.resourcemanager.address<

8032<

yarn.resourcemanager.scheduler.address<

8030<

yarn.resourcemanager.resource-tracker.address<

8035<

yarn.resourcemanager.admin.address<

8033<

yarn.resourcemanager.webapp.address<

8088<

yarn.resourcemanager.hostname<

master<

yarn.nodemanager.aux-services<

mapreduce_shuffle<

yarn.nodemanager.aux-services.mapreduce.shuffle.class<

org.apache.hadoop.mapred.ShuffleHandler<

5)修改slaves文件

slave1

slave2

slave3

6)修改hadoop-env.sh文件

10.复制hadoop和jdk到其他机器,在master上执行

scp-r/opt/*slave1:

/opt/

scp-r/opt/*slave2:

scp-r/opt/*slave3:

11.复制环境变量配置文件到其他机器,在master上执行

scp/etc/profileslave1:

/etc/

scp/etc/profileslave2:

scp/etc/profileslave3:

在s