《数据挖掘》复习.docx

《《数据挖掘》复习.docx》由会员分享,可在线阅读,更多相关《《数据挖掘》复习.docx(19页珍藏版)》请在冰豆网上搜索。

《数据挖掘》复习

《数据挖掘》复习

一、题型

1、判断题15分

2、单选题15分

3、简单题15分

4、综合题20分

5、计算题35分(C5.0算法、感知机算法、Apriori算法,见练习题)

二、考试大纲

三、实验/作业评讲

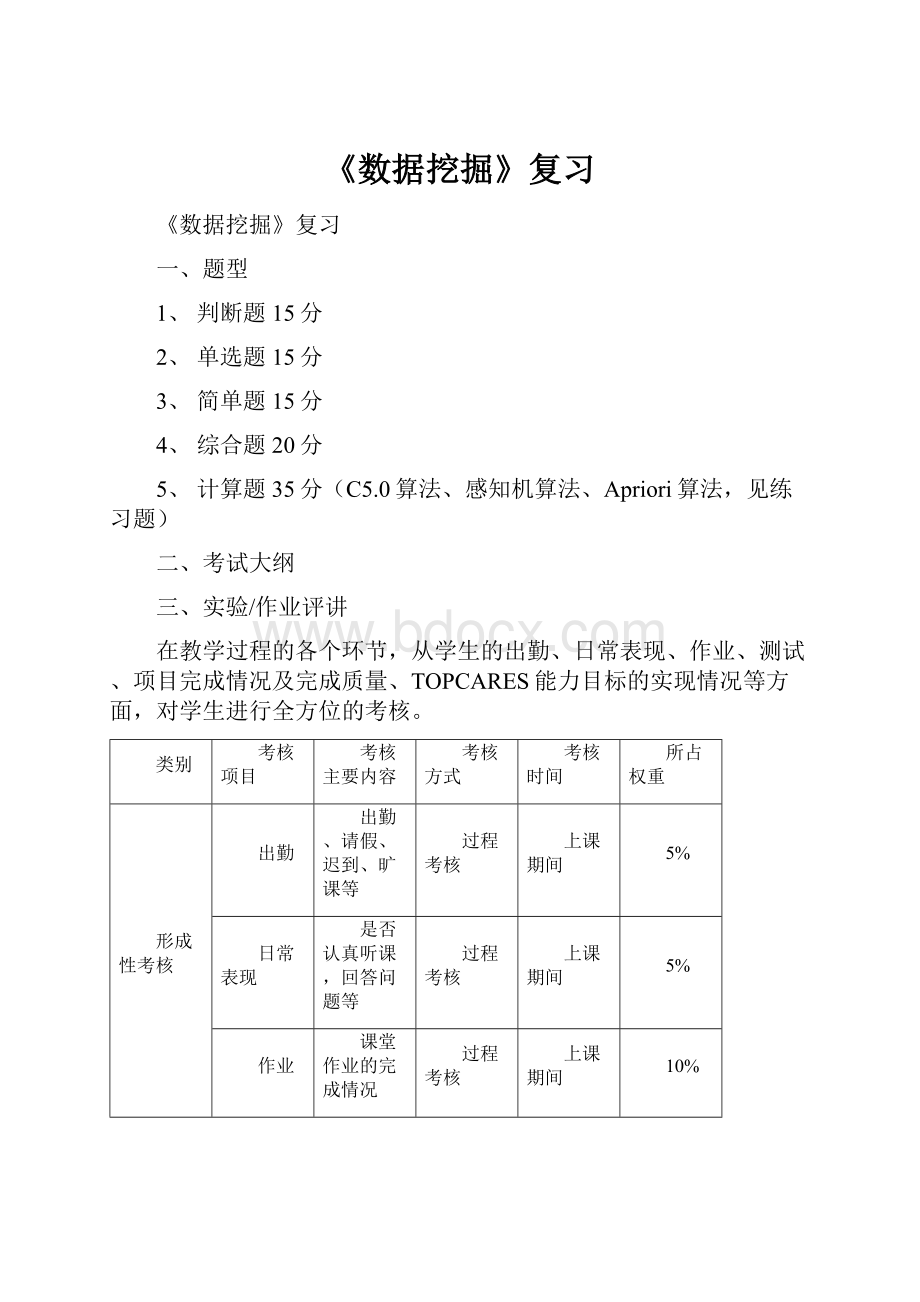

在教学过程的各个环节,从学生的出勤、日常表现、作业、测试、项目完成情况及完成质量、TOPCARES能力目标的实现情况等方面,对学生进行全方位的考核。

类别

考核项目

考核主要内容

考核方式

考核时间

所占权重

形成性考核

出勤

出勤、请假、迟到、旷课等

过程考核

上课期间

5%

日常表现

是否认真听课,回答问题等

过程考核

上课期间

5%

作业

课堂作业的完成情况

过程考核

上课期间

10%

实习项目

实践任务的完成情况

机考

上课期间

10%

终结性考核

完成情况及完成质量

教学内容

闭卷

第17周

70%

说明:

四、知识点梳理,重点教学内容串讲

名词解释

数据挖掘(P6)、算法(P10)、MODELER中的节点(P13)、MODELER中的数据流(P14)、MODELER中的超节点(P18)、决策树分析(P104)、人工神经网络分析(P157)、关联分析(P207)、知识发现KDD(P6)

主要概念

DW产生的基础(P3)

DW的基本过程包括(P6)

DW能做什么(P7)

DW得到的知识形式(P8)

DW的算法分类(P10)

MODELER的主窗口由哪几部分组成(P13)

MODELER中数据流中的节点主要可实现哪些功能(P15)

MODELER中数据流的操作主要包括哪几步(P15)

MODELER中节点工具箱含由八大选项卡组织(P15)

MODELER中通常数据挖掘的基本思路包括哪些过程(P19)

MODELER中从数据挖掘角度看变量有哪7大类型(P26),

通过TYPE节点可以说明变量什么内容(P42)

什么是“有指导学习”(P12、P104)?

举例说明;

决策树算法的核心问题有哪些(P106)?

什么是信息熵(P57、P109)?

(信息熵是连续型变量分箱MDLP算法和决策树C5.0算法的核心)

人工神经网络中主要有哪些网络种类(P156)

神经网络中处理单元的内部结构图(P158)

什么是感知机模型(P162)

什么是B-P反向传播网络模型,由什么特点(P164)

Apriority关联分析算法主要包括哪两大部分技术(P213)(产生频繁集、依据频繁集产生关联规则)

决策树分析(P104)、人工神经网络分析(P157)、关联分析(P207)等数据挖掘方法主要用来解决什么问题(分类、预测、关联等)

3、算法

决策树C5.0算法、人工神经网络B-P感知机算法、关联分析Apriori算法

五、典型例题分析

(一)判断题,在每题后面正确打勾,错误打叉

有高质的原始数据,才可能有高质量的数据挖掘结果。

(√)

高质量数据是数据分析的前提和分析结论可靠性的保障。

(√)

MODELER中数据质量的探索主要包括数据缺失、数据离群点和极端值等几方面。

(√)

数据挖掘的结果都是正确的。

(*)

MODELER中数据挖掘的数据通常以变量为列、样本为行的二维表形式组织。

(√)

变量说明是对读入数据流中变量取值的有效性进行限定、检查和修正,同时指出各个变量在未来建模中的角色。

(√)

变量说明应通过FieldOps选项卡中的类型(Type)节点实现。

(√)

样本浓缩是通过RecordOps卡中的浓缩(Distinct)节点实现。

(√)

样本浓缩是通过RecordOps卡中的汇总(Aggregate)节点实现。

(*)

数据的重新组织是通过FieldOps选项卡中的类型(Type)节点实现。

(*)

数据的重新组织是通过FieldOps选项卡中的重构(Restructure)节点实现。

(√)

数据质量的探索是通过Output卡中的表(Table)节点实现。

(*)

数据质量的探索是通过Output卡中的审核(Data Audit)节点实现。

(√)

网状图是一种更为生动和直观地展示两个或多个分类变量相关特征的图形。

(√)

决策树中,分类树实现对分类型输出变量的分类,回归树则完成对数值型输出变量取值的预测。

(√)

决策树中,称树的每个节点都只能生长出两个分枝的树为多叉树。

(*)

决策树算法中,C5.0用于生成多分支的决策树。

(√)

人工神经网络中,神经网络的最低层称为输入层,最顶层称为输出层,中间层称为中间层。

(*)

在关联分析中,与时间有关的关联分析称为简单关联分析。

(*)

关联规则中的规则的支持度测度了关联规则的普遍性,表示项目X和项目Y同时出现的概率。

(√)

(二)多选题

选择题,请在每题正确备选答案前面打勾(单选及多选)。

(每题满分3分,全选对得3分,部分选对得2分,有选错者该题不得分)

1.Modeler中(类型Type)节点的主要作用有:

1)定义变量的取值范围和缺失值;

2)变量取值的有效性检查和修正;

3)角色说明;

4)变量取值的实例化。

答案:

1-4

2.Modeler中(数据审核DataAudit)节点的主要作用有:

1)对变量取值分布进行基本描述;

2)检验数据质量好坏;

3)修正坏数据;

4)保留高质量的变量和数据。

答案:

1-4

3.Modeler中(变换Transform)节点的主要作用有:

1)描述变量取值分布进行描述;

2)实现变量的变换处理;

3)输出变换后的变量;

4)对变量进行分类汇总。

答案:

1-3

4.Modeler中(分区Partition)节点的主要作用有:

1)生成训练集、检验集;

2)生成训练集、检验集、验证集;

3)对数据进行转置;

4)对样本进行排序。

答案:

1-2

5.神经网络按其拓扑结构可划分为两层、三层和多层结构。

如图所示的神经网络各层的名称是:

1)其中A层是输入层;

2)其中B层是隐层;

3)其中C层是输出层;

4)其中A层是接收层。

答案:

1-3

6.完整的神经网络节点内部主要由两部分组织(如下图),其中:

1)A是加法器;

2)B是激活函数;

3)A是激活函数;

4)B是加法器。

答案:

1-2

7.拟合就是把平面上一系列的点,用一条光滑的曲线连接起来。

在采用机器学习或者训练深度神经网络的时候经常会出现理想情况、欠拟合和过拟合等三种情况。

请写出如下图A、B、C三种拟合状况是属于什么拟合。

1)A欠拟合;

2)B理想拟合;

3)C过拟合;

4)A过拟合。

答案:

1-3

8.如下图神经网络中,“流失”为目标变量,则其输入层、隐层、输出层各有多少个节点?

1)输入层11个节点;

2)隐层有6个节点;

3)输出层有1个节点;

4)输入层有1个节点;

答案:

1-3

9.建立决策树的核心问题是:

1)决策树得生长;

2)决策树的修剪;

3)决策树得几何理解;

4)信息熵和信息增益。

答案:

1-2

10.B-P反向传播神经网络的特点是:

1)包含隐层;

2)激活函数采用Sigmoid函数;

3)反向传播;

4)不包含隐层。

答案:

1-3

(三)解答题

1MODELER的“数据审核DataAudit”节点操作中,如下操作界面中含义是:

答:

指定离群值和极值得监测方法。

具体可按平均值的标准差大小或四分位数的四位数范围来确定离群值和极值,从而监测出离群值和极值。

2.在MODELER的“数据变换Transform”节点操作中,如下操作界面中的含义是:

答:

指定采用哪种变量转换公式,从第2列图开始,各图依次为原始变量的直方图、计算倒数后的直方图、求自然对数的直方图、求常用对数的直方图、计算e的原始变量幂次后的直方图、原始变量求平方根后的直方图。

3.在MODELER的“网状图”节点中,如下套餐类型的输出结果含义是:

答:

显示各种套餐类型与客户流失的之间的关联情况。

如客户流失最少的有:

套餐类型为Plusservice,其次是Basicservice等等。

4.写出如下数据流各节点的主要功能。

答:

Students.xls读取EXCEL数据文件,Append实现样本追加,Type实现变量实例化,Filler进行变量值的填充,Reclassify实现变量重新分类,Partition实现样本分区。

5.写出如下数据流各节点的主要功能。

答:

Customer1、Customer2、ClickPath节点读取数据库文件,Merge实现样本合并,Distinct数据浓缩,Restructure变量重构,Type变量实例化,Apriori进行关联分析。

(四)综合题

1.通过C5.0算法建立了如下决策树,请对照决策树写出对应的推理规则。

2.通过C5.0算法建立了如下决策树,请对照决策树写出对应的推理规则。

答:

IF属性3=立方体THEN类别=B

IF属性3=圆AND属性2=红或黄THEN类别=A

IF属性3=圆AND属性2=黑THEN类别=B

3.在关联分析中,通过Apriori算法,Modeler如下输出结果,请写出对应的三条关联规则,并注明每条关联规则的支持度S、置信度C分别为多少。

答案:

三条规则:

啤酒和罐头蔬菜→冷冻食品(S=16.7%,C=87.4%);

啤酒和冷冻食品→罐头蔬菜(S=17.0%,C=85.9%);

冷冻食品和罐头蔬菜→啤酒(S=17.3%,C=84.4%)。

同时,三条关联规则的提升值都可以接受。

因此,啤酒、罐头蔬菜、冷冻食品是最可能连带销售的商品。

4.在关联分析中,请根据如下输出结果写出相应的关联规则。

答:

(beer)∩(cannedveg)→(frozenmeal)(支持度=16.7,置信度=87.425%)

(beer)∩(frozenmeal)→(cannedveg)(支持度=17.0,置信度=85.882%)

(frozenmeal)∩(cannedveg)→(beer)(支持度=17.3,置信度=84.393%)

(五)计算题

1.在人工神经网络中,设神经元结构如下:

其中x1、x2、x3为输入变量,y为数值型输出变量。

在该神经元的调整权值因子的过程中其学习率η=0.2,神经元的偏差b=0,并且激活函数是线性的,即y=f(净输入net)=net。

各权重初始值分别为:

W1

(1)=0.1、W2

(1)=-0.3、W3

(1)=0.8。

设其权重的调整公式为:

△Wi=η*e*Xi

Wi+1=Wi+△Wi

设有如下训练样本,请按照感知机算法写出第一次迭代后各权重W1

(2)、W2

(2)、W3

(2)的调整值。

解答:

U=0.1*1+(-0.3)*(-1)+0.8*1=1.2,e=0.9-1.2=-0.3

△W1

(2)=-0.03、△W2

(2)=0.03、△W3

(2)=-0.03。

W1

(2)=0.1+(-0.03)=0.07、W2

(2)=(-0.3)+0.03=-0.27、W3

(2)=0.8+(-0.03)=0.77。

2.在人工神经网络中,设神经元结构如下:

其中x1、x2、x3为输入变量,y为数值型输出变量。

在该神经元的调整权值因子的过程中其学习率η=0.2,神经元的偏差b=0,并且激活函数是线性的,即y=f(净输入net)=net。

各权重初始值分别为:

W1

(1)=0.1、W2

(1)=-0.3、W3

(1)=0.8。

设其权重的调整公式为:

△Wi=η*e*Xi

Wi+1=Wi+△Wi

设有如下训练样本,按照Apriori算法请写出第一次迭代后各权重W1

(2)、W2

(2)、W3

(2)的调整值。

样本

X1

X2

X3

Y

1

-1

1

1

0.8

解答:

U=0.1*(-1)+(-0.3)*1+0.8*1=0.4,e=0.8-0.4=0.4

△W1

(2)=-0.04、△W2

(2)=0.04、△W3

(2)=0.04。

W1

(2)=、W2

(2)=、W3

(2)=。

3.设有如下交易(表1),请按照Apriori算法寻找频繁项集。

设定最小支持度为3。

表1

交易号

项集合

T001

A,B,C,E

T002

A,B

T003

A,B,C

T004

A,B,D

T005

A,C,D

T006

B,C

T007

A,C

T008

A,B,C,E

T009

A,B,C

解答:

候选集

第1次扫描

产生2-候选集

第2次扫描

产生3-候选集

第3次扫描

支持度计数

生成频繁项集

支持度计数

生成频繁项集

支持度计数

生成频繁项集

A

B

C

D

E

4.设有如下交易(表1),请按照Apriori算法寻找频繁项集。

设定最小支持度为3。

表1

交易号

项集合

T001

A,B,C,E

T002

A,D

T003

A,B,C

T004

A,B,D

T005

A,C,D

T006

B,C

T007

A,C

T008

A,B,C,E

T009

A,B,C

解答:

候选集

第1次扫描

产生候选集

第2次扫描

产生候选集

第3次扫描

支持度计数

生成频繁项集

支持度计数

生成频繁项集

支持度计数

生成频繁项集

A

B

C

D

E

5.在决策树分析中,已知输出变量U的先验信息熵计算公式为:

参考分组变量T1下U的后验条件熵计算公式为:

计算信息增益的计算公式为:

Rains(U,T1)=Ent(U)-Ent(U|T1)

设有如下训练数据,其中收入、性别、学历是输入变量,是否购房是输出变量。

试计算出第一次分枝时输入变量“收入”的信息增益。

表2决策树训练数据

收入

性别

学历

是否购房

<5000

男

大学

是

>=5000

女

大学

是

>=5000

男

高中

是

<5000

女

高中

否

<5000

男

大学

是

>=5000

女

高中

是

<5000

女

初中

否

>=5000

男

初中

否

<5000

女

大学

否

<5000

男

大学

是

其中:

已知log2(6/10)=-0.74,log2(4/10)=-1.32,log2(3/6)=-1,log2(3/4)=-0.42,log2(1/4)=-2

解答:

1)输出变量的信息熵I(10,6)=-((6/10)*log(6/10)+(4/10)*log(4/10))=0.972

2)条件熵E(收入)=(6/10)*I(6,3)+(4/10)*I(4,3)=

=0.6*[-(3/6)log(3/6)-(3/6)log(3/6)]+0.4[-(3/4)log(3/4)-(1/4)log(1/4)]=

=0.6*(0.5*1+0.5*1)+0.4*(0.75*0.42+0.25*2)=0.6+0.326=0.926

3)Gain(收入)=0.972-0.926=0.046

6..在决策树分析中,已知输出变量U的先验信息熵计算公式为:

参考分组变量T1下U的后验条件熵计算公式为:

计算信息增益的计算公式为:

Rains(U,T1)=Ent(U)-Ent(U|T1)

设有如下训练数据,其中收入、性别、学历是输入变量,是否购房是输出变量。

试计算出第一次分枝时输入变量“性别”的信息增益。

表2决策树训练数据

收入

性别

学历

是否购房

<5000

男

大学

是

>=5000

男

大学

是

>=5000

女

高中

是

<5000

男

高中

是

<5000

女

大学

是

>=5000

女

高中

是

<5000

女

初中

否

>=5000

男

初中

否

<5000

女

大学

否

<5000

男

大学

否

其中:

已知log2(6/10)=-0.74,log2(4/10)=-1.32,log2(1/5)=-2.32,log2(2/5)=-1.32,log2(3/5)=-0.74,log2(4/5)=-0.32

解答:

1)输出变量的信息熵I(10,6)=-((6/10)*log(6/10)+(4/10)*log(4/10))=0.972

2)条件熵E(性别)=(5/10)*I(5,3)+(5/10)*I(5,3)=

=0.5*[-(3/5)log(3/5)-(2/5)log(2/5)]+0.5[-(3/5)log(3/5)-(2/5)log(2/5)]=

3)Gain(性别)=0.972-0.846=0.126