南开大学《《网络爬虫与信息提取》20春期末考核.docx

《南开大学《《网络爬虫与信息提取》20春期末考核.docx》由会员分享,可在线阅读,更多相关《南开大学《《网络爬虫与信息提取》20春期末考核.docx(12页珍藏版)》请在冰豆网上搜索。

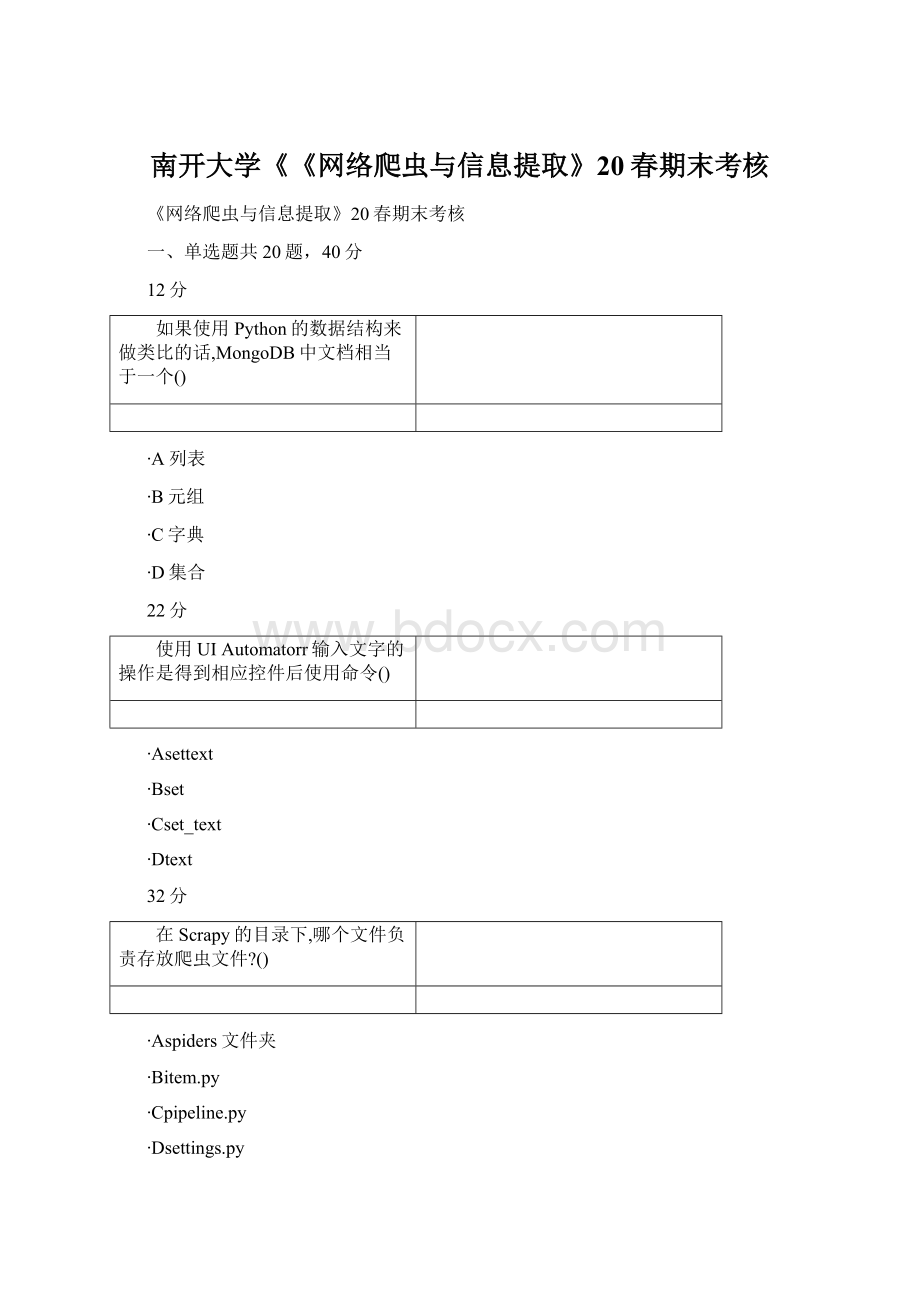

南开大学《《网络爬虫与信息提取》20春期末考核

《网络爬虫与信息提取》20春期末考核

一、单选题共20题,40分

12分

如果使用Python的数据结构来做类比的话,MongoDB中文档相当于一个()

∙A列表

∙B元组

∙C字典

∙D集合

22分

使用UIAutomatorr输入文字的操作是得到相应控件后使用命令()

∙Asettext

∙Bset

∙Cset_text

∙Dtext

32分

在Scrapy的目录下,哪个文件负责存放爬虫文件?

()

∙Aspiders文件夹

∙Bitem.py

∙Cpipeline.py

∙Dsettings.py

42分

HTTP常用状态码表明服务器正忙的是()

∙A500

∙B503

∙C403

∙D404

52分

如果很多爬虫同时对一个网站全速爬取,那么其实就是对网站进行了()攻击

∙AXSS

∙BDOS

∙CDDOS

∙D跨域

62分

使用UIAutomatorr判断元素是否存在的操作是得到相应控件后使用命令()

∙Aexist

∙Bexists

∙Cisnull

∙Dcontains

72分

带上通过Chrome浏览器从评论页面复制而来的()再发起请求,可以减少爬虫被网站封锁的概率

∙ACookie

∙BHtml

∙CHeaders

∙DCSS

82分

Redis中查看一个列表长度,使用关键字()

∙Alen

∙Blength

∙Cllen

∙Dcount

92分

使用Xpath获取文本使用()

∙Atext

∙Btext()

∙Ccontent

∙Dcontent()

102分

使用python定制mitmproxy,下面的语句请求的是()。

{req.headers["User-Agent"]}

∙Aheaders

∙B文本内容

∙C目标网站

∙Duser-agent

112分

Python中Object={1,2,3,4,5},则Objcet是()

∙A列表

∙B元组

∙C字典

∙D集合

122分

在Scrapy的目录下,哪个文件负责存放爬虫的各种配置信息?

()

∙Aspiders文件夹

∙Bitem.py

∙Cpipeline.py

∙Dsettings.py

132分

Redis是一个开源的使用()语言编写

∙AANSIC

∙BC++

∙CJAVA

∙DPython

142分

某些网站在发起Ajax请求时会携带()字符串用于身份验证

∙AToken

∙BCookie

∙CReqTime

∙Dsum

152分

使用UIAutomatorr点亮屏幕的操作是得到相应控件后使用命令()

∙Awakeup

∙Blight

∙Cbright

∙Dsleep

162分

Chrome的开发者工具中哪个选项可以查找到cookies

∙AElements

∙BSources

∙CNetwork

∙DPeformance

172分

Scrapy中使用Xpath获得的结果调用了.extract方法,结果以()形式生成

∙A列表

∙B元组

∙C字典

∙D集合

182分

以下哪个命令是创建文件夹命令()

∙Acurl

∙Btar-zxvf

∙Cmkdir

∙Dcp

192分

可以通过()绕过网站登录。

∙Asession

∙Bcookies

∙Cmoonpies

∙Dlocalstorage

202分

Python中把列表转换为集合需要使用函数

∙Aset

∙Blist

∙Cconvert

∙Dchange

二、多选题共5题,10分

12分

Python中的容器有()

∙A列表

∙B元组

∙C字典

∙D集合

22分

HTTP常用状态码表明表明服务器本身发生错误的有()

∙A403

∙B404

∙C500

∙D503

32分

Python中哪种容器生成后可以修改内容

∙A列表

∙B元组

∙C字典

∙D集合

42分

最常见的HTTP请求类型有()

∙AGET

∙BPOST

∙CSEND

∙DRECEIVE

52分

BS4可以用来从()中提取数据

∙AHTML

∙BXML

∙C数据库

∙DJSON

三、判断题共10题,20分

12分

在Linux的终端使用apt-get命令安装一系列依赖库时,其中如果存在有已经安装的库,会覆盖掉之前的库重新安装

∙A对

∙B错

22分

使用Nginx反向代理到Scrapyd以后,Scrapyd本身只需要开通内网访问即可,不许经过输入密码

∙A对

∙B错

32分

process_spider_output(response,result,output)是在下载器中间件处理完成后,马上要进入某个回调函数parse_xxx()前调用

∙A对

∙B错

42分

Robo3T与RoboMongo是完全不一样的软件

∙A对

∙B错

52分

Python正则表达式中“.*?

”是非贪婪模式,获取最短的能满足条件的字符串。

∙A对

∙B错

62分

Redis插入数据都是插入到列表右侧,因此读取数据也是从右侧读取

∙A对

∙B错

72分

爬虫登录需要识别验证码可以先把程序关闭,肉眼识别以后再重新运行

∙A对

∙B错

82分

在Ubuntu下若要运行Redis可以使用CMD进入解压以后的文件夹并运行命令redis-server.exeredis.windows.conf启动Redis

∙A对

∙B错

92分

middlewares.py是下载器中间件

∙A对

∙B错

102分

在charles中使用CTRL+F搜索,JSON里面的中文是可以直接搜索到的。

∙A对

∙B错

四、主观填空题共4题,8分

12分

使用了RedisSpider作为爬虫的父类以后,爬虫会直接监控中的数据,并不读取start_urls中的数据。

1、学生作答:

22分

一般通过表达式来解析网页数据

1、学生作答:

32分

实现异步加载需要利用技术

1、学生作答:

刷新

42分

Python中定义函数关键字为

1、学生作答:

def

五、简答题共2题,10分

15分

Python正则表达式中search和findall方法比较

∙

当前已输入0个字符,您还可以输入2000个字符。

∙

25分

在MacOS下安装Scrapy,当pip的网络受到干扰导致安装的速度很慢时,应该如何应对?

∙

当前已输入189个字符,您还可以输入1811个字符。

∙

六、名词解释共4题,12分

13分

multiprocessing

∙multiprocessing,英语单词,主要用作名词,作名词时译为“多重处理”。

当前已输入41个字符,您还可以输入1959个字符。

∙

23分

URI

∙在电脑术语中,统一资源标识符(UniformResourceIdentifier,URI)是一个用于标识某一互联网资源名称的字符串。

该种标识允许用户对任何(包括本地和互联网)的资源通过特定的协议进行交互操作。

URI由包括确定语法和相关协议的方案所定义。

当前已输入129个字符,您还可以输入1871个字符。

∙

33分

CSS

∙层叠样式表(英文全称:

CascadingStyleSheets)是一种用来表现HTML(标准通用标记语言的一个应用)或XML(标准通用标记语言的一个子集)等文件样式的计算机语言。

CSS不仅可以静态地修饰网页,还可以配合各种脚本语言动态地对网页各元素进行格式化。

当前已输入132个字符,您还可以输入1868个字符。

∙

43分

HTML

∙HTML称为超文本标记语言,是一种标识性的语言。

它包括一系列标签.通过这些标签可以将网络上的文档格式统一,使分散的Internet资源连接为一个逻辑整体。

HTML文本是由HTML命令组成的描述性文本,HTML命令可以说明文字,图形、动画、声音、表格、链接等。

∙