linux下安装hadoop.docx

《linux下安装hadoop.docx》由会员分享,可在线阅读,更多相关《linux下安装hadoop.docx(16页珍藏版)》请在冰豆网上搜索。

linux下安装hadoop

一、在Ubuntu下创建Hadoop组和hadoop用户

增加hadoop用户组,同时在该组里增加hadoop用户,后续在涉及到hadoop操作时,我们使用该用户。

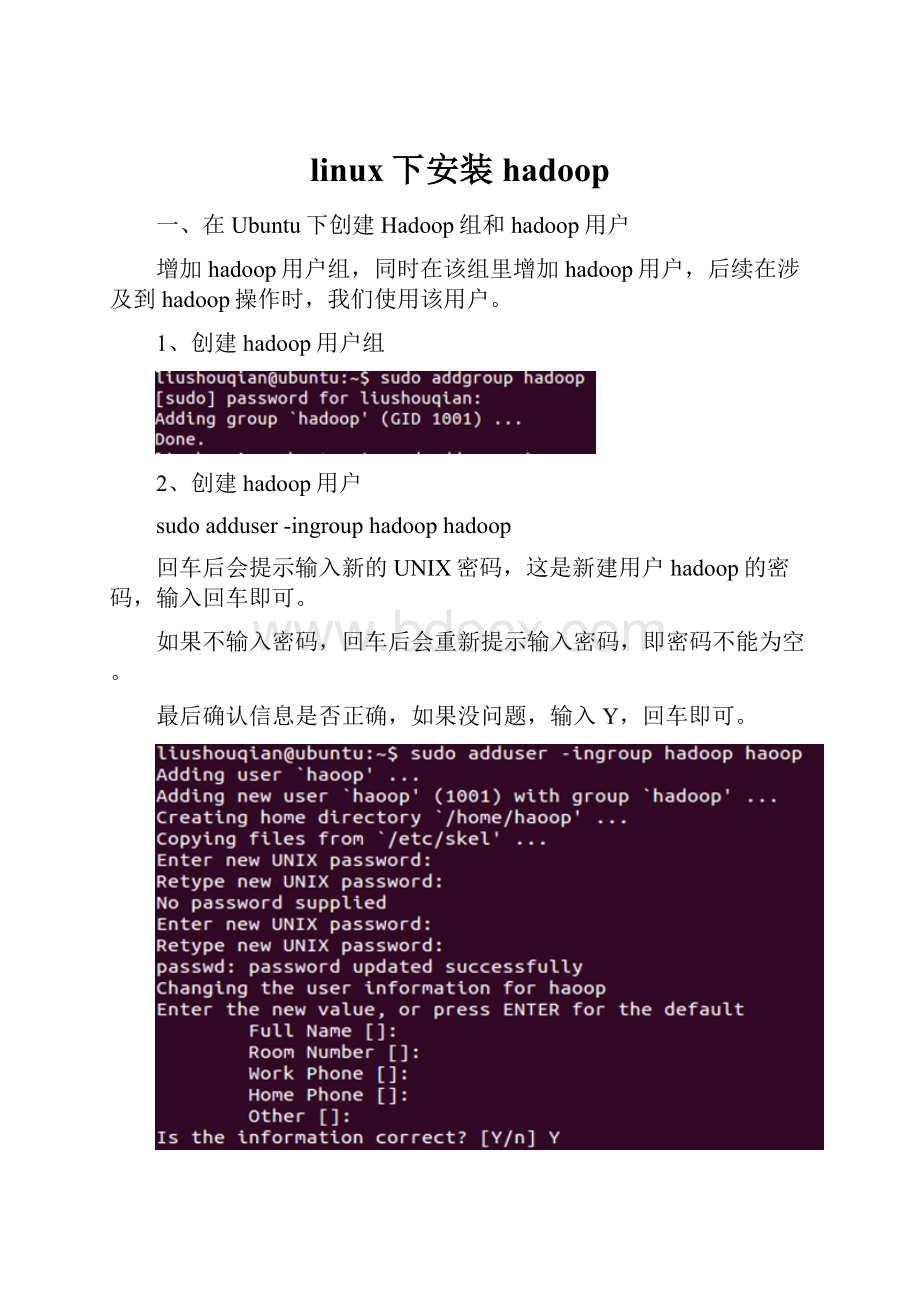

1、创建hadoop用户组

2、创建hadoop用户

sudoadduser-ingrouphadoophadoop

回车后会提示输入新的UNIX密码,这是新建用户hadoop的密码,输入回车即可。

如果不输入密码,回车后会重新提示输入密码,即密码不能为空。

最后确认信息是否正确,如果没问题,输入Y,回车即可。

3、为hadoop用户添加权限

输入:

sudogedit/etc/sudoers

回车,打开sudoers文件

给hadoop用户赋予和root用户同样的权限

二、用新增加的hadoop用户登录Ubuntu系统

三、安装ssh

sudoapt-getinstallopenssh-server

安装完成后,启动服务

sudo/etc/init.d/sshstart

查看服务是否正确启动:

ps-e|grepssh

设置免密码登录,生成私钥和公钥

ssh-keygen-trsa-P""

此时会在/home/hadoop/.ssh下生成两个文件:

id_rsa和id_rsa.pub,前者为私钥,后者为公钥。

下面我们将公钥追加到authorized_keys中,它用户保存所有允许以当前用户身份登录到ssh客户端用户的公钥内容。

cat~/.ssh/id_rsa.pub>>~/.ssh/authorized_keys

登录ssh

sshlocalhost

退出

exit

四、安装Java环境

sudoapt-getinstallopenjdk-7-jdk

查看安装结果,输入命令:

java-version,结果如下表示安装成功。

在Ubuntu14.04下安装Hadoop2.4.0(单机模式)基础上配置

一、配置core-site.xml

/usr/local/hadoop/etc/hadoop/core-site.xml包含了hadoop启动时的配置信息。

编辑器中打开此文件

sudogedit/usr/local/hadoop/etc/hadoop/core-site.xml

在该文件的之间增加如下内容:

fs.default.name

hdfs:

//localhost:

9000

保存、关闭编辑窗口。

最终修改后的文件内容如下:

二、配置yarn-site.xml

/usr/local/hadoop/etc/hadoop/yarn-site.xml包含了MapReduce启动时的配置信息。

编辑器中打开此文件

sudogedityarn-site.xml

在该文件的之间增加如下内容:

yarn.nodemanager.aux-services

mapreduce_shuffle

yarn.nodemanager.aux-services.mapreduce.shuffle.class

org.apache.hadoop.mapred.ShuffleHandler

保存、关闭编辑窗口

最终修改后的文件内容如下

三、创建和配置mapred-site.xml

默认情况下,/usr/local/hadoop/etc/hadoop/文件夹下有mapred.xml.template文件,我们要复制该文件,并命名为mapred.xml,该文件用于指定MapReduce使用的框架。

复制并重命名

cpmapred-site.xml.templatemapred-site.xml

编辑器打开此新建文件

sudogeditmapred-site.xml

在该文件的之间增加如下内容:

mapreduce.framework.name

yarn

保存、关闭编辑窗口

最终修改后的文件内容如下

四、配置hdfs-site.xml

/usr/local/hadoop/etc/hadoop/hdfs-site.xml用来配置集群中每台主机都可用,指定主机上作为namenode和datanode的目录。

创建文件夹,如下图所示

你也可以在别的路径下创建上图的文件夹,名称也可以与上图不同,但是需要和hdfs-site.xml中的配置一致。

编辑器打开hdfs-site.xml

在该文件的之间增加如下内容:

dfs.replication

1

dfs.namenode.name.dir

file:

/usr/local/hadoop/hdfs/name

dfs.datanode.data.dir

file:

/usr/local/hadoop/hdfs/data

保存、关闭编辑窗口

最终修改后的文件内容如下:

五、格式化hdfs

hdfsnamenode-format

只需要执行一次即可,如果在hadoop已经使用后再次执行,会清除掉hdfs上的所有数据。

六、启动Hadoop

经过上文所描述配置和操作后,下面就可以启动这个单节点的集群

执行启动命令:

sbin/start-dfs.sh

执行该命令时,如果有yes/no提示,输入yes,回车即可。

接下来,执行:

sbin/start-yarn.sh

执行完这两个命令后,Hadoop会启动并运行

执行jps命令,会看到Hadoop相关的进程,如下图:

浏览器打开 http:

//localhost:

50070/,会看到hdfs管理页面

浏览器打开http:

//localhost:

8088,会看到hadoop进程管理页面

七、WordCount验证

dfs上创建input目录

bin/hadoopfs-mkdir-pinput

把hadoop目录下的README.txt拷贝到dfs新建的input里

hadoopfs-copyFromLocalREADME.txtinput

运行WordCount

hadoopjarshare/hadoop/mapreduce/sources/hadoop-mapreduce-examples-2.4.0-sources.jarorg.apache.hadoop.examples.WordCountinputoutput

可以看到执行过程

运行完毕后,查看单词统计结果

hadoopfs-catoutput/*