云计算平台搭建方案样本.docx

《云计算平台搭建方案样本.docx》由会员分享,可在线阅读,更多相关《云计算平台搭建方案样本.docx(35页珍藏版)》请在冰豆网上搜索。

云计算平台搭建方案样本

Hadoop云计算平台搭建方案

一、平台搭建概述

1.1总体思路

针对于电网公司在营销服务领域展开大数据分析解决,搭建Hadoop云计算平台进行海量数据存储,并作深层次加工、解决,挖掘出无法简朴直观便可得到新模式,为电力公司决策提供指引。

平台采用Hadoop-2.2.0作为海量数据存储和分析工具,将其布置在4个物理计算机节点上,搭建Hadoop集群,其中1个节点作为master节点,别的3个作为slave节点。

为了获取更好稳定性,平台搭建在Linux系统(ubuntu-14.04-desktop-i386)环境下。

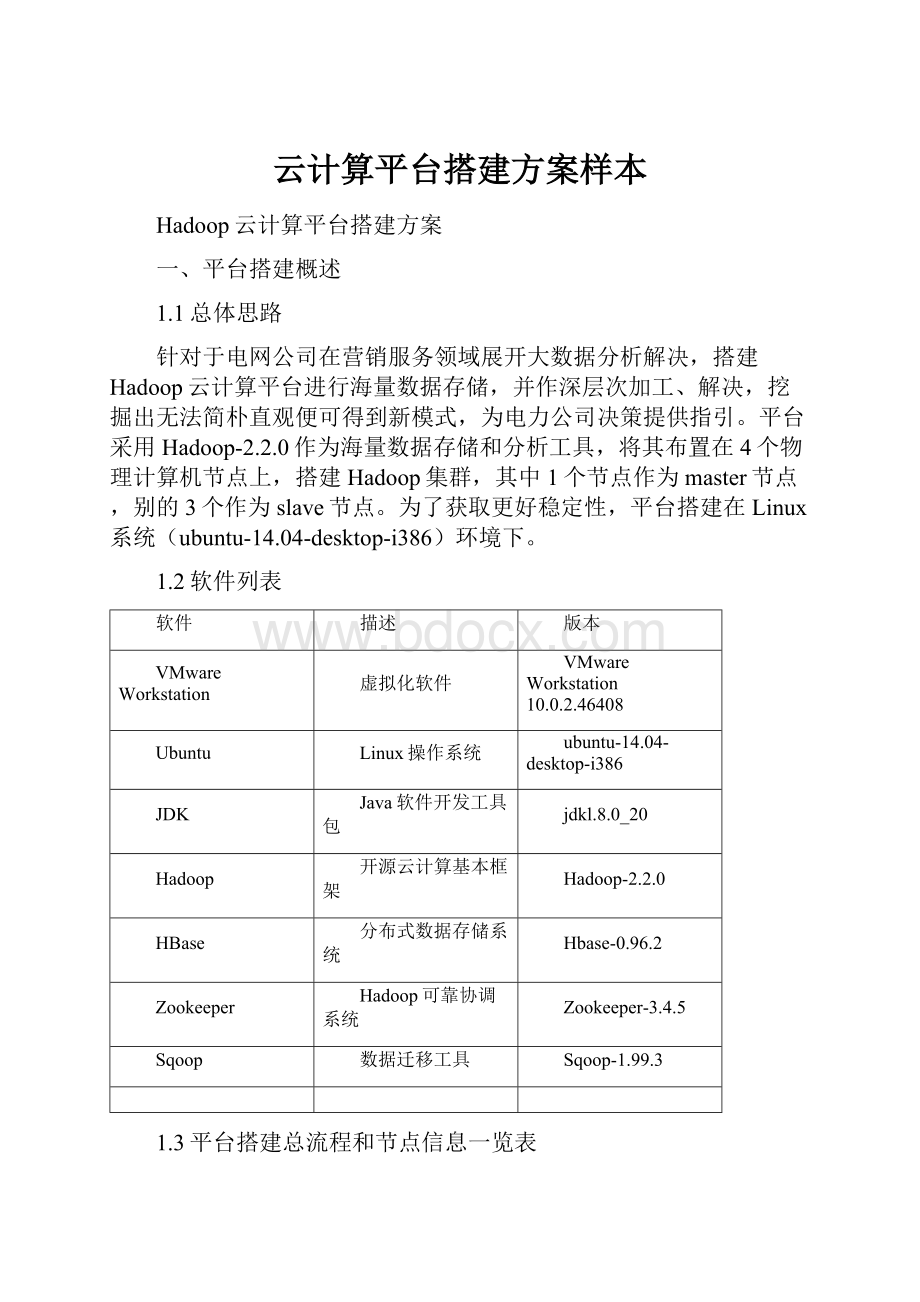

1.2软件列表

软件

描述

版本

VMwareWorkstation

虚拟化软件

VMwareWorkstation10.0.2.46408

Ubuntu

Linux操作系统

ubuntu-14.04-desktop-i386

JDK

Java软件开发工具包

jdkl.8.0_20

Hadoop

开源云计算基本框架

Hadoop-2.2.0

HBase

分布式数据存储系统

Hbase-0.96.2

Zookeeper

Hadoop可靠协调系统

Zookeeper-3.4.5

Sqoop

数据迁移工具

Sqoop-1.99.3

1.3平台搭建总流程和节点信息一览表

在平台搭建前,给出实现总流程图和节点信息一览表,从而对平台搭建过程和各节点信息有一种全局结识,平台搭建总流程如下图所示。

各节点信息如下表所示:

机器名

IP地址

顾客名

充当角色

master

172.19.17.102

hadoop

JobTracker、Namenode

slave1

172.19.17.104

hadoop

TaskTracker、Datanode

slave2

172.19.17.105

hadoop

TaskTracker、Datanode

slave3

172.19.17.106

hadoop

TaskTracker、Datanode

二、基本平台搭建环节

本次大数据存储和解决平台搭建,需要4台物理节点来布置Hadoop平台环境。

咱们使用虚拟机软件VMwareWorkstation创立4台虚拟机,承载平台搭建工作。

此外,由于对4台虚拟机配备大某些是相似,因此运用VMwareWorkstation克隆功能,可以减少布置工作量。

2.1安装虚拟机软件VMwareWorkstation

一方面在4台PC机器上均安装虚拟化软件VMwareWorkstation,并输入相应序列号。

2.2在master节点上安装Linux系统Ubuntu

在设定为masterPC节点上一方面安装Linux系统(版本为ubuntu-11.04-desktop-i386),在安装过程中为提高后期安装软件兼容性和稳定性,在系统语言上选取英语。

创立顾客名为“hadoop”普通顾客,设立统一密码。

安装完毕后将系统terminal命令窗口调出来,以便使用。

同步,为实现虚拟机Ubuntu系统与本机Windows系统之间以便快捷文字复制粘贴以及物理主机系统与虚拟机系统互相拖放文献进行共享,需要安装VMareTools工具,详细操作如下:

启动虚拟机,进入Ubuntu系统,在VM菜单栏“虚拟机(M)”下拉菜单点击“安装VMareTools(T)”后,会弹出一种“VMareTools”文献夹,里面包括VMareTools安装包VMwareTools-9.6.2-1688356.tar.gz,将该安装包拷贝到/home/hadoop目录下,输入命令进行解压安装:

tarxzvfVMwareTools-9.6.2-1688356.tar.gz

此时在/home/hadoop/目录下产生vmware-tools-distrib文献夹,进入该目录,通过在terminal终端输入相应命令,运营vmware-install.pl脚本:

cd/home/hadoop/vmware-tools-distrib//进入目录

sudo./vmware-install.pl//执行vmware-install.pl脚本

按提示多次“回车”直至显示安装成功信息,再重启系统即可。

在完毕上述操作后,为保障Hadoop集群各节点之间无障碍通信,需关闭系统防火墙。

在重启系统后,在terminal终端输入命令:

sudoufwdisable

当显示“Firewallstoppedanddisableonsystemstartup”时表达防火墙已关闭,若后续服务布置过程中机器重启无法实现节点之间互相通信,可尝试检查防火墙与否关闭。

2.3master节点JDK安装与配备

由于Hadoop底层实现是用JAVA语言编写,因而它运营离不开JAVA运营环境(JRE)支持,这就需要JDK。

JDK有各种更新版本,安装过程大体相似,这里选取安装近来更新版本jdkl.8.0_20。

先将安装文献jdk-8u20-linux-i586.gz拷贝到master节点目录/home/hadoop/下,在终端输入命令:

tarxzvfjdk-8u20-linux-i586.gz

进行解压安装,此时会产生文献夹“jdk1.8.0_20”,所得JDK安装途径为“/home/hadoop/jdk1.8.0_20”。

安装结束后打开/etc/profile文献,配备JDKclasspath:

在terminal终端键入命令:

sudogedit/etc/profile打开profile文献,在文献末尾加上如下语句:

#setjavaenvironment

exportJAVA_HOME=/home/hadoop/jdk1.8.0_20

exportJRE_HOME=/home/hadoop/jdk1.8.0_20/jre

exportCLASSPATH=.:

$JAVA_HOME/lib:

$JRE_HOME/lib:

$CLASSPATH

exportPATH=$JAVA_HOME/bin:

$JRE_HOME/bin:

$PATH///home/hadoop/是hadoop文献夹所在途径,不可照抄,要以实际途径为准

保存之后,在terminal终端输入命令:

source/etc/profile使其生效。

并键入命令java–version查看与否配备成功,若浮现如下信息,则表达java环境变量配备成功。

javaversion"1.8.0_20"

Java(TM)SERuntimeEnvironment(build1.8.0_20-b26)

JavaHotSpot(TM)ClientVM(build25.20-b23,mixedmode)

注:

以上灰色背景标注文字表达Linux命令,红色字体颜色标注文本表达需要写入Hadoop环境配备文献中信息,绿色字体颜色标注小5号文本表达注释,下同

2.4master节点hadoop安装与配备

Hadoop安装是Hadoop平台搭建核心环节,将从下载安装包hadoop-2.2.0.tar.gz拷贝到master节点目录/home/hadoop/下,进行解压安装,输入命令:

tarxzvfhadoop-2.2.0.tar.gz

安装完毕后配备环境变量:

在系统文献/etc/profile以及Hadoop安装目录/home/hadoop/hadoop-2.2.0文献夹下各种文献添加相应配备信息。

2.4.1添加环境变量

打开/etc/profile文献,在terminal终端键入命令:

sudogedit/etc/profile调出profile文献,在文献末尾加上:

#sethadoopenvironment

exportHADOOP_HOME=/home/hadoop/hadoop-2.2.0

exportPATH=$HADOOP_HOME/bin:

$PATH

exportPATH=$HADOOP_HOME/sbin:

$PATH

然后保存,在终端键入命令source/etc/profile使其生效。

异常解决1:

问题:

保存添加环境变量并使其生效后,terminal也许会浮现如下警告:

(gedit:

2949):

Gtk-WARNING**:

Attemptingtosetthepermissionsof`/root/.local/share/recently-used.xbel',butfailed:

Nosuchfileordirectory

(gedit:

2949):

Gtk-WARNING**:

Attemptingtostorechangesinto`/root/.local/share/recently-used.xbel',butfailed:

Failedtocreatefile'/root/.local/share/recently-used.xbel.MN6R3V':

Nosuchfileordirectory

(gedit:

2949):

Gtk-WARNING**:

Attemptingtosetthepermissionsof`/root/.local/share/recently-used.xbel',butfailed:

Nosuchfileordirectory

解决办法:

只需直接在终端中输入命令:

sudo mkdir -p /root/.local/share/ ,创立警告信息中所提示目录即可。

若无视警告重启ubuntu后将会浮现如下状况:

输入密码无法进入系统,始终处在输入密码后又跳转回输入密码界面。

此时解决办法是:

在输入密码界面同步按下alt+ctrl+F2进入ubuntu命令模式,并使用root顾客及相应密码登陆系统,然后键入:

/usr/bin/vi/etc/profile打开etc/profile文献,找到近来在末尾加上hadoop配备文献,按delete键删除这些行,然后键入命令:

wq!

(注意此处有冒号,不可省略)保存文献。

然后同步按下ctrl+alt+del重启系统即可使系统恢复正常登陆,然后按照上述办法重新配备。

2.4.2目录设立

在普通顾客hadoop下创立hadoop数据存储目录(若使用root顾客创立上述文献夹则会因权限问题导致无法向这些文献夹中写入并读取数据),可自行选取数据存储途径,咱们选取在/home/hadoop/文献夹下创立dfs和tmp作为数据存储与互换目录,并在dfs文献夹下创立name和data两个子文献夹。

分别执行命令:

mkdir/home/hadoop/dfs/name//创立/home/hadoop/下dfs子文献夹name

mkdir/home/hadoop/dfs/data//创立/home/hadoop/下dfs子文献夹data

mkdir/home/hadoop/tmp//创立/home/hadoop/tmp

2.4.3/home/hadoop/hadoop-2.2.0/etc/hadoop下配备文献修改

接下来在/home/hadoop/hadoop-2.2.0/etc/hadoop目录下需要修改如下文献内容:

在slaves文献下分别写入三个slave节点名称,完毕节点信息配备,并分别通过对hadoop-env.sh、core-site.xml、hdfs-site.xml、mapred-site.xml、yarn-site.xml、yarn-env.sh等文献分别进行Hadoop核心文献配备、HDFS配备、Mapreduce配备和Yarn配备。

对/home/hadoop/hadoop-2.2.0/etc/hadoop文献夹下几种文献做一定修改,配备每个文献时先单击文献右键,选取“openwithtexteditor”方式打开,按照如下方式修改,需要配备文献如下:

(1)配备hadoop-env.sh文献,打开该文献,检索“#exportJAVA_HOME=${JAVA_HOME}”文本,在该语句下一行添加:

exportJAVA_HOME=/home/hadoop/jdk1.8.0_20

这样配备目是为Hadoop守护进程设立环境变量,让Hadoop可以获取到JDK服务支持。

(2)配备slaves文献,打开该文献,将其内容修改为slave1、slave2、slave3。

文献名

打开后,将其内容修改为:

slaves

slave1

slave2

slave3

(3)配备core-site.xml文献,打开该文献,在文献末尾添加如下语句。

文献名

打开文献后,在其末尾添加语句:

core-site.xml

fs.defaultFS

hdfs:

//172.19.17.102:

9000

io.file.buffer.size

131072

hadoop.tmp.dir

file:

/home/hadoop/tmp

Abaseforothertemporarydirectories.

hadoop.proxyuser.tan.hosts

*

hadoop.proxyuser.tan.groups

*

(4)配备hdfs-site.xml文献,打开该文献,在文献末尾添加如下语句。

文献名

打开文献后,在其末尾添加语句:

hdfs-site.xml

dfs.namenode.secondary.http-address

172.19.17.102:

9001

dfs.namenode.name.dir

file:

/home/hadoop/dfs/name

dfs.datanode.data.dir

file:

/home/hadoop/dfs/data

dfs.replication

4

dfs.webhdfs.enabled

true

注意:

需要在hdfs-site.xml中配备dfs.replication属性时,dfs.replication属性指定HDFS中文献块复制份数,其默认值为3,当datanode节点少于3台便会报错。

在普通状况下,当其属性值为3时候,HDFS布置方略是在本地机柜中一种节点放置一种备份,在本地机柜不同结点再放置一种备份,然后再在另一种机柜中一种结点放置一种备份。

(5)配备mapred-site.xml文献。

事实上在进行配备之前,mapred-site.xml文献默认并不存在,需要一方面将该目录下mapred-site.xml.template文献进行复制,并重命名为mapred-site.xml,接下来打开mapred-site.xml,添加如下语句。

文献名

打开文献后,在其末尾添加语句:

mapred-site.xml

mapreduce.framework.name

yarn

mapreduce.jobhistory.address

172.19.17.102:

10020

mapreduce.jobhistory.webapp.address

172.19.17.102:

19888

(6)配备yarn-site.xml文献,打开该文献,在文献末尾添加如下语句。

文献名

打开文献后,在其末尾添加语句:

yarn-site.xml

--SitespecificYARNconfigurationproperties-->

yarn.nodemanager.aux-services

mapreduce_shuffle

yarn.nodemanager.aux-services.mapreduce.shuffle.class

org.apache.hadoop.mapred.ShuffleHandler

yarn.resourcemanager.address

172.19.17.102:

8032

yarn.resourcemanager.scheduler.address

172.19.17.102:

8030

yarn.resourcemanager.resource-tracker.address

172.19.17.102:

8031

yarn.resourcemanager.admin.address

172.19.17.102:

8033

yarn.resourcemanager.webapp.address

172.19.17.102:

8088

(7)配备yarn-env.sh文献,打开该文献,检索“#exportJAVA_HOME=/home/y/libexec/jdk1.6.0/”语句,在该语句下一行添加:

exportJAVA_HOME=/home/hadoop/jdk1.8.0_20

通过对上述文献修改,完毕对Hadoop配备。

事实上,配备过程并不复杂,普通而言,除了规定端口、IP地址、文献存储位置外,其她配备都不是必要修改,可以依照需要决定是采用默认配备还是自行修改。

尚有一点需要注意是以上配备都被默以为最后参数,这些参数都不可以在程序中被再次修改。

2.5Hadoop集群布置与各节点通信

2.5.1安装SSH服务

通过建立SSH无密码互访,可以实现Hadoop虚拟机群之间无密码登录互访。

在安装SSH服务之前,一方面需要更新软件源,并保证每台机器上都安装了SSH服务器,且都能正常启动。

更新软件源命令为:

sudoapt-getupdate

软件源更新完毕后,在terminal输入如下命令开始安装openssh-server:

sudoapt-getinstallopenssh-server

输入如下命令,检查openssh-server与否成功安装:

whichssh

如显示/usr/bin/ssh表达ssh安装成功

whichsshd

如显示/usr/bin/sshd表达sshd安装成功

如果以上两者都成功显示,表达open-server安装成功

2.5.2克隆虚拟机作为Slave节点

将上面配备好虚拟机作为master,关闭作为masterubuntu系统,然后修改虚拟机网络连接设立,改为“桥接模式”,即在master虚拟机主界面点击“虚拟机—设立—硬件—网络适配器”,在弹出对话“网络连接”项目下选取“桥接模式(B)”此举目在于使主节点和各从节点都能连上网络,从而使各台机器之间可以互访。

接下来对master进行克隆,得到slave1、slave2、slave3雏形,即点击VM菜单下“虚拟机—管理—克隆”,进入克隆虚拟机向导界面,依照向导提示,在“克隆类型”引导界面选取“创立完整克隆”,详细设立如下图所示:

然后输入被克隆虚拟机名称,先暂输入slave1,点击确认进行克隆,将克隆好系统复制到除master之外三台PC节点上,用虚拟机VMware辨认并将其启动,并在虚拟机启动界面点击“虚拟机—设立—选项—常规”设立中,分别修改虚拟机名称为slave1、slave2和slave3,如下图所示。

2.5.3设立IP地址

在Hadoop平台上,各个节点之间互访是基于TCP/IP合同,因此要为各个节点分派IP地址。

在四个PC节点上,点击桌面右上角从左到右第一种数据连接图标

在下拉菜单中选取最后一项“EditConnections…”

在弹出“NetworkConnections”框中选取“Edit…”,显示“EditingEthernetconnection1”框,点击“IPv4Settings”将弹出Method选取框设立为Manual,然后添加IP地址。

添加同一网关内IP地址、子网掩码、默认网关,目是让各个节点机器可以互访。

需要注意是在设立IP地址时,需要一方面在DNSservers输入相应IP地址,否则无法填写“Addresses”项内容。

因而,咱们将DNS服务器(DNSservers)地址设立为:

202.96.128.166,接下来将master节点IP地址(Address)设立为:

172.19.17.102,子网掩码(Netmask)设立为:

255.255.255.0,默认网关(Gateway)设立为:

172.19.17.1。

用同样办法,将虚拟机salve1