Faster RCNN的交通场景下行人检测方法Word格式.docx

《Faster RCNN的交通场景下行人检测方法Word格式.docx》由会员分享,可在线阅读,更多相关《Faster RCNN的交通场景下行人检测方法Word格式.docx(14页珍藏版)》请在冰豆网上搜索。

中图分类号:

TP306

文献标识码:

A

文章编号:

1672-7800(2020)004-0067-04

PedestrianDetectionMethodinTrafficSceneBasedonFasterRCNN

XUXiang-qian,SUNTao

(kSchoolofMech.anicalEngi,zeering,Univer.sityofSh.angh.aiforScienceandTech.nology,Sharzgh.ai200093,China)Abstract:

Inordertoiiuprovetheaccuracyandrobustnessofpedestriandetection,aimingattheproblemsof'

lowaccuracyandpoorre-al-timeperforruanceofexistingpedestriandetectionmethods.fastneuralnetworkoffastregionconvolutionintargetdetectionalgo-rithmisref'

erred.Firstly,K-meansalgorithruisusedtoobtaintheappropriateaspectratio.thenthestructureofregionproposalnet-work(RPN)isimprovedtoreducetheamountofcalculations.ByconlparingtheperformanceofMobileNet.VGG16.andResNet50featureextractionnetworks.animproveddetectionmethodoftrafficscenebasedonFasterRCNNisproposed.andtheimprovedalgo-rithmistrainedandtestedontheCaltech-NEWdataset.Theexperimenfalresultsshouwthatthemethodgreatlyimprovesthereal-timeandaccuracyofdetectionintrafficscenes.ThemAP(meanAveragePrecision)onthetestsetis87.5%.andthedetectionspeedofasinglepictureis0.187seconds.Comparedwithothermethods.thismethodisbetter.KeyWords:

convolutionalneuralnetwork;

pedestriandetection;

K-meansalgorithm;

RPN

O引言

交通場景下行人检测是指在交通场景下,判断图像或者视频序列中是否包含行人目标并准确判断出行人位置。

行人检测是目标检测中非常重要的课题,基于卷积神经网络的行人目标检测方法是国内外学者的研究热点,行人检测算法在高级驾驶辅助系统(ADAS)、智能驾驶系统、智能机器人、行人数据分析等领域有着重要应用“。

传统的目标检测方法将SIFT[2](Scale-InvariantFea-tureTransform)、HOG[3](histogramoforientedgradient)等传统人工提取的特征算子传人SVM[4]。

(SupportVectorMa-chine)、AdaBoost等分类器进行分类并完成目标检测。

在现实生活中,人类是一个刚性和柔性相结合的物体,在受到光照、姿态、尺寸等因素v影响时,传统人工提取的特征算子往往不能满足行人检测要求,存在泛化能力弱、准确度低等缺点[5]。

近年来,以卷积神经网络为代表的深度学习算法在图片分类、目标检测等领域取得了巨大成功。

基于卷积神经网络的深度学习目标检测方法相比于人工设计特征算子的传统方法,其能够自主学习图片不同层级的不同特征,提取图片中更加丰富、更加抽象的特征[6]。

目前,深度学习算法中最有代表性的算法有RCNN[7]、FastRCNN.sJ、FasterRCNN[9]。

、YOLO[10]等。

在这些算法中,整体可以归为两类,第一类是以R-CNN为代表的卷积神经网络,其采用两步式(Two-Stage)[11].首先会找出图片中目标可能出现的位置,即区域提议(RegionProposal),然后利用特征层提取的特征信息对目标作分类,这类检测器的优点是检测准确率高,问题是无法达到实时性要求;

第二类是以YOLO为代表的卷积神经网络,采用端到端(End-to-End)的方式[12],将目标检测任务转化为回归问题,这类检测器的实时性显著提高,但是准确率不如FasterRCNN等两步式检测器[13]。

本文基于FasterRCNN目标检测算法,使用K-means聚类算法得出适合交通场景下的行人锚框宽高比,优化区域提议网络RPN),然后将MobileNet[14]、VGG16[15]、ResNet50分别作为特征提取网络,对比3种特征提取网络对行人检测模型准确率的影响。

在此基础上,提出改进的FasterRCNN的交通场景下行人检测方法,并研究对比不同模型在不同行人数据集上的行人检测能力。

1基于FasterRCNN的行人检测方法

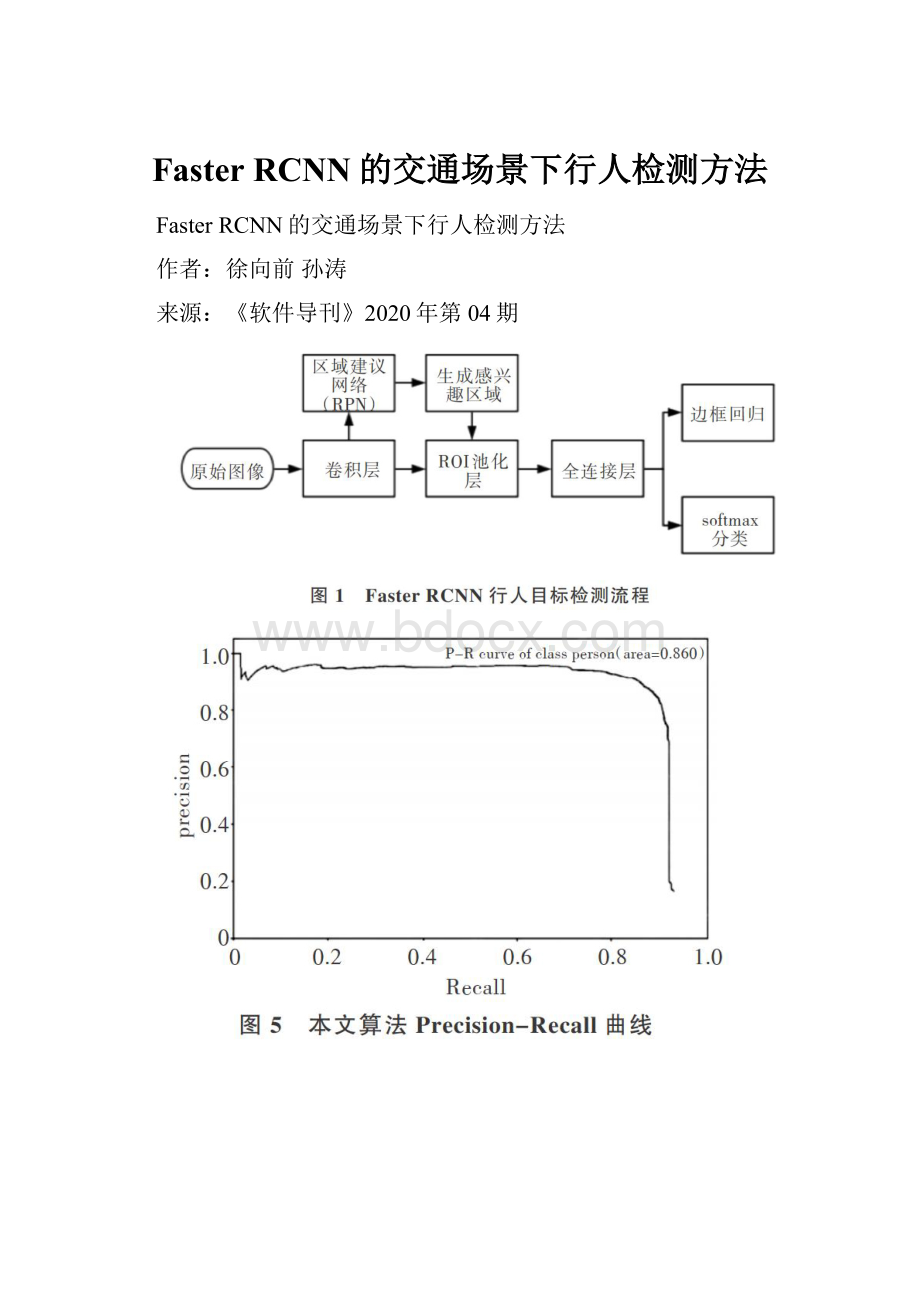

FasterRCNN目标检测算法流程如图1所示。

整个过程分为输入原始图像、通过特征提取网络提取特征,利用区域建议网络生成初步候选区域、利用检测网络进行行人分类和回归计算得到行人位置框等过程[16]。

FasterRCNN为了得到初步候选区域,运用区域建议网络自动生成候选区域,将特征网络提取的特征图作为区域建议网络的输入,区域建议网络将输出初步的目标候选矩形框。

为了生成候选区域,在特征网络提取的特征图上使用一个nXn的滑动窗口(卷积核)以一定的步长滑动。

区域建议网络是一个全卷积网络,由分类和窗口回归两部分组成,在分类层输出2xh个得分,主要用于判断候选区域中的目标所属类别(行人或者背景)。

候选区域与真实值(groundtruth)重叠部分面积超过阈值0.7,则被判定为存在行人目标,此时被判定为背景,其余忽略不计。

在回归层会根据输入的候选区域得到4xk个坐标位置,用于微调候选框。

FasterRCNN引入锚框机制(Anchors),FasterRCNN的锚框具有不同的尺度和比例,3种尺度大小分别为128、256、512以及3种宽高比分别为1:

1、1:

2、2:

1。

2改进的行人检测方法

2.1区域建议网络(RPN)改进

FasterRCNN网络能够白动提取训练集样本的特征信息,对位移、尺度等具有一定的不变性,在检测目标时有较好的检测精度和较快的检测速度[17]。

但FasterRCNN网络在检测行人目标时存在众多影响网络检测实时性和识别准确率的因素,FasterRCNN网络并不能完全满足交通场景下行人检测任务实时性和准确率的要求[18]。

其存在如下缺点:

①交通场景下,行人检测需要较高的实时性,Fast-erRCNN检测行人目标的实时性不足;

②FasterRCNN检测行人目标的检测精度较差。

本文利用K-means算法计算出合适的锚框宽高比,优化区域建议网络结构,提高准确率与实时性。

建立Caltech-NEW行人数据集用于训练模型,提高模型准确率和泛化能力。

区域建议网络的锚框参数设置忽略了行人目标的特殊性。

在绝大多数交通场景下,行人目标都是高度大于寬度,因此设置不同宽高比的锚框对交通场景下的行人目标而言是一种干扰,锚框宽高比应该根据实际情况确定。

2.2锚框聚类分析

通过K-means聚类算法统计Caltech-NEW行人数据集中全部行人目标位置框的真实值(GroundTruth)。

将行人目标框真实值的宽高比作为样本i,聚类目标是找到每个样本潜在的类别v,并将同类v的样本i放在一起。

算法具体步骤如下:

Stepl:

随机选取k=2、3,聚类中心点为:

Step2:

对于每一个样本i,计算其历属类别:

Step3:

对于每一个类i,计算该类的中心:

Step4:

重复以上过程直到收敛。

K-means聚类算法随机计算K个类中心作为起始点。

如图2所示,聚类算法会将宽高比样本i分配到离其最近的类中心,根据收敛结果移类中心,重复直至类中心不再改变或者达到限定迭代次数。

如图3所示,聚类分析得出交通场景下行人目标宽高比为w-0.4lh,本文将原FasterRCNN算法中区域建议网络锚框的宽高比修改为(0.41:

1),修改之后的每个位置就有3个Anchor,分类层输出6个节点,回归层输出12个节点。

3实验分析

3.1实验平台

本文实验以上海理工大学智能车为平台,使用单目摄像头在阴天、雨天、夜晚等多种天气和环境下采集行人数据。

3.2实验数据集

实验使用的数据集由两个部分组成:

①加州理T学院的CaltechPedestrianDataset公共数据集。

[19];

②上海理工大学智能车平台采集的真实交通场景行人数据集。

本次实验所用的数据集命名为Caltech-NEW数据集,数据集共包含约16000张图片。

为了提高泛化能力,在Caltech数据集的基础上加入上海市区以及校园内采集的大量符合汽车行车视角的行人图片,分别包含:

晴天、雨天、阴天、雪天、夜晚。

图片尺寸为640x480,数据集图像示例如图4所示。

3.3实验评价方法

本文引进准确率和召回率以更好地评价模型,如式(3)、式(4)所示。

准确率=

召回率=

式中,TP代表正确地检测出了行人,FP代表将其它目标当作行人,FN代表将行人当作其它目标,TN代表没有检测出行人目标。

假设Ⅳ个样本,其中M个正例,可以得到M个召回率:

,对于每个召回率r,其最大准确率如式(5)所示。

(AveragePrecision)[20]用以衡量模型在每个类别上的好坏,衡量模型在所有类别上检测性能的高低,计算如式(6)所示。

由于本文只对行人目标这一个类别进行检测,因此m.AP和AP的值相等。

3.4训练过程

本次实验硬件配置是InterCorei7处理器,内存8GB,GPU为英伟达QuadroP4000。

采用的编程环境是Pvthon,基于深度学习框架Tensorflow,网络架构分别以MobileNet、VGG16、ResNet50为基础,最大迭代次数为70000次,学习率为0.001,权值衰减值设置为0.0005,训练30000轮之后开始衰减学习率,动量值设置为0.9。

将Caltech-NEW行人数据集的80%作为训练集,20%作为测试集,通过迭代训练调优,得到最佳网络模型。

4实验结果分析

锚框是区域建议网络的核心,原FasterRCNN算法由于目标大小和宽高比不一致,需要多个尺度的锚框组合,但在本文算法中并不需要如此。

本文采用对数据集目标框进行聚类分析得到更加适合行人目标检测的锚框个数和宽高比,使得锚框数量变得较少,缩短了计算时间,加快了检测速度。

为了比较RPN网络调整Anchor宽高比对训练结果的影响,在PASCALVOC2007数据集上训练评估FasterRCNN算法和本文算法,分别训练30000轮。

如表1所示,本文改进算法检测率优于原FasterRCNN算法,准确率提高了4.1%。

实验结果表明,本文提出的改进算法对于行人检测具有有效性,并提高了准确率。

表2为在Caltech-NEW交通场景数据集测试集上的单张图片检测耗时结果。

可以看出,本文算法在改进Fast-erRCNN后,检测所用时间优于未改变的FasterRCNN检测算法。

使用改进的RPN使得初步矩形目标候选区域减少,这是一种简单有效的解决方案,使用了GPU加速,减少了训练时间。

实验结果表明,本文算法有效提高了行人检测的实时性。

为了对比不同特征提取网络对算法准确率的影响,分别采用MobileNet、ResNet50、VGG16特征提取网络与本文改进算法相结合,在Caltech-NEW行人数据集上分别训练行人目标检测模型。

如表3所示,在0-30000轮迭代次数,本文算法训练得出的检测模型随着迭代次数的增加,mAP值快速提升并趋于稳定;

在迭代次数为30000轮时,准确率达到0.85左右,之后随着迭代次数的增加,准确率略有波动,但总体上保持不变。

这表明本文算法所得出的3种模型在迭代30000次时其检测性能基本都达到了较好水平。

继续训练达到70000轮迭代后,各特征提取网络都出现不同程度的准确率下降。

综上所述,采用VGG16、ResNet50为特征提取网络时,本文算法得出的检测模型效果较佳,当迭代次数超过30000轮时,采用MoblieNet为特征提取网络效果最好。

本文算法得出的检测模型Loss曲线随着训练迭代次数的增加,检测模型性能基本保持不变,在超过70000迭代次数之后,模型没有出现过拟合现象。

由图5可知,本文的算法在召回率小于0.8时,模型准确率处于0.95左右。

在Caltech-NEW数据集测试集上mAP值为0.860,相较于原FasterRCNN算法在行人目标的准确率0.702,采用改进后的FasterRCNN算法准确率大幅提高。

在不同的交通环境场景下,采用本文算法在Caltech-NEW数据集测试集中的部分检测结果如图6所示。

5结语

随着智能驾驶的不断发展,保障行人安全一直是智能驾驶研究人员的共同目标,行人目标相较于交通场景下其它目标显得尤为重要。

针对已有的目标检测算法在行人检测中检测准确率不佳、检测速度较慢、区域建议网络锚框设置不合理等缺点,以FasterRCNN为基础,提出了交通场景下改进的行人检测算法,根据行人目标在图像中呈现宽高比相对固定的规律,通过K-means聚类算法优化RPN区域建议网络,设置合理的anchor数量和宽高比,综合比较3种不同特征提取网络对算法准确率的影响,白建Caltech-NEW数据集,提高模型在交通场景下检测行人目标的泛化能力。

通过实验验证,本算法准确率和实时性都较高,证明Anchor框对算法准确率有一定的积极影响。

[1]许言午。

曹先杉,乔红,行人检测系统研究新进展及关键技术展望[j],电子学报,2008.36(5):

368-376.

[2]BAYH,ESSA,TLTYELAARST.etal.Speeded-uprohustfeatures(SURF)[J].ComputerVisionandImageLnderstanding,2008,110(3):

346-359.

[3]DALALN,TRIGGSB.Histogramsoforientedgradientsforhumande-tection[C].2005IEEEComputerSocietyConferenceonComputerVi-sionandPatternRecognition,2005:

886-893.

[4]]VIOLAP.JPNESM.Robustreal-timeobjectdetectinn[j].Interna-tionalJournalofComputerVision.2001,4:

34-47.測研究综述[J].动化学报.200733(I):

84-90.

[6]CERONIMOD,LOPEZA.SAPPAA,etal.Surveyofpedestriande-tectionforad.anc.eddriverassistancesystems[J].IEEETrans.onPatternAnalysisandMachineIntelligence,2010,32(7):

1239-1258.

[7GIRSHICKR.DONAHUEJ.DARRELLT.etal.Richfeaturehierar-chiesforaccurateobjectdetectionandsemanticsegmentation[c].Pro-ceedingoftheIEEEConferenceonComputerVisionandPatternRec-ognition,2014:

580-587.

[8]GIRSHICKR.FastR-CNW[c].Santiago:

2015lEEEInternationalConferenceonComputerVision,2015.

[9]REWS,HEK.CIRSHICKR.etal.FasterR-CNN:

towardsreal-timeohjectdetectionwithregionproposalnetworks[j].IEEETransactionsonPatternAnalysis&

-MachineIntelligenc.e,2017,39(6):

1137-1149

[10]REDMONJ,DIVVALAS,GIRSHICKR,etal.Youonlvlookonce:

unified,real-timeobjectdetection[c].PrriceedingsoftheIEEECon-ferenceonComputerVisionandPatternRecognition,2016:

779-788.

[11]杜友田,陳峰,徐文立,等.基于视觉的的运动别综述.电子学报,2007,35

(1):

84-90.

[12]苏松志.行人检测若干关键技术术研究[D].厦门:

厦门大学,2011.

[13]REILLYV,SOLMAZB.SHAHM.Geometricconstraintsforhumandetectioninaerialimagery[C].ThellthEuropeanconferenc:

eonComputer,'

ision,2010:

252-265.

[14]HOWARDAC.ZHUM.CHENB,etal.Mobilenetsefficientconvn-lutionalneuralnetworksformohilevisionapplications[DB/OL].arX-ivpreprintarXir:

1704.04861.2017.

[15]SIMONYAhrK,ZISSERMANA.Verydeepconvr)lutionalnetworksforlarge-scaleimagerecongnition[R].ComputerResearchReposito-rv.2014.

[16]DOLLARP,BELOhrCIES.PERONrAP.Thefastestpedestriandetec-torinthewest[C].ProceedingsonBritishMachineVisionCnnfer-ence(BMVC2010).2010:

1-11.

[17]WOJEKC,B.SCHIELE.Aperformanceevaluatinnofsingleandmulti-featurepeopledetection[C].AnnualSymposiumoftheDeutsche-Arheitsgemeinschaft-fur-Mustererkennung,2008:

82-91.

[18]OJALAT,PIETIKAINENM.HARWOODD.AcomparativestudyoftexturemeasureswithclassificationbasedONfeaturedistributions[J].PatternRecognition,1996,19(3):

51-59.

[19]DOLLARP,WOJEKC.SCHIELEB.etal.Pedestriandetection:

anevaluatir)nofthestateoftheart[J].IEEETransactionsonPatternAnalysisandMachineIntelligence,2012,34(4):

743-761.

[20]HENDERSONP.