机器学习基于实例的学习.ppt

《机器学习基于实例的学习.ppt》由会员分享,可在线阅读,更多相关《机器学习基于实例的学习.ppt(46页珍藏版)》请在冰豆网上搜索。

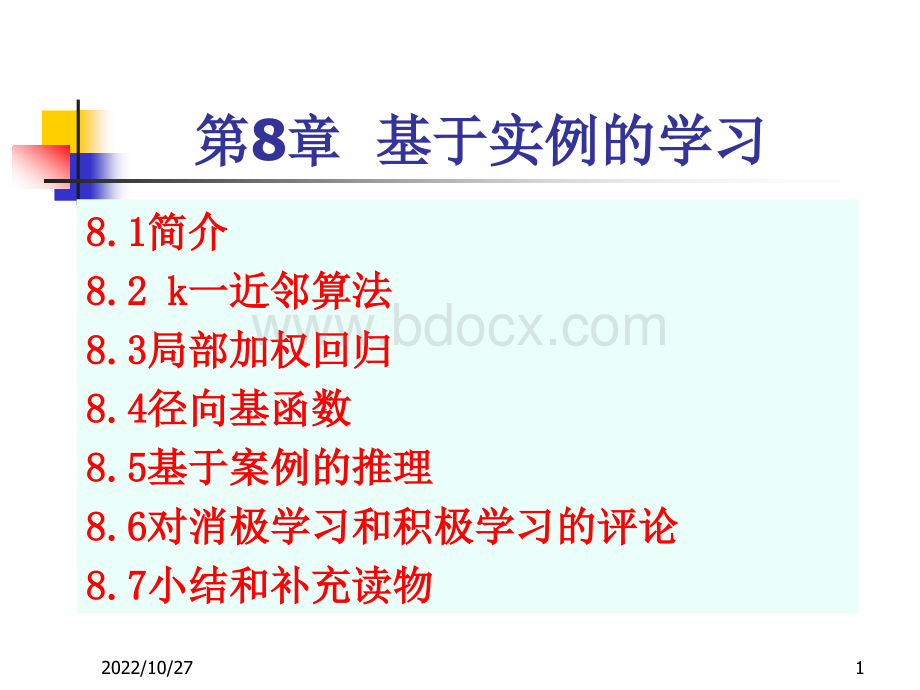

2022/10/271第第8章章基于实例的学习基于实例的学习8.18.1简介简介8.2k8.2k一近邻算法一近邻算法8.38.3局部加权回归局部加权回归8.48.4径向基函数径向基函数8.58.5基于案例的推理基于案例的推理8.68.6对消极学习和积极学习的评论对消极学习和积极学习的评论8.78.7小结和补充读物小结和补充读物2022/10/2728.1简介(简介(1/3)n思想:

思想:

基于实例的学习方法基于实例的学习方法先把训练样例存储起来。

泛化的先把训练样例存储起来。

泛化的工作被推迟到必须分类新的实例时。

每当学习器遇到一个新的工作被推迟到必须分类新的实例时。

每当学习器遇到一个新的查询实例,它分析这个新实例与以前存储的实例的关系,并据查询实例,它分析这个新实例与以前存储的实例的关系,并据此把一个目标函数值赋给新实例。

此把一个目标函数值赋给新实例。

n基于实例的学习方法有时被称为基于实例的学习方法有时被称为消极消极(lazy)(lazy)学习法,因为它学习法,因为它们把处理工作延迟到必须分类新的实例时。

与其相对的方法称们把处理工作延迟到必须分类新的实例时。

与其相对的方法称为积极的(为积极的(eager)eager)。

n延迟的或消极的学习方法有一个延迟的或消极的学习方法有一个关键的优点关键的优点,即它们不是在,即它们不是在整个实例空间上一次性地估计目标函数,而是针对每个待分类整个实例空间上一次性地估计目标函数,而是针对每个待分类新实例作出局部的和相异的估计。

新实例作出局部的和相异的估计。

2022/10/2738.1简介(简介(2/3)n基于实例的学习方法基于实例的学习方法包括最近邻法包括最近邻法(nearest(nearestneighborNN)neighborNN)和局部加权回归和局部加权回归(locally(locallyweightedregressionLWR)weightedregressionLWR)法法,它们都假定实,它们都假定实例可以被表示为欧氏空间中的点。

例可以被表示为欧氏空间中的点。

n基于实例的学习方法基于实例的学习方法还包括基于案例的推理还包括基于案例的推理(case-basedreasoningCBR(case-basedreasoningCBR)它对实例采用)它对实例采用更复杂的符号表示。

更复杂的符号表示。

2022/10/2748.1简介(简介(3/3)n基于实例方法的基于实例方法的一个不足一个不足是,分类新实例的开销可能很大。

是,分类新实例的开销可能很大。

这是因为几乎所有的计算都发生在分类时,而不是在第一次遇这是因为几乎所有的计算都发生在分类时,而不是在第一次遇到训练样例时。

所以如何到训练样例时。

所以如何有效地索引训练样例有效地索引训练样例,以减少查询时,以减少查询时所需的计算是一个重要的实践问题。

所需的计算是一个重要的实践问题。

n第二个不足第二个不足是是(尤其对于最近邻法尤其对于最近邻法),当从存储器中检索相似,当从存储器中检索相似的训练样例时,它们一般考虑实例的的训练样例时,它们一般考虑实例的所有属性所有属性。

如果目标概念。

如果目标概念仅依赖于很多属性中的几个时,那么真正最仅依赖于很多属性中的几个时,那么真正最“相似相似”的实例之的实例之间很可能相距甚远间很可能相距甚远。

2022/10/2758.2k一近邻算法(一近邻算法(1/5)nkk一近邻算法一近邻算法假定假定所有的实例对应于所有的实例对应于nn维空间维空间RRnn中的点。

中的点。

n一个实例的一个实例的最近邻最近邻是根据是根据标准欧氏距离标准欧氏距离定义的。

即把任意实定义的。

即把任意实例例xx表示为下面的表示为下面的特征向量特征向量:

a(x)其中其中,a,arr(x)(x)表示实例表示实例xx的第的第rr个属性值。

个属性值。

那么,两个实例那么,两个实例xxii和和xxjj间的距离间的距离定义为定义为d(xd(xii,x,xjj),其中,其中:

2022/10/276逼近离散值函数逼近离散值函数的的k-近邻算法近邻算法KNN训练算法训练算法:

对于每个训练样例对于每个训练样例,把这个样例加人列表,把这个样例加人列表training_examplestraining_examples。

分类算法分类算法:

n给定一个要分类的查询实例给定一个要分类的查询实例xxqq。

n在在training_examplestraining_examples中中选出最靠近选出最靠近xxqq的的kk个实例个实例,并用,并用xx11,xxkk表示。

表示。

n返回返回其中,如果其中,如果a=b,a=b,那么那么(a(a,b)=lb)=l,否则,否则(a(a,b)=0b)=0。

就是距离就是距离xxqq最近的最近的kk个训练样例中个训练样例中最普遍的最普遍的分分ff值。

值。

2022/10/2778.2k一近邻算法(一近邻算法(2/5)下图图解了一种简单情况下的下图图解了一种简单情况下的kk一近邻算法一近邻算法,在这里实例是,在这里实例是二维空间中的点,目标函数具有布尔值。

正反训练样例用二维空间中的点,目标函数具有布尔值。

正反训练样例用“+”和和“-”分别表示。

图中也画出了一个查询点分别表示。

图中也画出了一个查询点xxqq。

11一近邻算法一近邻算法把把xxqq分类为正例,然而分类为正例,然而55一近邻算法一近邻算法把把xxqq分类为反例。

分类为反例。

2022/10/2788.2k一近邻算法(一近邻算法(3/5)k-k-近邻算法隐含考虑的近邻算法隐含考虑的假设空间假设空间HH的特性的特性:

nk-k-近邻算法近邻算法并不形成关于目标函数并不形成关于目标函数ff的明确的一般假的明确的一般假设设。

它仅在需要时计算每个新查询实例的分类。

它仅在需要时计算每个新查询实例的分类。

n隐含的一般函数隐含的一般函数是什么是什么?

或者说,如果保持训练样例或者说,如果保持训练样例不变,并用不变,并用XX中的每个可能实例查询算法,会得到什么中的每个可能实例查询算法,会得到什么样的分类样的分类?

2022/10/2798.2k一近邻算法(一近邻算法(4/5)下图画出了下图画出了11一近邻算法一近邻算法在整个实例空间上导致的决策面形在整个实例空间上导致的决策面形状。

状。

决策面是围绕每个训练样例的凸多边形的合并。

决策面是围绕每个训练样例的凸多边形的合并。

对于每个对于每个训练样例,多边形指出了一个查询点集合,它的分类完全由相训练样例,多边形指出了一个查询点集合,它的分类完全由相应训练样例决定。

在这个多边形外的查询点更接近其他的训练应训练样例决定。

在这个多边形外的查询点更接近其他的训练样例。

这种类型的图经常被称为这个训练样例集合的样例。

这种类型的图经常被称为这个训练样例集合的VoronoiVoronoi图图(梯森多边形)。

(梯森多边形)。

2022/10/27108.2k一近邻算法(一近邻算法(5/5)对对kk一近邻算法作简单的修改,它可被用于一近邻算法作简单的修改,它可被用于逼近逼近连续值连续值的目标函数。

让算法计算的目标函数。

让算法计算kk个最接近样例的个最接近样例的平平均值均值,而不是计算其中的最普遍的值。

更精确地讲,而不是计算其中的最普遍的值。

更精确地讲,为了逼近一个实值目标函数为了逼近一个实值目标函数,我们使用公我们使用公式式:

2022/10/27118.2.1距离加权最近邻算法距离加权最近邻算法(1/3)对对kk一近邻算法的一个一近邻算法的一个改进改进是对是对kk个近邻的贡献加权个近邻的贡献加权,根据它们,根据它们相对查询点相对查询点xxqq的距离,将较大的权值赋给较近的近邻。

的距离,将较大的权值赋给较近的近邻。

n在在逼近离散目标函数的算法中逼近离散目标函数的算法中,可以根据每个近邻与,可以根据每个近邻与xxqq的距离平的距离平方的倒数加权这个近邻的方的倒数加权这个近邻的“选举权选举权”:

当当xxqq=x=xii,将导致分母,将导致分母d(xd(xqqxxii)22为为00,此时令,此时令。

如果。

如果有多个这样的训练样例,我们使用它们中占多数的分类。

有多个这样的训练样例,我们使用它们中占多数的分类。

2022/10/27128.2.1距离加权最近邻算法距离加权最近邻算法(2/3)n对对实值目标函数实值目标函数进行距离加权,用下式:

进行距离加权,用下式:

其中,其中,wwii的定义与前式中相同。

注意该式中的分母是一个常量,的定义与前式中相同。

注意该式中的分母是一个常量,它将不同权值的贡献归一化它将不同权值的贡献归一化(例如,它保证如果对所有的训练样例如,它保证如果对所有的训练样例例xxii,f(xf(xii)cc,那么,那么,。

2022/10/27138.2.1距离加权最近邻算法距离加权最近邻算法(3/3)n注意注意,以上,以上kk一近邻算法的所有变体都只考虑一近邻算法的所有变体都只考虑kk个近邻个近邻用以分用以分类查询点。

可以考虑类查询点。

可以考虑所有的所有的训练样例影响训练样例影响的分类,的分类,因为非常远的实例对其影响很小。

考虑所有样例的惟一因为非常远的实例对其影响很小。

考虑所有样例的惟一不足不足是会使分类运行得更慢。

是会使分类运行得更慢。

n如果分类一个新的查询实例时考虑所有的训练样例,我们称如果分类一个新的查询实例时考虑所有的训练样例,我们称它为它为全局全局(global)(global)法法。

n如果仅考虑最靠近的训练样例,我们称它为如果仅考虑最靠近的训练样例,我们称它为局部局部(local)(local)法法。

n当式当式(8.4)(8.4)(前式)的法则被应用为全局法时,它被称为(前式)的法则被应用为全局法时,它被称为ShepardShepard法法。

2022/10/27148.2.2对对k-近邻算法的说明(近邻算法的说明(1/6)n按距离加权的按距离加权的kk一近邻算法是一种非常有效的一近邻算法是一种非常有效的归纳推归纳推理理方法。

方法。

它对训练数据中的噪声有很好的健壮性它对训练数据中的噪声有很好的健壮性,而,而且当给定足够大的训练集合时也非常有效。

且当给定足够大的训练集合时也非常有效。

注意注意,通,通过取过取kk个近邻的加权平均,可以消除孤立的噪声样例的个近邻的加权平均,可以消除孤立的噪声样例的影响。

影响。

nkk一近邻算法的一近邻算法的归纳偏置对应于假定归纳偏置对应于假定:

一个实例的分类一个实例的分类xxqq与在欧氏空间中它附近的实例的分类相似与在欧氏空间中它附近的实例的分类相似。

2022/10/27158.2.2对对k-近邻算法的说明(近邻算法的说明(2/6)n应用应用kk一近邻算法的一个一近邻算法的一个实践问题是实践问题是,实例间的距离,实例间的距离是根据实例的所有属性是根据实例的所有属性(也就是包含实例的欧氏空间也就是包含实例的欧氏空间的所有坐标轴的所有坐标轴)计算的。

计算的。

n考虑把考虑把kk一近邻算法应用到这样一个问题一近邻算法应用到这样一个问题:

每个实例每个实例由由2020个属性描述,但在这些属性中个属性描述,但在这些属性中仅有仅有22个与它的分个与它的分类有关类有关。

在这种情况下,这两个相关属性的值一致。

在这种情况下,这两个相关属性的值一致的实例可能在这个的实例可能在这个2020维的实例空间中相距很远。

结维的实例空间中相距很远。

结果,依赖这果,依赖这2020个属性的相似性度量会个属性的相似性度量会误导误导kk一近邻算一近邻算法的分类。

法的分类。

2022/10/27168.2.2对对k-近邻算法的说明(近邻算法的说明(3/6)n近邻间的距离会被大量的不相关属性所支配。

这种近邻间的距离会被大量的不相关属性所支配。

这种由于存在很多不相关属性所导致的难题,有时被称为由于存在很多不相关属性所导致的难题,有时被称为维度灾难维度灾难(curseofdimensiona