时间序列分析模型与回归分析模型算法说明.docx

《时间序列分析模型与回归分析模型算法说明.docx》由会员分享,可在线阅读,更多相关《时间序列分析模型与回归分析模型算法说明.docx(13页珍藏版)》请在冰豆网上搜索。

时间序列分析模型与回归分析模型算法说明

本次模型采用时间序列分析模型与回归分析模型进行组合练习,以此来对经

济指标进行时间序列预测发现其自身的规律性,据此预测未来一段时间内经济数据的变化.同时采用回归分析对经济指标间的相关性进行分析,确定指标间的函

数变动,探究指标之间的联系.

一、回归分析

线性回归和逻辑回归通常是人们学习预测模型的第一个算法.由于这二者的知名度很大,许多分析人员以为它们就是回归的唯一形式了.而了解更多的学者会知道它们是所有回归模型的主要两种形式.

事实是有很多种回归形式,每种回归都有其特定的适用场合.在这篇文章中,我将以简单的形式介绍7中最常见的回归模型.通过这篇文章,我希望能够帮助大家对回归有更广泛和全面的熟悉,而不是仅仅知道使用线性回归和逻辑回归来解决实际问题.

1.什么是回归分析

回归分析是一种预测建模技术的方法,研究因变量〔目标〕和自变量〔预测器〕之前的关系.这一技术被用在预测、时间序列模型和寻找变量之间因果关系.例如研究驾驶员鲁莽驾驶与交通事故发生频率之间的关系,就可以通过回归分析来解决.

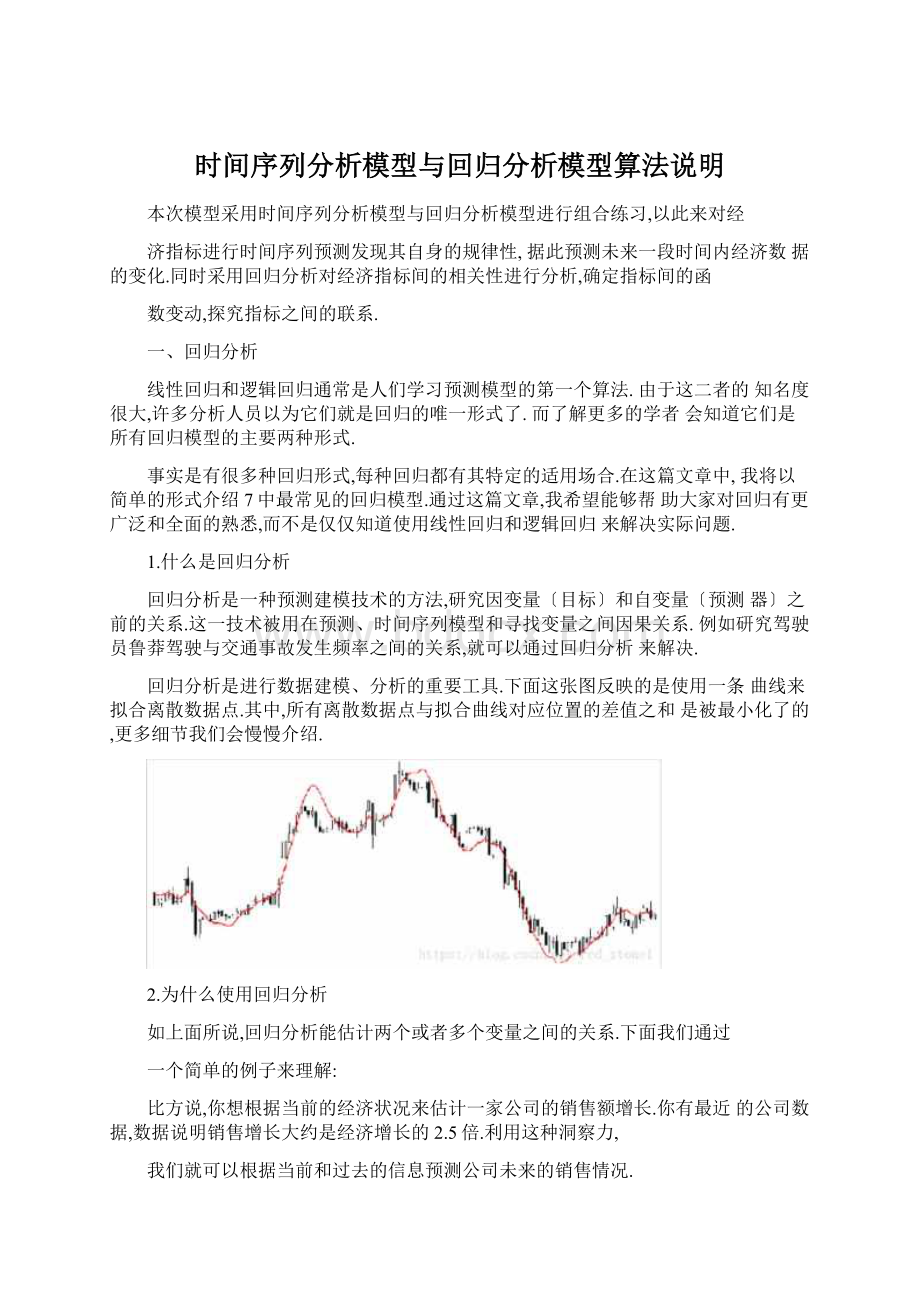

回归分析是进行数据建模、分析的重要工具.下面这张图反映的是使用一条曲线来拟合离散数据点.其中,所有离散数据点与拟合曲线对应位置的差值之和是被最小化了的,更多细节我们会慢慢介绍.

2.为什么使用回归分析

如上面所说,回归分析能估计两个或者多个变量之间的关系.下面我们通过

一个简单的例子来理解:

比方说,你想根据当前的经济状况来估计一家公司的销售额增长.你有最近的公司数据,数据说明销售增长大约是经济增长的2.5倍.利用这种洞察力,

我们就可以根据当前和过去的信息预测公司未来的销售情况.

使用回归模型有很多好处,例如:

揭示了因变量和自变量之间的显著关系

揭示了多个自变量对一个因变量的影响程度大小

回归分析还允许我们比拟在不同尺度上测量的变量的影响,例如价格变化的影响和促销活动的数量的影响.这样的好处是可以帮助市场研究者/数据分析家/数据科学家评估选择最正确的变量集,用于建立预测模型.

3.有哪些回归类型

有许多回归技术可以用来做预测.这些回归技术主要由三个度量〔独立变量的数量、度量变量的类型和回归线的形状〕驱动.我们将在下面的章节中详细讨论.

对于有创造力的人来说,可以对上面的参数进行组合,甚至创造出新的回归.但是在此之前,让我们来看一看最常见的几种回归.

4〕线性回归〔LinearRegression

线性回归是最为人熟知的建模技术,是人们学习如何预测模型时的首选之一.在此技术中,因变量是连续的,自变量可以是连续的也可以是离散的.回归的本质是线性的.

线性回归通过使用最正确的拟合直线〔又被称为回归线〕,建立因变量〔Y〕和一个或多个自变量〔X〕之间的关系.

它的表达式为:

Y=a+b*X+e,其中a为直线截距,b为直线斜率,e为误差项.如果给出了自变量X,就能通过这个线性回归表达式计算出预测值,即因变量Y.

线性回归的区别在于,多元线性回归有大于1个自变量,而一元线性回归只有1个自变量.接下来的问题是“如何获得最正确拟合直线〞

如何获得最正确拟合直线(确定a和b值)

这个问题可以使用最小二乘法(LeastSquareMethod)轻松解决.最小二乘法是一种拟合回归线的常用算法.它通过最小化每个数据点与预测直线的垂直误差的平方和来计算得到最正确拟合直线.由于计算的是误差平方和,所有,误差正负值之间没有相互抵消.

自变量和因变量之间必须满足线性关系.多元回归存在多重共线性,自相关性和异方差性.线性回归对异常值非常敏感.异常值会严重影响回归线和最终的预测值.多重共线性会增加系数估计的方差,并且使得估计对模型中的微小变化非常敏感.结果是系数估计不稳定.

在多个自变量的情况下,我们可以采用正向选择、向后消除和逐步选择的方法来选择最重要的自变量.

2)逻辑回归

逻辑回归用来计算事件成功(Success或者失败(Failure)的概率.当因变量是二进制(0/1,True/False,Yes/NO)时,应该使用逻辑回归.这里,Y的取值范围为[0,1],它可以由以下等式来表示.

odds=p/(1-p)=probabilityofeventoccurrence/probabilityofnoteventoccurrence

ln(odds)=ln(p/(1-p))

logit(p)=ln(p/(1-p))=b0+b1X1+b2X2+b3X3....+bkXk

其中,p是事件发生的概率.你可能会有这样的疑问“为什么在等式中使用对数log呢"

由于我们这里使用的二项分布(因变量),所以需要选择一个适宜的激活函数能够将输出映射到[0,1]之间,Logit函数满足要求.在上面的等式中,通过使用最大似然估计来得到最正确的参数,而不是使用线性回归最小化平方误差的方法.

逻辑回归广泛用于分类问题.逻辑回归不要求因变量和自变量之间是线性关系,它可以处理多类型关系,由于它对预测输出进行了非线性log变换.

为了防止过拟合和欠拟合,我们应该涵盖所有有用的变量.实际中保证这种情况的一个好的做法是使用逐步筛选的方法来估计逻辑回归.

练习样本数量越大越好,由于如果样本数量少,最大似然估计的效果就会比最小二乘法差.

自变量不应相互关联,即不存在多重共线性.然而,在分析和建模中,我们可以选择包含分类变量相互作用的影响.

如果因变量的值是序数,那么称之为序数逻辑回归.

如果因变量是多类别的,那么称之为多元逻辑回归.

3)多项式回归(PolynomialRegression

对应一个回归方程,如果自变量的指数大于1,那么它就是多项式回归方程,

如下所示:

y=a+b*xA2

1在多项式回归中,最正确的拟合线不是直线,而是拟合数据点的曲线.

虽然可能会有一些诱导去拟合更高阶的多项式以此来降低误差,但是这样容

易发生过拟合.应该画出拟合曲线图形,重点放在保证曲线反映样本真实分布上.以下图是一个例子,可以帮助我们理解.

尤其要注意曲线的两端,看看这些形状和趋势是否有意义.更高的多项式可以产生怪异的推断结果.

4〕逐步回归〔StepwiseRegression

当我们处理多个独立变量时,就使用逐步回归.在这种技术中,独立变量的选择是借助于自动过程来完成的,不涉及人工干预.

逐步回归的做法是观察统计值,例如R-square、t-stats、AIC指标来区分重

要的变量.基于特定标准,通过增加/删除协变量来逐步拟合回归模型.常见的逐步回归方法如下所示:

标准的逐步回归做两件事,每一步中增加或移除自变量.

前向选择从模型中最重要的自变量开始,然后每一步中增加变量.

反向消除从模型所有的自变量开始,然后每一步中移除最小显著变量.

这种建模技术的目的是通过使用最少的自变量在得到最大的预测水平.它也

是处理高维数据集的方法之一.

5〕岭回归〔RidgeRegression

岭回归是当数据遭受多重共线性〔独立变量高度相关〕时使用的一种技术.

在多重共线性中,即使最小二乘估计〔OLS是无偏差的,但是方差很大,使得观察智远离真实值.岭回归通过给回归估计中增加额外的偏差度,能够有效减少

方差.

之前我们介绍过线性回归方程,如下所示:

y=a+b?

x

这个方程也有一个误差项,完整的方程可表示成:

y=a+b*x+e(errorterm),[errortermisthevalueneededtocorrectforapredictionerrorbetweentheobservedandpredictedvalue]

=>y=a+y=a+b1x1+b2x2+....+e,formultipleindependentvariables.

在线性方程中,预测误差可以分解为两个子分量.首先是由于偏颇,其次是

由于方差.预测误差可能由于这两个或两个分量中的任何一个而发生.这里,我

们将讨论由于方差引起的误差.

岭回归通过收缩参数入〔lambda〕解决了多重共线性问题.请看下面的方程式:

=argmin||y-+A|网后

隧Rp7

[xkjgEnmity

上面这个公式中包含两项.第一个是最小平方项,第二个是系数B的平方和项,前面乘以收缩参数入.增加第二项的目的是为了缩小系数B的幅值以减小方差.

6〕套索回归〔LassoRegression

类似于岭回归,套索〔LeastAbsoluteShrinkageandSelectionOperatedr回归惩罚的是回归系数的绝对值.止匕外,它能够减少变异性和提升线性回归模型的准确性.请看下面的方程式:

=argmin||j/-X3的+>口训

夹咐p*-v、7^

LottsPenalty

套索回归不同于岭回归,惩罚函数它使用的是系数的绝对值之和,而不是平方.这导致惩罚项〔或等价于约束估计的绝对值之和〕,使得一些回归系数估计恰好为零.施加的惩罚越大,估计就越接近零.实现从n个变量中进行选择.

7〕弹性回归〔ElasticNetRegression

弹性回归是岭回归和套索回归的混合技术,它同时使用L2和L1正那么化.

当有多个相关的特征时,弹性网络是有用的.套索回归很可能随机选择其中一个,而弹性回归很可能都会选择.

3="部曲〔旧—+刖牍『十九||叫J

权衡岭回归和套索回归的一个优点是它让弹性回归继承了一些岭回归在旋转状态下的稳定性.

4.如何选择适宜的回归模型

当你只知道一两种技巧时,生活通常是简单的.我知道的一个培训机构告诉他们的学生:

如果结果是连续的,使用线性回归;如果结果是二值的,使用逻辑回归!

然而,可供选择的选项越多,选择适宜的答案就越困难.类似的情况也发生在回归模型选择中.

二、时间序列分析

时间序列(timeseries)是同一现象在不同时间上的相继观察值排列而成的序列.根据观察时间的不同,时间序列中的时间可以是可以是年份、季度、月份或其他任何时间形式.

时间序列:

(1)平稳序歹!

J(stationaryseries)

是根本上不存在趋势的序列,序列中的各观察值根本上在某个固定的水平上

是包含趋势、季节性或周期性的序列,只含有其中一种成分,也可能是几种成分的组合.可分为:

有趋势序列、有趋势和季节性序列、几种成分混合而成的复合型序列.

趋势(trend):

时间序列在长时期内呈现出来的某种持续上升或持续下降的变动,也称长期趋势.时间序列中的趋势可以是线性和非线性.

季节性(seasonaHty):

季节变动(seasonalfluctuation),是时间序列在一年

内重复出现的周期波动.销售旺季,销售淡季,旅游旺季、旅游淡季,因季节不同而发生变化.季节,不仅指一年中的四季,其实是指任何一种周期性的变化.

周期性(cyclidty):

循环波动(cyclicalfluctuation),是时间序列中呈现出来的围绕长期趋势的一种波浪形或振荡式波动.周期性是由商业和经济活动引起的,不同于趋势变动,不是朝着单一方向的持续运动,而是涨落相间的交替波动;不同于季节变动,季节变动有比拟固定的规律,且变动周期大多为一年,循环波动那么无固定规律,变动周期多在一年以上,且周期长短不一.周期性通常是由经济环境的变化引起.

除此之外,还有偶然性因素对时间序列产生影响,致使时间序列呈现出某种随机波动.时间序列除去趋势、周期性和季节性后的偶然性波动,称为随机性

(random),也称不规贝U波动(irregular