含答案机器学习第一阶段练习题Word文件下载.docx

《含答案机器学习第一阶段练习题Word文件下载.docx》由会员分享,可在线阅读,更多相关《含答案机器学习第一阶段练习题Word文件下载.docx(4页珍藏版)》请在冰豆网上搜索。

a应该限定取值范围:

a≥1或a≤0

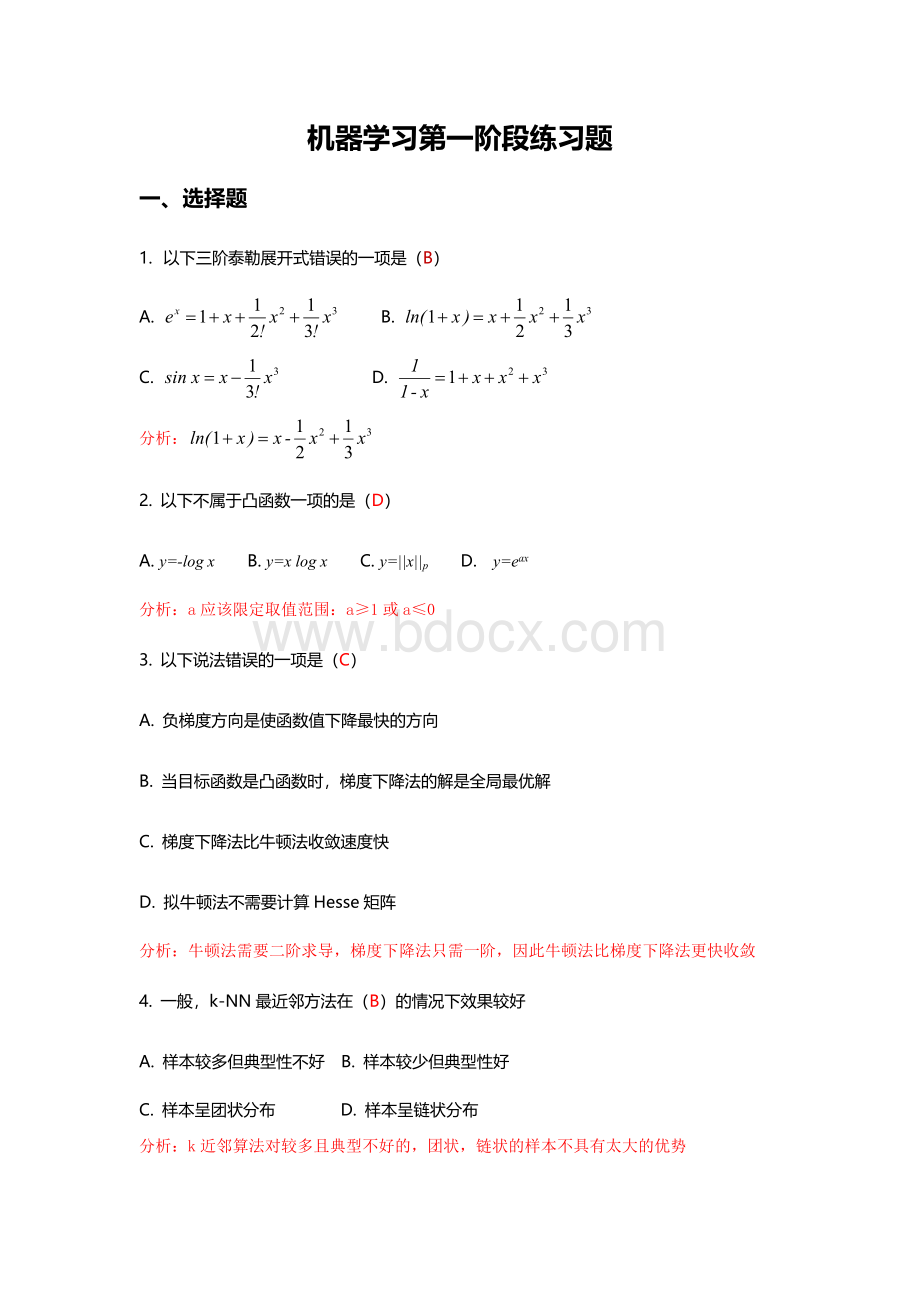

3.以下说法错误的一项是(C)

A.负梯度方向是使函数值下降最快的方向

B.当目标函数是凸函数时,梯度下降法的解是全局最优解

C.梯度下降法比牛顿法收敛速度快

D.拟牛顿法不需要计算Hesse矩阵

牛顿法需要二阶求导,梯度下降法只需一阶,因此牛顿法比梯度下降法更快收敛

4.一般,k-NN最近邻方法在(B)的情况下效果较好

A.样本较多但典型性不好B.样本较少但典型性好

C.样本呈团状分布D.样本呈链状分布

k近邻算法对较多且典型不好的,团状,链状的样本不具有太大的优势

5.机器学习中L1正则化和L2正则化的区别是?

(A)

A.使用L1可以得到稀疏的权值,使用L2可以得到平滑的权值

B.使用L1可以得到平滑的权值,使用L2可以得到平滑的权值

C使用L1可以得到平滑的权值,使用L2可以得到稀疏的权值

D.使用L1可以得到稀疏的权值,使用L2可以得到稀疏的权值

L1正则化偏向于稀疏,它会自动进行特征选择,去掉一些没用的特征,也就是将这些特征对应的权重置为0。

L2主要功能是为了防止过拟合,当要求参数越小时,说明模型越简单,而模型越简单则,越趋向于平滑,从而防止过拟合。

二、公式推理题

1.请写出通过条件概率公式和全概率公式推出贝叶斯公式的过程

条件概率:

全概率:

贝叶斯公式:

2.请写出正态分布的概率密度函数、期望、以及方差

概率密度函数:

;

期望:

方差:

三、简答题

1.求函数的最小值

令两边取对数:

两边对t求导:

令t’=0:

,则即为f(x)最小值。

2.欠拟合和过拟合的原因分别有哪些?

如何避免?

欠拟合的原因:

模型复杂度过低,不能很好的拟合所有的数据,训练误差大;

避免欠拟合:

增加模型复杂度,如采用高阶模型(预测)或者引入更多特征(分类)等。

过拟合的原因:

模型复杂度过高,训练数据过少,训练误差小,测试误差大;

避免过拟合:

降低模型复杂度,如加上正则惩罚项,如L1,L2,增加训练数据等。

3.列举聚类算法有哪些相似性度量准则及公式(至少四个)

曼哈顿距离:

欧氏距离:

Jaccard系数:

余弦相似度:

皮尔森系数:

相对熵(K-L距离):

4.若要对以下图案进行聚类分析需要采用哪种聚类方法,简述理由和该方法步骤

该图案为非凸状的,因此不能使用基于距离的聚类算法(k-means、k-medoids等),可选择密度聚类(DBSCAN等)、网格聚类(STING)等非距离的方法。

5.简述UserCF和ItemCF算法的相同点与不同点

项目

UserCF

ItemCF

性能

适用于用户较少的场合,如果用户过多,计算用户相似度矩阵的代价交大

适用于物品数明显小于用户数的场合,如果物品很多,计算物品相似度矩阵的代价交大

领域

实效性要求高,用户个性化兴趣要求不高

长尾物品丰富,用户个性化需求强烈

实时性

用户有新行为,不一定需要推荐结果立即变化

用户有新行为,一定会导致推荐结果的实时变化

冷启动

在新用户对少的物品产生行为后,不能立即对他进行个性化推荐,因为用户相似度是离线计算的

新物品上线后一段时间,一旦有用户对物品产生行为,就可以将新物品推荐给其他用户

新用户只要对一个物品产生行为,就能推荐相关物品给他,但无法在不离线更新物品相似度表的情况下将新物品推荐给用户

推荐理由

很难提供

可以根据用户历史行为归纳推荐理由