Elasticsearch索引的架构设计.docx

《Elasticsearch索引的架构设计.docx》由会员分享,可在线阅读,更多相关《Elasticsearch索引的架构设计.docx(8页珍藏版)》请在冰豆网上搜索。

Elasticsearch索引的架构设计

Elasticsearch索引的架构设计

1、Elasticsearch索引的设计

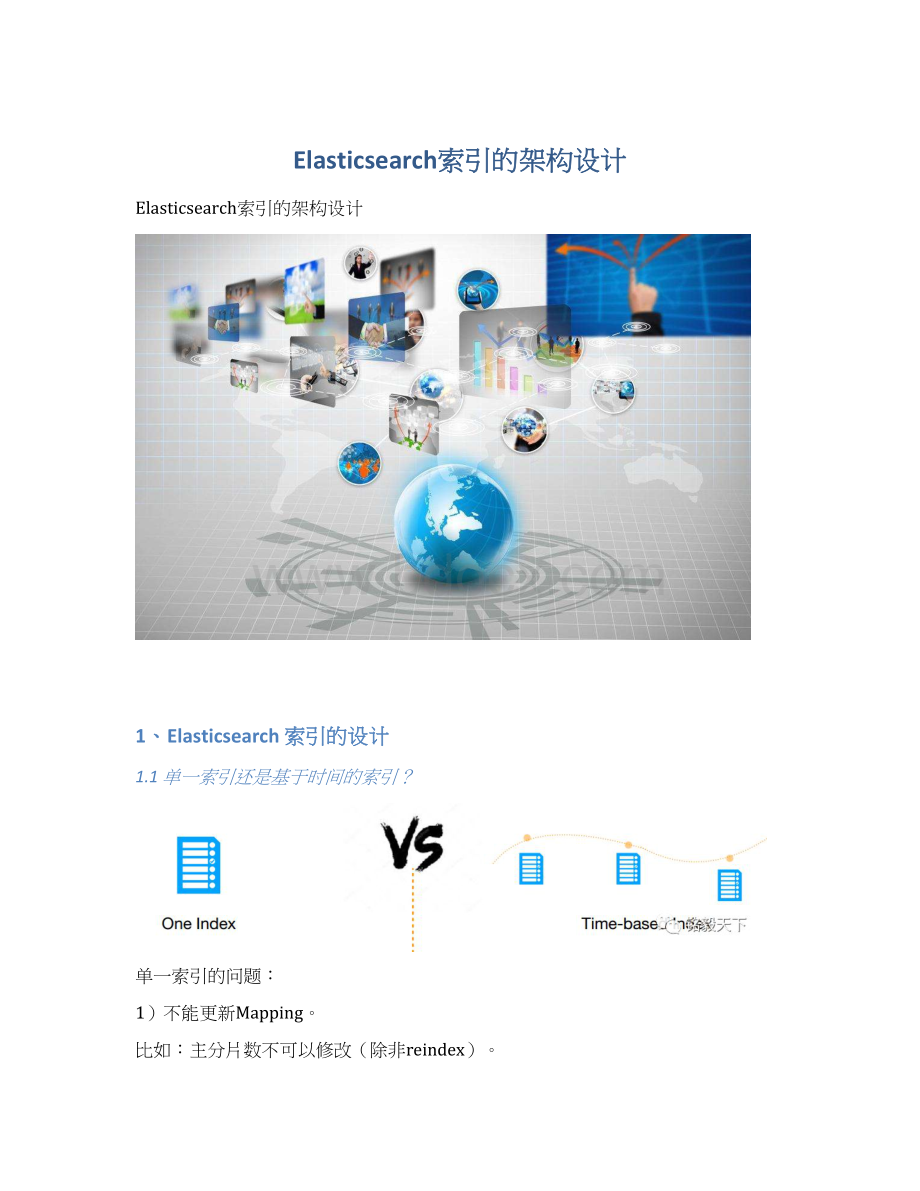

1.1单一索引还是基于时间的索引?

单一索引的问题:

1)不能更新Mapping。

比如:

主分片数不可以修改(除非reindex)。

2)无法灵活、快速地扩展。

3)更适合固定、小型数据集。

基于时间的索引面临的问题:

1)如何确定间隔?

∙数据量

∙变更频率

∙默认尝试每周为单位分割——建议

2)如何实施?

∙索引模板

1.2定义索引注意事项

举例:

注意1:

不要在一个索引中定义多个type。

6.X版本已经不支持,7.X版本彻底不支持。

扩展问题:

5.X版本的父子文档实际实现中是一个索引中定义了多个type,到了6.X中实现方式改变为:

join方式。

注意2:

将Set_source设置为false。

假设你只关心度量结果,不是原始文件内容。

将节省磁盘空间并减少IO。

这个点,需要结合实际的业务场景具体问题具体分析。

举例:

"_source":

{

"enabled":

false

},

注意3:

将_all设置为false。

假设你确切地知道你对哪个field做查询操作?

能实现性能提升,缩减存储。

举例:

"_all":

{

"enabled":

false},

注意4:

设置dynamic=strict。

假设你的数据是结构化数据。

字段设置严格,避免脏数据注入。

举例:

"dynamic":

"strict",

注意5:

使用keyword类型

假设你只关心完全匹配

提高性能和缩小磁盘存储空间

举例:

"CLF_CustomerID":

{

"type":

"keyword"

},

注意6:

使用别名

如何在不停机的前提从一个索引切换到另一个索引?

举例:

"aliases":

{

"{index}-query":

{

}

或者你通过head插件创建。

2、Elasticsearch分片分配原则

社区和QQ群中经常被问到的问题:

1)应该分几个索引、几个分片?

2)每个分片大小如何设置?

3)副本多少如何设置?

这里,明确给出实操可行的6个步骤。

步骤1:

定义索引

思考索引中要大致有哪些字段?

最好能列一个Excel表统计一下,包含但不限于:

序号、名称、类型、作用、备注。

以上对计算单条数据大小也有用。

步骤2:

评估数据量

评估方法举例:

1分钟有100条数据,1天=1006024=144000条。

1月=144000条30天=432W条数据。

1年=432W12=5184W条数据。

假设要保存2年,共=10368W条数据。

假设每条数据20KB,共需要存储:

10368W*20/1024/1024/1024=1.977TB。

步骤3:

评估索引大小和磁盘空间

步骤4:

计算分片数

细节考虑点:

1、每个分片大小应小于30GB。

2、分片数量=k*数据节点数目(k=一个足够小的整数,举例:

1,2,3)

3、假设你有一个小的索引,并且你有集群中有足够的节点,请尝试使用默认值分片数5。

步骤5:

评估索引数和类型

(此处可能会有多次反馈迭代)

3、数据去重的思考

方法1:

指定唯一id

缺点:

1、唯一值无法压缩,不利于存储。

2、存在高基数问题。

方法2:

用聚合方法实现

步骤1:

所有文档加一个Hash值;

步骤2:

检查重复;

步骤3:

批量删除步骤2中的重复id。

以上步骤,不影响写入,可以实现异步。

缺点:

1.存储量大(尤其超过3亿条+);

2.随着数据量增加,聚合受影响,越来越慢。

3.存在高基数问题。

方法3:

用distinctquery实现