Python爬虫实战.docx

《Python爬虫实战.docx》由会员分享,可在线阅读,更多相关《Python爬虫实战.docx(94页珍藏版)》请在冰豆网上搜索。

Python爬虫实战

Python爬虫实战

Python爬虫实战

(1):

爬取糗事百科段子

大家好,前面入门已经说了那么多基础知识了,下面我们做几个实战项目来挑战一下吧。

那么这次为大家带来,Python爬取糗事百科的小段子的例子。

首先,糗事百科大家都听说过吧?

糗友们发的搞笑的段子一抓一大把,这次我们尝试一下用爬虫把他们抓取下来。

本篇目标

1.抓取糗事百科热门段子

2.过滤带有图片的段子

3.实现每按一次回车显示一个段子的发布时间,发布人,段子容,点赞数。

糗事百科是不需要登录的,所以也没必要用到Cookie,另外糗事百科有的段子是附图的,我们把图抓下来图片不便于显示,那么我们就尝试过滤掉有图的段子吧。

好,现在我们尝试抓取一下糗事百科的热门段子吧,每按下一次回车我们显示一个段子。

1.确定URL并抓取页面代码

首先我们确定好页面的URL是.qiushibaike./hot/page/1,其中最后一个数字1代表页数,我们可以传入不同的值来获得某一页的段子容。

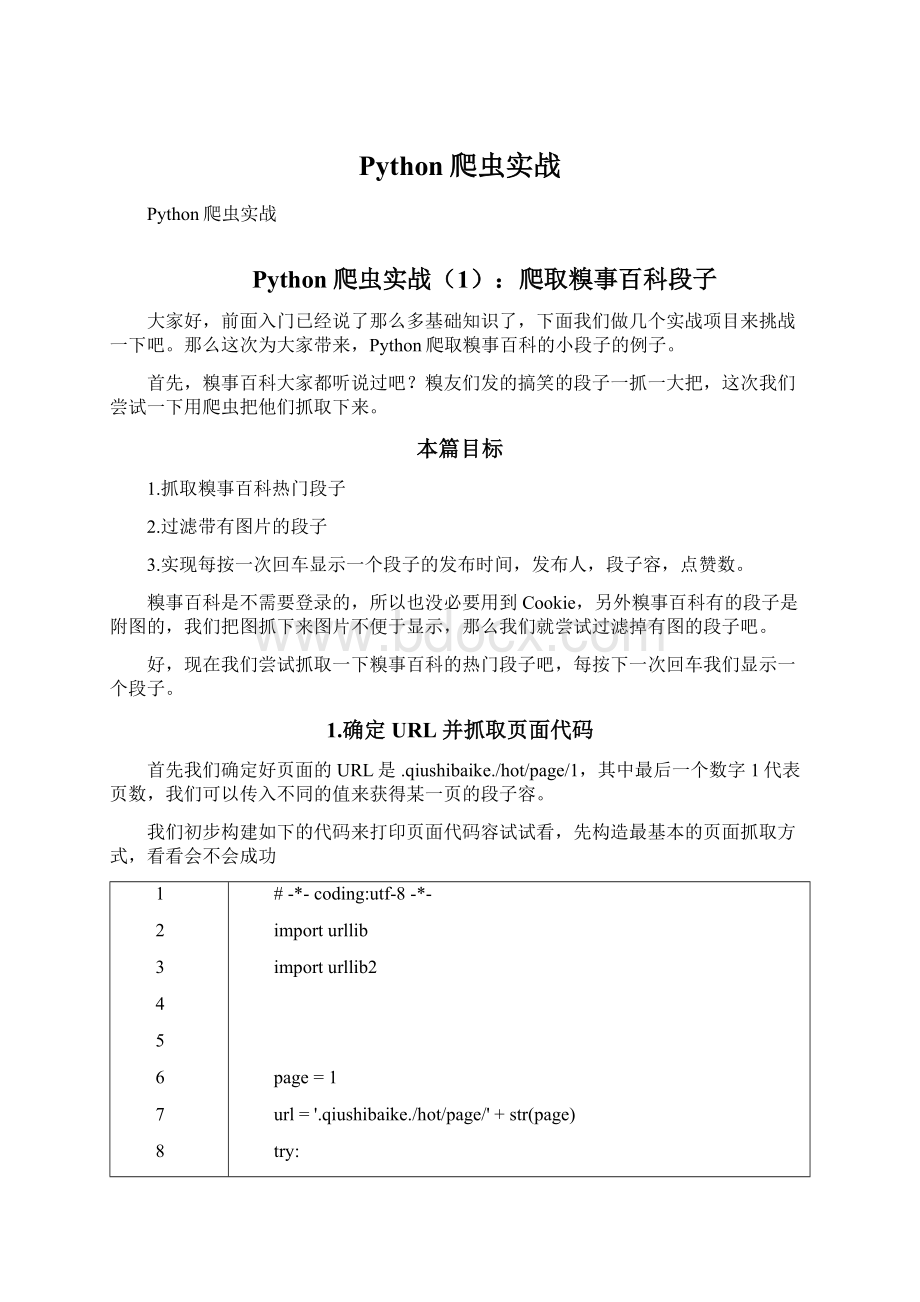

我们初步构建如下的代码来打印页面代码容试试看,先构造最基本的页面抓取方式,看看会不会成功

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

#-*-coding:

utf-8-*-

importurllib

importurllib2

page=1

url='.qiushibaike./hot/page/'+str(page)

try:

request=urllib2.Request(url)

response=urllib2.urlopen(request)

printresponse.read()

excepturllib2.URLError,e:

ifhasattr(e,"code"):

printe.code

ifhasattr(e,"reason"):

printe.reason

运行程序,哦不,它竟然报错了,真是时运不济,命途多舛啊

1

2

3

line373,in_read_status

raiseBadStatusLine(line)

httplib.BadStatusLine:

''

好吧,应该是headers验证的问题,我们加上一个headers验证试试看吧,将代码修改如下

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

#-*-coding:

utf-8-*-

importurllib

importurllib2

page=1

url='.qiushibaike./hot/page/'+str(page)

user_agent='Mozilla/4.0(compatible;MSIE5.5;WindowsNT)'

headers={'User-Agent':

user_agent}

try:

request=urllib2.Request(url,headers=headers)

response=urllib2.urlopen(request)

printresponse.read()

excepturllib2.URLError,e:

ifhasattr(e,"code"):

printe.code

ifhasattr(e,"reason"):

printe.reason

嘿嘿,这次运行终于正常了,打印出了第一页的HTML代码,大家可以运行下代码试试看。

在这里运行结果太长就不贴了。

2.提取某一页的所有段子

好,获取了HTML代码之后,我们开始分析怎样获取某一页的所有段子。

首先我们审查元素看一下,按浏览器的F12,截图如下

我们可以看到,每一个段子都是…