模式识别复习.docx

《模式识别复习.docx》由会员分享,可在线阅读,更多相关《模式识别复习.docx(14页珍藏版)》请在冰豆网上搜索。

模式识别复习

第一、二章

1.模式识别概念、方法?

概念:

就是要用机器去完成人类智能中通过视觉听觉触觉等感官去识别外界环境的自然信息的这些工作。

方法:

统计方法,句法方法,模糊方法,人工神经网络法,人工智能法

2.模式识别系统的组成,简述各部分的作用?

数据获取:

通过测量、采样和量化获取数据的过程

预处理:

去出噪声,加强有用的信息,复原退化现象

特征提取和选择:

得到最能反映分类本质的特征

分类决策:

就是在特征空间中用统计方法把被识别对象归为某一类别

3.相似性度量有哪几种方法?

(我找不到,要不你找找?

)

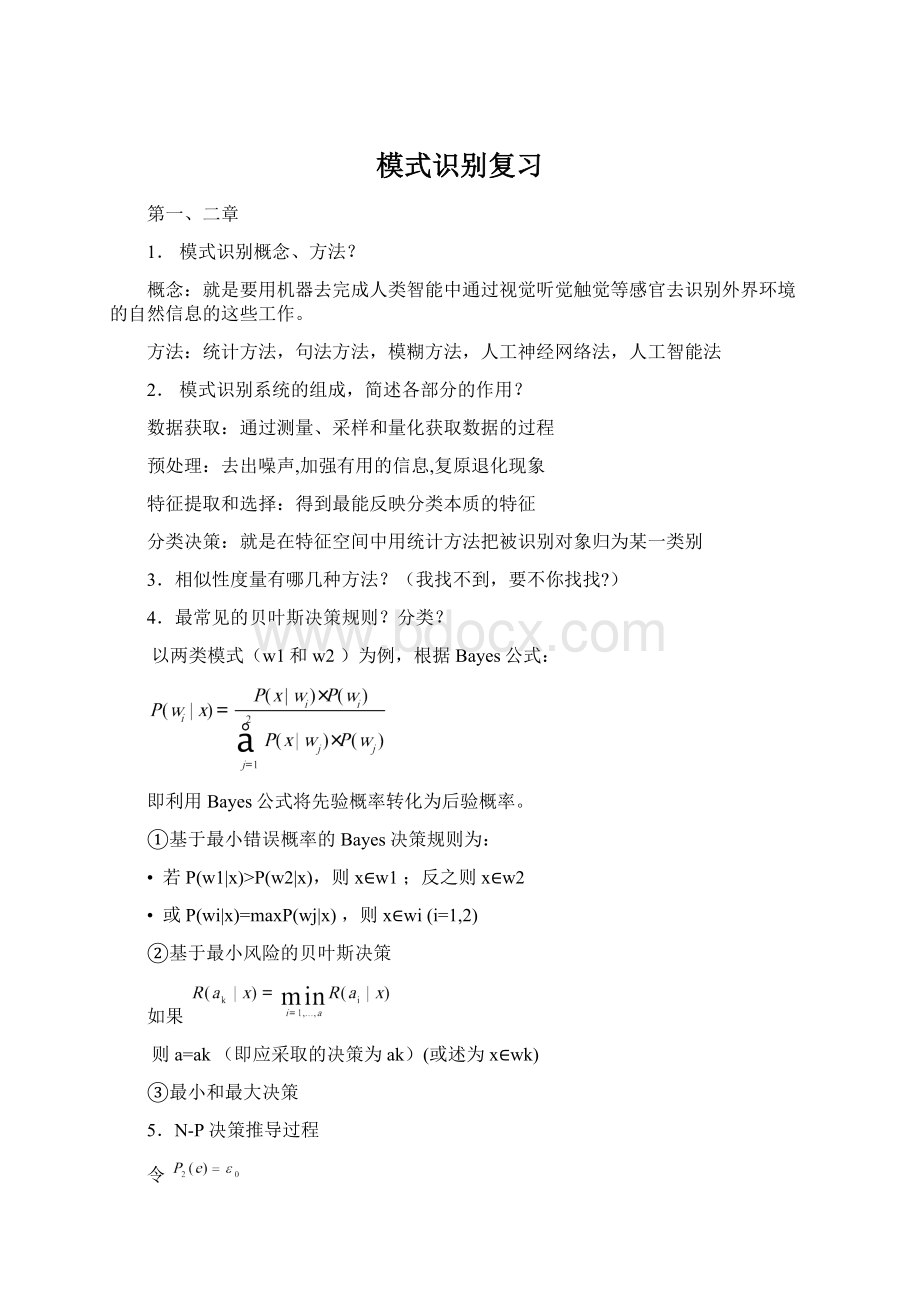

4.最常见的贝叶斯决策规则?

分类?

以两类模式(w1和w2)为例,根据Bayes公式:

即利用Bayes公式将先验概率转化为后验概率。

①基于最小错误概率的Bayes决策规则为:

•若P(w1|x)>P(w2|x),则x∈w1;反之则x∈w2

•或P(wi|x)=maxP(wj|x),则x∈wi(i=1,2)

②基于最小风险的贝叶斯决策

如果

则a=ak(即应采取的决策为ak)(或述为x∈wk)

③最小和最大决策

5.N-P决策推导过程

令

下,求

的极小值。

即:

采用Lagrange乘子法,构造Lagrange函数为:

其中λ是Lagrange乘子,目的是求

的极小值。

(即λ为一待定常数)。

将p1(e)与p2(e)的表达式代入 上式。

化简后

上式中λ是Lagrange乘子,而R1是变量,这样

的极小值问题就是要选择R1和R2的边界(边界点为t)问题了,即求R1使

取极小值。

据条件极值求解方法,得

解上述方程求得λ和x(设为t)。

λ为Lagrange乘子(常数)。

而x为 的极小值解。

即当边界点x=t时,所得的边界面就能使λ(即p1(e))最小。

6.什么叫决策面?

判别函数?

及二者之间关系?

给出一种情况写出判别函数形式及决策规则。

决策面:

按照决策规则可将d维特征空间分成c个决策域/区域,各区域之间的边界面称之决策面。

判别函数:

用于比挨打决策规则的某些函数称为判别函数。

判别函数与决策面方程式密切相关的,且他们都有相应的决策规则所确定。

⑴两类下

设Ω={w1,w2},x=[x1,x2,…,xd]T

决策规则:

(其他等价形式见书P21)

判别函数:

故这时决策规则变为:

⑵多类下

设Ω={w1,…,wC},x=[x1,x2,…,xd]T

决策规则:

与两类下类同

判别函数:

这时要定义一组gi(x)(i=1,2,…,c)来进行决策判别。

且判决规则为:

若gi(x)>gj(x),∀j≠i⇒x∈wi类

而gi(x)=p(wi|x)等多种等价形式(见教材p23(2-38)式)

决策面方程:

这时满足:

gi(x)=gj(x)且Ri与Rj相邻

7.单、多变量的正态分布形式?

(式子中的参数弄清楚)

①单变量正态分布:

式子中:

µ为随机变量x的期望,σ²为x的方差σ称为标准差。

②多变量正态分布:

式子中:

x为d维列向量,µ为d维均值向量µ=E[x],Σ为d×d维协方差矩阵。

﹡例2.2设正常p(w1)=0.9,异常p(w2)=0.1,p(x|w1)=0.2,p(x|w2)=0.4,l11=l22=0,l21=6,l12=1。

解1:

根据例2.1的计算结果可知后验概率为:

p(w1|x)=0.818,p(w2|x)=0.182

计算出条件风险得:

R(a1|x)=1.092,R(a2|x)=0.818

∵R(a1|x)>R(a2|x)

∴采取决策a2,即待识别对象x∈w2

解2:

利用似然比表示式判决

∵0.2/0.4=0.5<((6-0)*0.1)/((1-0)*0.9)=0.667

∴同样得上结论。

*习题P432.6

第三章

1.从样本集推断样本总体概率分布有几种类型?

概念。

⑴监督参数估计:

样本所属的类别及类条件总体概率密度函数的形式为已知,而表征概率密度函数的某些参数是未知。

⑵非监督参数估计:

已知总体概率密度函数形式但未知样本所属类别,要求推断出概率密度函数的某些参数,称这种推断方法为非监督参数情况下的参数估计。

⑶非参数估计:

已知样本所属类别,但未知总体概率密度函数的形式,要求我们直接推断概率密度函数本身。

2.最大似然估计的思想?

最大似然估计量?

如何用最大似然估计方法对参数估计?

⑴最大似然估计的基本思想:

如果在一次观察中一个事件X出现了,那么可认为这个事件出现的可能性很大。

这里,事件X={x1,x2,…,xn}是按概率密度p(X|wi)从总体中抽出的样本,这时就认为p(X|θ)达到了最大值,使p(X|θ)达到最大值的θ’就是θ的最大似然估计。

⑵最大似然估计量:

令l(θ)为样本集﹛x1,x2,…,xN﹜的似然函数,如果θ’=d(x1,x2,…,xN)是参数空间中能使似然函数l(θ)极大化的θ值,θ’就是θ的最大似然估计量。

⑶设已得到属于同一类的N个样本,即 X={x1,…,xN}

它们具有概率密度p(xk|θ)(k=1,…,N),且样本是独立抽取的,则

p(X|θ)=p(x1,…,xN|θ)=∏p(xk|θ)

p(X|θ)是θ的函数(将其称为相对于样本集X的θ的似然函数,记为l(θ)),即

l(θ)=p(X|θ)=∏p(xk|θ)

l(θ)的对数形式lnl(θ)(记为H(θ),称其为对数似然函数),使H(θ)极大的θ同样使l(θ)取极大值。

H(θ)=lnl(θ)=lnp(X|θ)

=lnp(x1,…,xN|θ)

在N个样本独立抽取时,且设参数向量

在该式对θ的偏导等于零的解,就是θ’。

其中梯度算子

,

即从

的s个方程中求得θ’={θ1,…,θs}。

如果以上方程的解θ’能使似然函数值最大,则θ’就是θ的最大似然估计。

3.什么是贝叶斯估计?

贝叶斯学习?

二者联系?

⑴Bayes估计的思想:

所求得的θ的估计值θ’应使估计损失的期望最小,这种使R或等价地使R(θ’|X)取最小值的θ的估计值θ’称为θ的贝叶斯估计。

⑵Bayes学习:

Bayes学习不是进行参数估计,而是进行总体概率密度的推断以获得总体分布p(x|X),因此它们具有某些相同的计算过程和内容,也有不同的计算目标。

即Bayes学习是在执行完Bayes估计的前3步得到θ的后验概率p(θ|X)之后不是去求θ’,而是求总体x的后验概率p(x|X)。

⑶关系:

①贝叶斯估计

将θ看成为随机的未知参数,且θ具有先验分布P(θ),样本通过l(θ)并利用Bayes公式将θ的先验分布P(θ)转为后验分布。

p(θ|X)包含了关于θ的先验信息及样本提供的后验信息,在规定损失函数是一个二次函数(即平方误差)情况下,求出θ’。

②贝叶斯学习

利用θ的先验分布及样本提供的信息求出θ的后验分布p(θ|X),然后直接求总体分布。

4.Parzen窗口原理(P67)?

窗函数的选择?

⑴

此φ函数被称为Parzen窗函数,其含义为如果一个样本Xi落入窗口,则φ=1(即计数为1),否则φ=0(即计数为0)。

换句话说,就是检查d维空间中的每一个样本Xi,如果向量X-Xi中的每一分量都小于hN/2,则该样本必在VN以内(且计数为1),否则就在VN以外(且不计数)。

故落入VN内的样本数为:

这样可得X点处概率估计为

这就是Parzen窗法估计的基本公式。

⑵窗函数选择:

1方窗函数:

2②正态窗函数:

③指数窗函数:

④三角窗函数:

⑶未知密度P(x)、窗函数φ(u)和窗宽hN设置一些条件

1)总体密度P(x)在X处连续;

﹡(填空)2)窗函数应满足的条件:

①

②

③

④

3)窗宽限制:

⑤

⑥

4)对样本的要求:

⑦

⑧

●P813.23.63.10

第四章

1.线性判别函数的形式?

广义线性判别函数的形式?

线性判别函数的优点?

⑴线性判别函数:

对于d维特征空间中的不同模式类别分别给出一个由d个特征组成的单值函数,这称为判别函数。

其一般表达式为:

g(X)=WTX+W0

其中其中:

X是d维特征向量(亦称样本向量)。

X=[x1,…,xd]T

W称权向量。

W=[w1,…,wd]T

W0是个常数,称为阀值权。

⑵广义线性判别函数:

对上述问题可建立一个二次判别函数

g(X)=(X-a)(X-b)

对应的决策规则就是:

如果g(X)>0,则决策X∈W1;

如果g(X)<0,则决策X∈W2。

二次判别函数的一般形式可写为:

如果适当选择X→Y的映射,则可将X的二次判别函数转化为Y的线性函数。

式中:

g(X)=

称为广义线性判别函数,称为广义权向量。

⑶线性判别函数的优点:

简单,容易实现,而且需要的计算量和存储量小。

因此,可以认为,线性判别函数是统计模式识别的基本方法之一,也是实际应用中最常用的方法之一。

2.什么是最优分类器?

什么是次优分类器?

常用线性分类器准则函数的选择?

⑴贝叶斯分类器可以看成以错误率或风险为准则函数的分类器,它是错误率或风险达到最小,我们通常称这种分类器为最优分类器。

而其它准则函数下得到的分类器称为“次优”分类器。

⑵准则函数:

Fisher准则,感知准则,最小错分样本数准则,最小平方误差准则(MSE)和最小错误率线性判别函数准则。

3.样本规范化

若样本集Y1,···,YN是线性可分的,则必存在某个/些权向量a,使得

若 aTYi>0则Yi∈ω1; 若 aTYj<0 则Yj∈ω2。

若令Yj′=-Yj,则上式可写为:

aTYn′>0样本的规范化式

其中YiYi∈ω1

Yn′=

-YjYj∈ω2

yn′代表全部样本,其称为规范化增广样本向量。

4.什么是解向量?

解区?

如何对解区进行限制?

解向量:

满足aTYn>0(n=1,···,N)的权向量a称之为解向量。

解区:

由于每个超平面把权空间分为两个半空间,所以解向量如果存在,必在N个正半空间的交迭区,而且该区中的任意向量都是解向量。

因此解向量往往不只一个,而是由无穷多个解向量组成的区域(该区称为解区)。

对解区的限制:

目的是:

使解向量更可靠。

一般,越靠近解区中间的解向量,越能正确分类。

所以,引入余量b>0。

使aTYn≥b的解向量即为限制后的解向量。

而aTYn≥b>0所产生的新解区位于原解区之中。

5.梯度下降迭代公式?

式中

是一个正的比例因子,称为步长或增量。

6.对于线性可分类样本集可用什么函数方法解决?

对于不可分类样本集用什么方法?

(找不到,自己看吧P91)

7.在什么条件下最小平方误差(MSE)准则等价于Fisher准则?

在什么情况下最小误差准则逼近贝叶斯判别函数?

(1)当

时,MSE解a*等价于Fisher解。

(2)令b=(1,1,···,1)T(N个1),当样本数N→∞时,MSE解以最小均方误差逼近Bayes判别函数。

g0(X)=p(ω1|X)-p(ω2|X)

图4.1

H是决策面,其方程为g(X)=0。

W是权向量,其是H的法线方向。

X是待识别的模式的特征向量(图中X落入R1区域中,即被分到W1类中去)。

对待识模式X,若将X带入判别函数,则判别函数值g(X)是特征空间中一/某点X到超平面H的距离的度量。

图中W0,g(X)均为代数量,

用于求距离,与方向无关

向量X可以表示为:

式中:

XpX向量是超平面H的法线方向。

向量Xp是X在H上的投影向量。

由于Xp是H上的一点,所以

是W(权向量)方向上的单位向量,而

r是X到H的垂直距离。

r是待求的距离,且r是一个代数量,r的正负反应了X位于H的正负侧(即当X在H的正侧时,r为正;反之,r为负)。

。

据上式可得:

或写成为

如果g(X)>0,则X在H的正侧;

如果g(X)<0,则X在H的负侧。

▪若X为原点,有:

则从原点到超平面H的距离r0为:

▪如果W0>0,则原点在H的正侧;反之,原点在H的负侧;如果W0=0,则g(X)=WTX(齐次形式)说明H过原点。

总之,线性判别函数进行(两类)模式分类时:

1用超平面H将特征空间分割成两个区域;

2H的方向由权向量W确定,H的位置由阀值权W0确定。

3g(X)值正比于X点到H的(代数)距离(有正负)。

4当X在H正侧时,g(X)>0;在负侧时,g(X)<0。

习题P1173.24.14.2

第五章

1.非线性判别函数有几种方法?

基于距离的分段线性判别函数、分段线性判别函数、用凹函数的并表示分段线性判别函数、用交遇区的样本设计分段线性分类器。

2.简述树状分类器的训练过程,决策过程。

(画图)

先用两类线性判别函数算法找一个权向量a1,其所对应的超平面H1将整个样本集分成两部分(即样本子集)。

因为每一部分仍含两类样本,所以接着找出第二、三、四个权向量a2、a3、a4,对应的超平面H2、H3、H4分别把相应的样本子集分成两部分。

这时把两类样本完全分开。

这样得到的分类器显然是分段线性的,其决策面如图5.5所示。

这种情况下的识别过程是一个树状结构。

见图5.6

图5.6

3.什么叫交遇区?

局部训练法?

紧互对原型对概念?

(1)交遇区:

当两类样本非线性可分时,贝叶斯分界面一般通过两类样本十分靠近或相互交迭的区域,我们称之为交遇区。

(2)局部训练法:

把交遇区中的交迭区和靠近区找出来,利用这些区域中的样本作为新的样本集设计现行判别函数,然后把它们连在一起,就构成了一个分段线性判别函数。

这种方法称为“局部训练法”。

(3)紧互对原型对:

用

表示两个互对的原型之间的欧式距离,而当且仅当

满足

时,

称为紧互.2原型对(必须是不同类的原型)。

习题P1345.2

第六章

1.最近邻法的概念?

缺点?

(1)概念:

设有c类模式样本,ω1,ω2,……,ωc,每类有Ni个样本(i=1,2,……,c),则最近邻法的(ωi类)判别函数为:

式中

表示ωi类中的第k个样本。

对应的决策规则为:

如果

则决策

即只要将待分样本X与全部N(

)个已知类别的样本进行欧氏距离之间的比较,然后将X归到离它最近的类别中。

由于这种方法只根据离待分样本X最近的一个样本的类别而决定其类别,所以通常称为1-最近邻法(亦称1-NN方法)

(2)缺点:

最近邻法是一种次优方法,它的错误率比最小错误概率的Bayes决策规则下的错误率要大,但是,当样本数目无限时,它的错误率不会超过Bayes错误率的一倍。

2.k-近邻法的概念?

这些改进解决了什么问题?

存在的问题以及如何改进?

(1)概念:

为了克服单个样本类别的偶然性以增加分类的可靠性,可将最近邻法则进行改进,一个简单的方法就是k-近邻法。

此法就是考察待分样本X的k个最近邻样本,这k个最近邻元素中哪一类的样本最多,就将X判属哪一类。

或者说,就是在N个已知类别的样本中,找出X的k个近邻,这k个近邻中多数属于的那一类

,就是

。

具体就是:

设k1,k2,......,kc分别为X的k个最近邻样本中属于

类的样本数,类的样本数,则定义

类的判别函数为:

决策规则为:

如果

则判

(2)存在问题:

最近邻法和k-近邻法的共同优点是简单,而且结果是比较好的,但是它们也存在下述问题:

①需要将全部样本存入机器中,每次决策都要计算X与全部样本间的距离并进行比较。

所以要求的存储容量和计算量都很大。

②没有考虑到决策的风险,所以如果决策的错误代价很大时,会产生很大的风险。

③上述分析是建立在样本数

的假定上的,这在实际应用中是无法实现的。

(3)改进:

近邻法的快速算法、剪辑近邻法、压缩紧邻法。