分布式存储解决方案Word格式.docx

《分布式存储解决方案Word格式.docx》由会员分享,可在线阅读,更多相关《分布式存储解决方案Word格式.docx(10页珍藏版)》请在冰豆网上搜索。

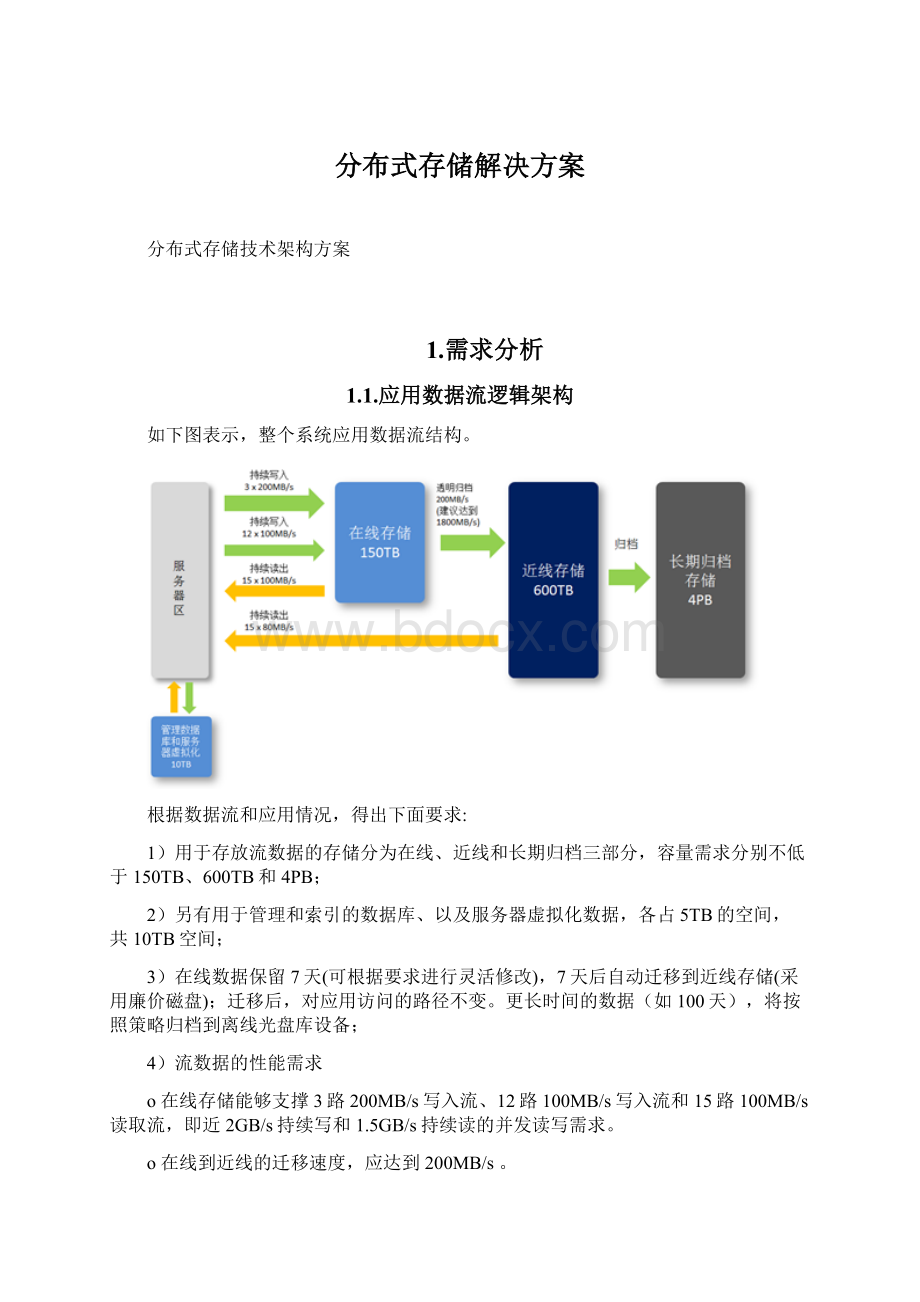

流数据为典型的顺序I/O,OLTP类型管理数据库根据程序类型,存在随机和顺序I/O多种情况,服务器虚拟化在存储介质中表现为封装好的文件,具备空间局部性特征。

国际主流数据中心建设模式倾向扁平化、大二层组网,融合架构兼具可控性和高扩展性,因此建议合并部署。

1)流数据部署在高性能分布式存储–提供极高的I/O吞吐性能,并按照在线、近线和离线三部级存储进行署。

下面的文字将主要对这部分需求进行讨论和分析。

2)管理数据库部署在通用磁盘阵列存储上,提供高效的OLTP性能、集成于应用的管理和数据保护功能。

这部分存储容量需求为5TB,主流的企业级存储都可满足要求。

3)服务器虚拟化部署在高性能分布式存储上,充分利用分布式存储性能优势和数据多副本优势,提供高可靠的集群文件系统功能。

由于虚拟化服务器主要使用计算资源,而分布式存储I/O需求较大,有效利用技术优势,利用Hypervisor底层充分整合分布式存储,构建智能的软件定义的数据中心。

1.2.2.在线和近线存储性能分析

在线存储可用容量需求为150TB。

性能方面,用于生产的性能需求为:

并发达到1.8GB/s的持续写入和1.5GB的持续读取。

1、近线存储性能指标:

这就要求,近线存储能够满足以下的并发I/O要求:

1.8GB/s的写入,同时还有1.2GB/s的读取,以及向磁带库(三级存储)的归档。

由于读、写是同时进行,因此在进行存储选项和规划时,考虑一定产品指标因素,建议最大写性能2倍处理,即3.6GB/s写为选型指标。

2、在线存储性能指标:

同理,对于在线存储的并发I/O要求:

1.8GB/s的持续写入和1.5GB的持续读取,可选取3.6GB/s最大写入性能为标准。

但需要注意的是在部分部件损坏后,该存储必须能够满足生产性能要求。

因此,在线存储必须考虑较多的性能余量,因此可将选型标准定为最大写入性能5GB/s或者更高。

1.2.3.在线和近线存储容量需求分析

在线和近线存储的容量规划,是根据数据保存策略估算,规划中真正使用空间是总容量的80%左右,确保存储容量、稳定性和数据应用的安全。

1、在线存储容量分析

在线存储保存7天数据容量=21.4TB*7=150TB。

从数据保留在在线存储的策略评估,进行最大化估算,3路200MB/s写入流、12路100MB/s写入流,总共需持续最大化写入1.8GB/s,但是平均写入数据较低,21.4TB/60(1分钟60秒)*60(1小时60分钟)*24(1天24小时)=247MB/s(每秒写入数据)

分布式存储提供了多副本机制保证数据高可靠,考虑到性能和安全性,设置两份副本,150TB在线数据量共需要300TB存储空间。

2、近线存储容量需求分析

近线存储数据容量为600TB。

近线存储容量,是根据数据迁移策略和数据归档策略的定义情况来平衡并评估出需要的容量,即每天从在线存储中迁移150TB(最大化)容量到近线存储,在线数据7天自动迁移近线存储,因此写满一次近线数据周期为一个月。

2.分布式存储系统架构设计

2.1.分布式存储物理架构拓扑

方案以融合架构为基础,充分结合分布式数据特征,利用物理硬件资源的不同使用消耗,整合存储、计算、网络资源,实现软件定义IT。

2.2.分布式存储架构设计说明

2.3.1.纵向分区设计

计算密集区,主要提供分布式存储架构中的计算用途。

计算功能:

部署20台存储服务器。

确保计算优先,即运行流数据业务的虚拟机,在线存储能够支撑3路200MB/s写入流、12路100MB/s写入流和15路100MB/s读取流,即近2GB/s持续写和1.5GB/s持续读的并发读写需求。

每服务器系统盘本地部署,建议SATA硬盘RAID1;

存储功能:

提供分布式存储数据环境,考虑横向连池,与其他两区存储硬盘配置相同,建议500GBSSD高速存储。

数据管理区,主要提供分布式存储架构中的数据库管理和虚拟机管理。

数据库管理建议以虚拟机形式部署,近线存储介质中划分5TB空间,以裸设备形式映射给Hypervisor,满足OLTPI/O要求。

虚拟机集群管理通过vCenter建立状态,实现HA功能,完成计算资源的高可用。

并且可根据实际软件资源响应情况,灵活调整计算资源,在业务连续运行状态下实现动态迁移。

迁移归档区,提供在线数据到近线数据迁移,近线数据到归档存储迁移。

在线到近线的迁移速度,应达到200MB/s,近线存储读取速度,可以达到单路80MB/s,支持大于15路读,总共1.2GB/s读。

在线到近线的迁移利用Hypervisor存储迁移功能,在虚机开机状态下迁移数据业务。

归档迁移利用第三方备份软件或光盘塔实现。

2.3.1.横向互联设计

管理千兆网,实现虚拟机管理,数据库管理,虚拟机迁移和集群通信四大功能。

千兆以太网建议专网专用。

Hypervisor主机采用SSD,以SSD硬盘为介质的存储池承担在线存储,提供的巨大的吞吐量和高速的读写性能,满足项目中对在线存储读写性能的需求。

生产万兆网,运行虚拟机业务系统,联通服务器区向在线存储区读写职能。

提供1.8GB写,1.5GB读。

在线万兆网,两台万兆网络交换机(外网)通过堆叠技术(可横向扩展),实现两台万兆交换机双活应用,即两台万兆交换机同时工作,充分发挥网络性能和应用带宽性能。

每个存储节点通过至少捆绑两个万兆端口,并连接存储外部网络万兆交换机,实现单个存储节点供应用直接读取带宽至少为物理20GBps。

近线FC网,提供SSD在线数据向SATA盘阵200MB/s写入,和服务器区从近线存储1.2GB/s读。

建议多路径FC交换机。

以大量的SATA硬盘为介质的存储池承担近线存储,提供满足业务需求的容量,同时也提供巨大的吞吐量,满足项目中对近线存储读写性能需求。

离线千兆网,以带库方式或光盘塔方式完成长期数据归档要求,共4PB。

2.3.分布式存储架构特征

2.3.1.扩展性和高性能

分布式集群存储利用双重特性(多副本)来提供几TB至数PB的高扩展存储解决方案。

Scale-Out架构允许通过简单地增加资源来提高存储容量和性能,磁盘、计算和I/O资源都可以独立增加,支持10GbE高速网络互联。

弹性哈希(ElasticHash)解除了分布式存储对元数据服务器的需求,消除了单点故障和性能瓶颈,真正实现了并行化数据访问。

2.3.2.负载自动均衡技术

分布式存储采用无中心服务器架构模式来管理整个分布式存储文件系统,所有元数据和数据均保存在各个节点上,文件则划分为多个块存储在不同的存储节点上。

管理节点维护了一个统一的命名空间,同时掌握整个系统内存储节点的使用情况,当客户端向元数据发送数据读写的请求时,根据存储节点的磁盘使用情况、网络负担等情况,选择负担最轻的存储节点对外提供服务,自动均衡负载负担。

另外,当有一个存储节点因为机器故障或者其他原因造成离线时,节点会将此机器自动屏蔽掉,不再将此存储节点提供给客户端使用,同时存储在此存储节点上的数据也会自动的备份到其他可用的存储节点上,自动屏蔽存储节点故障对系统的影响。

2.3.3.高可用性

分布式存储可以对文件进行自动复制,如镜像或多次复制,从而确保数据总是可以访问,甚至是在硬件故障的情况下也能正常访问。

自我修复功能能够把数据恢复到正确的状态,而且修复是以增量的方式在后台执行,几乎不会产生性能负载。

2.3.4.全局统一命名空间

全局统一命名空间将磁盘和内存资源聚集成一个单一的虚拟存储池,对上层用户和应用屏蔽了底层的物理硬件。

存储资源可以根据需要在虚拟存储池中进行弹性扩展,比如扩容或收缩。

当存储虚拟机映像时,存储的虚拟映像文件没有数量限制,成千虚拟机均通过单一挂载点进行数据共享。

虚拟机I/O可在命名空间内的所有服务器上自动进行负载均衡,消除了SAN环境中经常发生的访问热点和性能瓶颈问题。

2.3.5.弹性哈希算法

分布式集群存储采用弹性哈希算法在存储池中定位数据,而不是采用集中式或分布式元数据服务器索引。

在其他的Scale-Out存储系统中,元数据服务器通常会导致I/O性能瓶颈和单点故障问题。

所有在Scale-Out存储配置中的存储系统都可以智能地定位任意数据分片,不需要查看索引或者向其他服务器查询。

这种设计机制完全并行化了数据访问,实现了真正的线性性能扩展。

2.3.6.弹性卷管理

数据储存在逻辑卷中,逻辑卷可以从虚拟化的物理存储池进行独立逻辑划分而得到。

存储服务器可以在线进行增加和移除,不会导致应用中断。

逻辑卷可以在所有配置服务器中增长和缩减,可以在不同服务器迁移进行容量均衡,或者增加和移除系统,这些操作都可在线进行。

文件系统配置更改也可以实时在线进行并应用,从而可以适应工作负载条件变化或在线性能调优。

2.3.7.基于标准协议

存储服务支持NFS,CIFS,HTTP协议,完全与POSIX标准兼容。

现有应用程序不需要作任何修改或使用专用开放的API,就可以对分布式存储中的数据进行访问。

2.4.存储内部数据透明迁移设计

存储以虚拟化存储概念整合成一个大的存储,分在线存储池(SSD硬盘介质)和近线存储池(SATA磁盘介质),设置在线存储数据保留周期策略,例如7天,数据分多路经过集群应用服务器处理后,持续写入到在线存储池保存,通过存储系统内部检测和判断,发现超过7天的数据,存储内部通过数据分层保存机制,自动迁移数据至近线存储池保存。

而近线存储池的数据也需设置数据保留周期策略,通过第三方归档软件,把近线存储池中超过生命周期的数据,自动迁移至永久保存介质,进行长期保存。

虚拟化存储池具备下面使用和数据透明迁移:

1、当在线存储池的容量有可用容量时,所有从应用服务器至虚拟化存储池的写入的数据直接保存至在线存储池中。

通过存储自动迁移机制,把在线存储池的数据(超过保留生命周期)迁移至近线存储保存,保持数据路径不变。

2、当在线存储池的容量没有可用容量时,所以从应用服务器至虚拟化存储池的写入数据直接透明地保存至近线存储池中,杜绝在线存储池容量不足可能导致应用业务中断的风险。

3、应用服务器集群可直接从在线存储池中读取数据(在线存储池中的数据在7天在的保留周期内),也可直接从近线存储读去数据(超过7天,少于90天(或自定义一定的生命保留周期))。

2.5.数据归档设计

“数据归档”这块,是通过利旧现有第三方归档软件和新的光盘塔系统,与万兆网络与分布式存储连接,按近线存储池中的数据保存生命周期,接受存储迁移的调度命令,主要完成把超出生命周期的数据从近线存储池的原始存储位置迁移到目标光盘塔介质位置的工作。

同时也负责整个恢复过程的执行,完成分布式存储与光盘塔系统之间的数据归档与恢复。

2.6.运维和监控管理

直观、高度集成的WEB统一管理平台,对存储平台存储节点服务器、网络设备、硬盘等核心组成部分,进行实时的监控存储设备管理和运行日志保存、策略管理等管理工作,实现报警、故障日志Mail发送,使运维工作变得更简单高效,满足运维管理的标准。

提供开放的API接口,与整个监控管理平台集成耦合,形成统一的运维监控界面,利于集中、统一、高效的运维管理。

3.分布式存储架构性能估测

分布式存储是一款基于万兆网络和X86服务器组成分布式存储,整个存储读写带宽、IOPS性能,可以理解为由组成存储的节点带宽组成单节点吞吐量、单节点硬盘介质的IOPS组成节点性能,整个集群的节点性能近线性性能的累加,组成集群的整体性能。

3.1.系统架构及性能组成

3.1.1.在线万兆网

1).两台或两倍以上的万兆网络交换机(外网)通过堆叠技术(可横向扩展),实现两台万兆交换机双活应用,即两台万兆交换机同时工作,充分发挥网络性能和应用带宽性能。

2).每个存储节点通过至少捆绑两个万兆端口,并连接存储外部网络万兆交换机,实现单个存储节点供应用直接读取带宽至少为物理20GBps。

3).同理,单个存储节点内部数据交换网络数据交换网络(通过交换机堆叠技术横向扩展)至少也为物理上20GBps。

4).通过划分几个存储节点为一个ZONE(安全划分),每个ZONE提供20GBps,总体存储吞吐量带宽=ZONE的数量*20GBps。

5).相应的一批光纤模块和尾纤

3.1.2.存储设备与性能

1)、在线存储主机配置

每存储节点由配置多磁盘的X86存储服务器,支持24个SSD盘位,并通过HBA卡支持连接SATA磁盘阵列。

每个存储节点磁盘配置:

24(槽位)*512GBSSD

∙在线存储池可用容量=25*24*512GB=300TB(做双副本处理)

2)、近线存储盘阵配置

采用8GB主机通道,双控存储盘阵,多链路设置,挂载数据管理区和迁移归档区服务器,根据实际情况,可灵活调配两个区域服务器,完成在线向近线的数据处理,全SATA磁盘600TB容量

3.2.分布式存储性能估算

1)、存储硬盘参数

根据目前市场主流设备参数,设定三种硬盘的性能参数如下(实际参数值以项目采购的实际型号为准,以下数值仅供参考):

类型

容量(TB)

IOPS(次/秒)

SAS

0.6

150

SATA

4

90

SSD

0.512

3000

2)、存储节点性能参数

✓在线存储性能最小化估算

∙在线存储池的SSD盘IOPS性能参数

24(个SSD使用硬盘)*25(台存储节点)*3000(IOPS值)=1800000

经过分布式存储聚合成存储池,磁盘介质后的集群管理损耗30%(最大值)估算,能提供1,160,000IOPS。

∙吞吐量

结合IOPS,每个存储服务器节点能平均提供700MB/s(写)吞吐量,并且这一数值随着集群节点的增加而线性增长。

考虑10%性能损坏。

在线存储池总的吞吐量为25*700MB/S*90%=15750MB/s=15.7GB/s

✓近线存储性能最小化估算

∙近线存储池的SATA盘IOPS性能参数

150(采用4TBSATA硬盘)*5(台存储节点)*90(IOPS值)=67,500

经过分布式存储聚合成存储池,磁盘介质后的集群管理损耗30%(最大值)估算,能提供47,250IOPS

∙近线存储池的吞吐量

服务器处理直接读取近线存储,基本每存储节点能平均提供300M/s(写,最小化)吞吐量,并且这一数值随着集群节点的增加而线性增长。

近线存储池总的吞吐量为25*300MB/s=7500MB/s=7.5GB/s

3.3.方案提供的存储性能与需求存储性能比较

序号

项目

子项

需求值

配置满足值

1

吞吐量

在线存储池吞吐量(写,从服务器直接持续写入在线存储)

5.0GB/s

15.7GB/s

近线存储池吞吐量(写,从在线存储数据透明迁移至近线存储)

3.6GB/s

7.5GB/s

3

在线存储容量

在线存储每天至少为21.4TB数据容量写入,最大写入为150TB,保留7天

150TB

300TB(双副本)

4

近线存储容量

在线数据保留7天,迁移至近线存储

600TB

4.参考配置

配置

数量

主机

E52650v2*2,128GDDR3,500GSATA*2,500GSSD*24,万兆网卡*3,千兆网卡*3,8GBHBA卡

25

万兆交换机

48端口

3

千兆交换机

2

FC交换机

16端口

磁盘阵列

600GBSATA

磁带库或光盘塔

4PB