完整word版Logistic statistic modelWord格式文档下载.docx

《完整word版Logistic statistic modelWord格式文档下载.docx》由会员分享,可在线阅读,更多相关《完整word版Logistic statistic modelWord格式文档下载.docx(14页珍藏版)》请在冰豆网上搜索。

不是最大值,是最大可能性)。

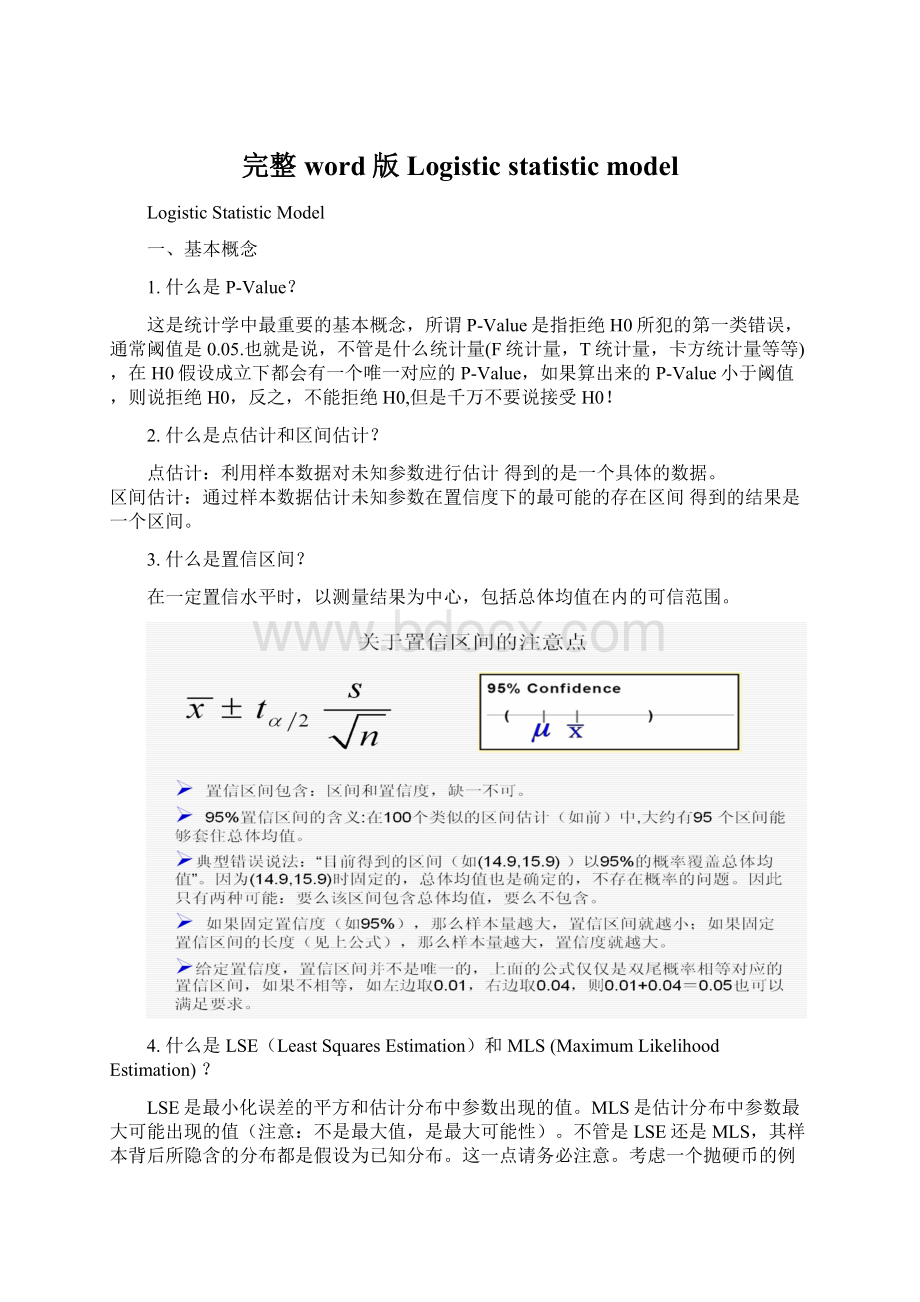

不管是LSE还是MLS,其样本背后所隐含的分布都是假设为已知分布。

这一点请务必注意。

考虑一个抛硬币的例子。

假设这个硬币正面跟反面轻重不同。

我们把这个硬币抛80次(即,我们获取一个采样

并把正面的次数记下来,正面记为H,反面记为T)。

并把抛出一个正面的概率记为p,抛出一个反面的概率记为1−p(因此,这里的p即相当于上边的θ)。

假设我们抛出了41个正面,39个反面,即41次H,39次T。

由于它背后隐含的是二项分布,使用最大似然估计,通过这些试验数据(即采样数据),我们可以计算出哪个硬币的可能性最大。

这个可能性函数取以下三个值中的一个:

可以计算,当p=1/2时,可能性函数取得最大值。

这就是P的最大似然估计.

5.选择预测模型时一定要考虑响应变量分布吗?

不一定:

当我们只预测响应变量的点估计时,不需要考虑,此时点估计的值只和你假定的Y与X之间的关系有关,于Y是什么分布无关。

可以通过LSE或者MLS来估计Y的值。

但是如果我们要预测Y值的区间估计,或者要对预测系数进行显著性检验时,就需要考虑Y是什么分布了。

二、logistic回归模型

假设在自变量X1,X2,…,Xn作用下,某事件发生的概率为P,则该事件不发生的概率为1-P,P/1-P为发生概率和不发生概率之比,记做“优势”(Odds),若对Odds取自然对数,得到:

称为P的logit变换,则logistic回归模型为:

则概率计算公式为:

Logistic回归模型与一般线性回归模型的区别:

第一,线性回归模型的结果变量(outcomevariable)或因变量(dependentvariable)或反应变量(responsevariable)与自变量之间的关系是线性的,而Logistic回归中因变量与自变量之间关系是非线性的。

第二,在线性回归中通常假设,对应自变量X的某个值,因变量Y的观测值具有正态分布,但是在logistic回归中,因变量Y却是二项发布(0和1)或多项分布。

第三,在logistic回归中,不存在线性回归中有的残差项。

三、Logistic回归模型估计方法论和假设条件

Logistic回归模型估计采用是MLS方法论来估计参数。

其假设条件与LSE回归比较类似。

第一,数据必须来自随机样本。

第二,因变量Y被假定为K个自变量的函数。

第三,自变量是确定性变量,不是随机变量。

第四,正如LSE回归,logistic回归也对多元共线性(muliti-collinearity)敏感。

自变量之间存在多元共线性也会导致标准误的膨胀。

但是还有一些与LSE不同的假设:

第一,因变量Y是分类变量,研究的兴趣是在X发生时事件发生的条件概率。

第二,自变量和因变量之间是非线性关系,可以通过Logit函数转换成线性关系。

第三,在LSE回归中对残差要求独立同分布(IID),但在logistic中却不需要,因为logistic没有残差项。

四、logistic回归模型评价

在实际应用中,人们往往只对回归模型自身的“好坏”以及回归系数的显著性关注,评价回归模型“好坏”的主要指标有:

1.拟合优度(goodnessoffit)

拟合优度度量的是预测值和观测值之间的一致性。

但是在评价模型时,实际上测量的是预测值和观测值之间的差别,也就是说,我们实际上检验的是模型预测的“劣度”,而不是“优度”,即拟合不佳检验(lackoffittest)。

常用的两个指标:

Hosmer-Lemeshow指标和信息测量指标(InformationMeasures)。

1.1HL指标是一种类似于皮尔逊卡方统计量的指标,其对应的H0是预测值概率和观测值之间无显著差异,所以,如果HL指标显示较大的P-Value,说明统计结果不显著,因此,我们不能拒绝关于模型拟合数据很好的假设,换句话说,模型很好的拟合了数据。

在SAS中调用LACKFIT选项命令。

1.2IM指标中比较著名的是AIC,在其它条件不变的情况下,较小的AIC值表示拟合模型较好。

在SAS中还提供了另外一种IM指标SC,SC指标是对AIC指标的一种修正,与AIC同向作用。

2.模型卡方统计(ModelChi-SquareStatistic)

模型卡方统计检测的是模型中所包含的自变量对因变量有显著的解释能力,也就是说所设模型要比零假设模型(即只包含常数项的模型)要好,在多元线性回归和ANOVA中,常用F检验达到目的。

在Logistic中用似然比检验(likelihoodratiotest),你可以吧它近似当作F检验,在SAS输出结果中就是Likelihoodratio对应的值。

需要注意的是,模型卡方值和拟合优度是两个完全不同的概念:

前者度量的是自变量是否与因变量的ODDS线性相关,而后者度量的是预测值和观测值之间的一致性。

所以,按照理想情况,最好是模型卡方统计性显著而拟合优度统计性不显著。

如果发生不一致,我们更优先关注前者。

3.预测准确性

模型卡方统计关注的只是相对于零假设模型而言,所设模型显著不显著,它只是从总体上考虑了模型的显著性,但是所有X变量到底能解释多少Y变量的波动?

这是预测准确性的问题。

有三种方法:

3.1类RSQUARE指标

在线性回归中,可以用RSQUARE来度量,显然RSQUARE越高说明预测越好,在logistic中,也有类似的指标,在SAS中调用命令RSQ即可。

Logistic中的RSQUARE也有许多重要的性质:

1)与经典的RSQUARE定义一致。

2)它可以被理解为Y变异中被解释的比例。

3.2C统计量

但是,在实际应用中,人们往往更关心观测值和模型预测的条件事件概率的关联强度,拟合优度只是给出了观测值和预测概率之间的差别程度,然后给出一个总体评价的指标,但是对于哪些个体的预测概率接近观测值,哪些个体的预测概率远离观测值,拟合优度并没有给出答案。

C统计量是用来度量每个个体是否接近观测值的重要指标。

举例说明:

事件发生(Y=1)且预测发生概率:

0.8;

0.2;

0.5;

0.7;

0.9

事件不发生(Y=0)但预测发生概率:

0.3;

0.1;

0.7

其中的预测概率可以通过调用SAS中的OUTPUT选项和P=命令实现。

4.AIC,SC,-2LOGL,RSQUARE和LikelihoodRatio之间的关系

关系如下:

其中:

类似于线性回归中总平方和;

类似于误差平方和。

K为当前模型中自变量的个数;

S为反应变量类别总数减1;

N是观测数。

验证如下:

5.模型评价各项指标总结如下表:

五、logistic回归系数解释

当模型能够较好的拟合数据的时候,我们就可以对回归系数进行解释了。

由于回归系数解释和多元线性回归几乎一样,所以此处请大家参考相关书籍,这里只重点介绍两点:

5.1关于ODDS和ODDSRATIO

这两个概念是logistic独有的。

ODDS定义在前面已经说过,ODDSRATIO指两个Odds之比。

用以衡量自变量对响应变量的作用大小。

5.2关于变量的重要性衡量

变量的重要性必须通过标准化回归系数来衡量。

在SAS中调用STD命令实现。

5.3关于回归系数的显著性检验

假设有如下一段SAS程序:

我们只关注回归系数的显著性,如下图:

SAS对回归系数显著性检验默认为WALD检验。

其中分母是分子的标准误,对应下表如:

分子=67.6339;

分母=56.8875,

Pr>

ChiSq是对应的P-VALUE.在SLE=0.30和SLS=0.35条件下,这四个变量都通过了显著性检验。

现在我们来考虑一个极端的例子:

现假设构造一个虚拟自变量TEST=remiss,修改SAS程序如下:

系数输出结果如下:

很容易看出,所有系数都没有通过显著性检验。

让我们再单独对test做回归:

同样,我们看到test也没有通过显著性检验,这就让我们感到很诧异,从直观上说,既然test=remiss,说明test和remiss之间存在完全的正相关关系,那么在所有的上述变量中,TEST预测力相对应该最强,那为什么系数没有通过显著性检验呢?

这就要涉及到WALD检验的局限性,WALD有一个很不好的性质,就是当回归系数很大时,SE就会相应的膨胀,这样导致整个W统计量变小,从而P-VALUE变大。

也就是说,实际上我们是完全可以拒绝H0,但是却没有拒绝。

如果我们做一个线性回归方程,就会明白:

结果如下:

可以看出,由于回归方程用的是T检验,所以P-VALUE很小,系数显著。

而且通过比较上述两个结果,我们可以知道SE的计算方法是不一样的。

但是,造成上述结果还有另外一个重要原因,那就是样本量太小,我们此处用的是SASHELP中的一个小样本,记录条数只有27条,如果我们扩大样本量,就会得出完全不一样的结论,即在大样本情况下,如果有自变量X和因变量Y之间确实存在完全的线性相关关系,则在最后的变量筛选中,IN2预测力仍然显示是最强的,不管用STEPWISE还是其它方法,结论都是这样。

而且此时C统计量是100.

结论:

在逻辑回归中,我们对结果的关注的重要性依次为:

TOP1:

似然比卡方(方程显著性检验);

TOP2:

C统计量;

TOP3:

回归系数检验。

六、筛选变量常用的四种方法

1.向前回归法:

首先第一个变量进入回归方程,并进行F检验和T检验,计算残差平方和,计为S1,如果通过检验,则该变量保留,引入第二个变量,重新构建一个新的估计方程,并进行F检验和T检验,同时计算残差平方和,计为S2.从直观上看,增加一个新的变量后,回归平方和应该增大,残差平方和相应应该减少,即S2小于等于S1,称S1-S2的值是第二个变量的偏回归平方和,直观的说,如果该值明显偏大,则说明第二个变量对因变量有显著影响,反之则没有显著影响。

前进法最大的缺点是最先引入方程的变量不会再剔出方程,是“终身制”的,这样会给后面引入的变量制造“歧视”。

SAS调用命令为:

SELECTION=FORWARDSLE=.

2.向后回归法:

同向前回归法正好相反,首先,所有的X变量一次性进入模型进行F检验和T检验,然后逐个删除不显著的变量,删除的原则是根据其偏回归平方和的大小决定去留。

如果偏回归平方和很大则保留,反之则删除。

后退法最大的缺点是可能会引入一些不重要的变量,再就是一旦变量被剔除,就再也没有机会进入方程。

是“淘汰制”的。

SELECTION=BACKWARDSLS=.

3.逐步回归法