神经网络课程设计报告Word格式文档下载.docx

《神经网络课程设计报告Word格式文档下载.docx》由会员分享,可在线阅读,更多相关《神经网络课程设计报告Word格式文档下载.docx(19页珍藏版)》请在冰豆网上搜索。

正线性

cS型函数(Sigmoid)

单极型和双极型

双曲正切y=tanh(n)

d径向基函数

高斯函数

三角波函数

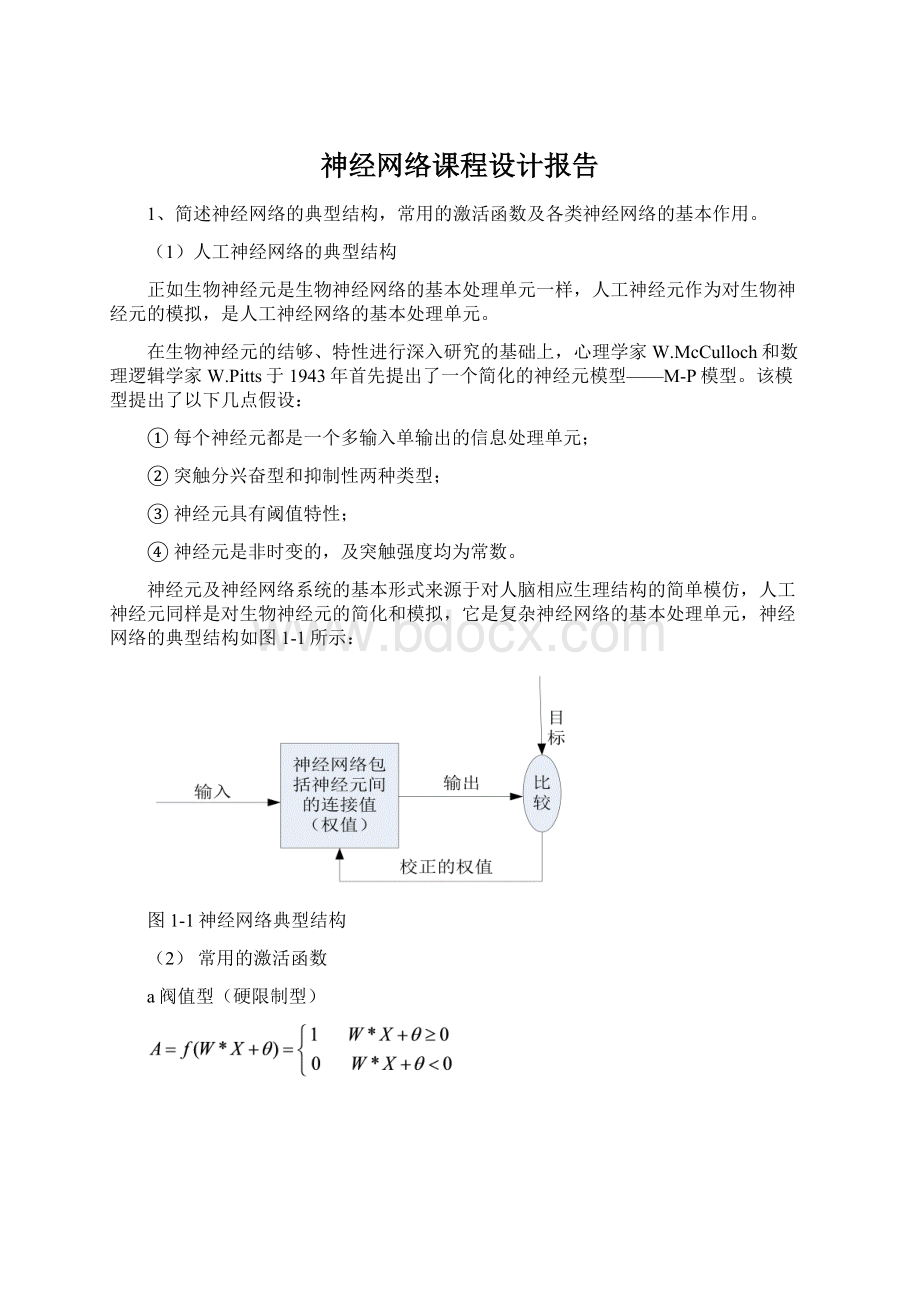

(3)各类神经网络的基本作用

神经网络的软件模拟和硬件实现的研究。

神经网络在各个领域中应用的研究。

这些领域主要包括:

模式识别、信号处理、知识工程、专家系统、优化组合、机器人控制等。

随着神经网络理论本身以及相关理论、相关技术的不断发展,神经网络的应用定将更加深入。

2、论述BP算法的基本思想,讨论BP基本算法的优缺点,以及改进算法的思路和方法。

(1)BP算法的基本思想

BP学习过程分为两个过程:

工作信号正向传播:

输入信号从输入层经隐含层单元传向输出层,在输出端产生输出信号。

在信号的传递过程中,权值是固定不变的。

每层神经元的状态只影响下一层神经元的状态。

如果在输出层不能得到期望的输出,则转入误差信号反向传播。

误差信号反向传播:

网络的实际输出与期望输出的差值为误差信号,误差信号由输出端开始逐渐向前传播。

在误差信号反向传播过程中,网络的权值由误差反馈进行调节。

通过权值的不断修正使实际输出更接近期望输出。

(2)BP算法优缺点

优点:

非线性映射能力。

多层前馈网能学习和存贮大量输入-输出模式映射关系,而无需事先了解描述这种映射关系的数学方程。

只要能提供足够多的样本模式对供BP网络进行学习训练,它便能完成由n维输入空间到m维输出空间的非线性映射。

泛化能力。

当向网络输入训练时未曾见过的非样本数据时,网络也能完成由输入空间向输出空间的正确映射。

这种能力称为多层前馈网的泛化能力。

容错能力。

输入样本中带有较大的误差甚至个别错误对网络的输入输出规律影响很小。

缺点:

需要较长的训练时间。

这主要是由于学习速率太小所造成的。

可采用变化的学习速率或自适应的学习速率来加以改进。

完全不能训练。

这主要表现在网络的麻痹上。

通常为了避免这种情况的产生,一是选取较小的初始权值,二是采用较小的学习速率。

局部最小值。

采用多层网络或较多的神经元,有可能得到更好的结果。

(3)改进的思路和算法

BP算法改进的主要目标是为了加快训练速度,避免陷入局部极小值和改善其它能力。

本节只讨论前两种性能的改进方法的有关内容。

带动量因子算法;

自适应学习速率;

改变学习速率;

作用函数后缩法。

3、试比较RBF与多层感知器,论述这两种网络的特点和差异。

RBF网络与多层感知器都是非线性前向网络,它们都是通用逼近器。

对于任一个多层感知器,总存在一个RBF网络可以代替它,反之亦然。

但是它们也有不同点:

RBF网络只有一个隐层,而多层感知器可以是一层也可以是多层。

多层感知器的隐层和输出层的神经元模型是一样的。

而RBF网络的隐层和输出层的神经元模型不同,而且在网络中起到的作用也不一样。

RBF网络的隐层是非线性的,输出层是线性的。

多层感知器解决非线性回归问题时,隐层是非线性的输出层是线性的。

在解决模式分类问题时,它的隐层和输出层通常都选为非线性的。

RBF网络的基函数计算的是输入向量和中心的欧氏距离,而多层感知器隐单元的激活函数计算的是输入单元和连接权的内积。

多层感知器是对非线性映射的全局逼近,而RBF网络使用局部指数衰减的非线性函数(如高斯函数)对非线性输入输出映射进行局部逼近。

这意味着,逼近非线性输入输出映射,要达到相同的精度,RBF网络所需要的参数要比多层感知器少得多。

由于RBF网络能逼近任意的非线性函数,可以处理系统内在的难以解析的规律性,并具有极快的收敛速度,因此,RBF网络有广泛的应用。

4、试比较和论述Hopfield网络与随机网络的工作原理,讨论网络状态变化稳定的条件。

Hopfield网络工作原理:

按照其用途来设计或训练网络的权值,很难避免出现伪状态,对于有用的吸引子,其吸引力的强、弱吸引域的大小也不同,而且网络是严格按照能量减小的方向运行的,这就容易陷入局部极小点,而无法跳出。

神经网络算法的基本思想:

网络运行向误差或能量函数减小方向运行的概率大,向误差或能量函数增大方向运行的概率存在,这样网络跳出局部极小点的可能性存在,而且向局部最小点收敛的概率最大。

网络状态变化稳定的条件:

若网络从某一时刻以后,状态不在发生变化,即

5、谈谈学习神经网络课程后的心得体会,你准备如何在你的硕士课题中应用神经网络理论解决问题。

通过这两个多月来宗老师对神经网络的讲解,我了解到了ANN在信号处理中应用相当广泛。

通过此课程的学习,我掌握了基本的BP网络的基本思想和MALTAB仿真设计以及对于其不足的改进。

同时了解到其他的网络结构,比如Hopfield的基本思想以及应用。

学习一种新知识,掌握算法思想比具体的编程和应用更重要,授之以渔不如授之以鱼。

由于人工神经网络在通讯信号处理、语音信号处理、声纳信号处理、心电信号处理、图像处理等方面应用广泛。

待选定课题以后可能结合具体的应用方面进一步深入学习神经网络。

实验四用于函数逼近的多层感知器设计

1研究目的及意义

数值逼近是指给定一组数据,用数学分析的方法来分析这组数据,常用的数学分析方法有多项式拟合和插值运算。

还有一种常用的方法就是运用人工神经网络的有关理论,建立合适的神经网络来逼近给定的数据。

人工神经网络(ArtificialNeuralNetwork,ANN)是由大量神经元互相连接而组成的复杂网络系统,具有感知、记忆、学习和联想等功能,能模仿人脑处理信息的物理过程,具有大规模并行模拟处理、分布式存储信息、非线性动力学和网络全局作用,以及很强的自适应、自学习和容错能力等一些特点,因此成为一种强大的非线性信息处理工具。

在人工神经网络的实际应用中,80%~90%的人工神经网路模型采用基于误差反向传播算法(ErrorBackPropagation,BP算法)的多层前向神经网络(即BP网络)或他的变化形式。

BP是前馈网络的核心部分,体现了人工神经网络最为精华的部分,广泛应用于函数逼近、模式识别/分类、数据压缩等。

而本实验要做的工作即用多层感知器实现函数逼近。

2BP网络

2.1BP网络简介

BP网络是一种采用有教师学习算法的典型的多层前向神经网络。

它具有强大的计算能力,能够通过训练,掌握学习样本蕴涵的输入输出关系,它在预测和分类中都有着广泛的应用。

BP网络是一种多层前馈神经网络,包括输入层,隐层(中间层)和输出层,其中隐层可以是一层也可以是多层,一般而言,三层BP神经网络就可以解决大部分比较简单的问题。

BP网络前后层之间实现全连接,每层神经元之间无连接。

BP网络由输入层、隐含层和输出层组成,其学习过程分为2个阶段:

第一个阶段是输入已知学习样本向量,通过设置的网络结构和前一次迭代的权值和阈值,从网络的输入层经隐含层逐层处理,并传向输出层,逐次算出各层节点的输出。

第二个阶段是对权值和阈值进行修改,根据输出节点的实际输出与期望输出的误差(误差大于要求的精度),将误差信号沿原来的连接通道作反向传播,逐次修改网络各层权值与阈值使误差减小。

重复上述过程,直至网络的输出误差逐渐减小到允许的精度,或达到预定的学习次数。

图1是一个3层BP网络结构示意图。

图13层BP神经网络结构图

2.2BP梯度算法

前馈神经网络BP算法采用最速下降寻优算法,即梯度法。

假设有N对学习样本,采取批处理学习方法,目标函数:

,其中、分别为第对样本的期望输出和实际输出向量。

反映网络输出与样本的总体误差。

学习过程就是通过修改各神经元之间的权值,使得目标函数的值最小,权值按下列公式修正:

为学习速率。

2.3动量学习算法

该方法是在反向传播法的基础上在每一个权值的变化上加上一项正比于前次权之变化的值,并根据反向传播法来产生新的权值变化。

带有附加动量因子的权值调节公式为:

其中k为训练次数,mc为动量因子,一般取0.95左右。

附加动量法的实质是将最后一次权值变化的影响,通过一个动量因子来传递。

以此方式,当增加动量项后,促使权值的调节向着误差曲面底部的平均方向变化,当网络权值进入误差曲面底部的平坦区时,将变得很小,于是,

从而防止了的出现,有助于使网络从误差曲面的局部极小值中跳出。

梯度算法是动量因子的特殊情况。

2.3BP算法步骤

(1)将各权值、阈值置为小的随机数。

(2)从训练数据中挑选一组数据(、),将输入数据加到BP神经网络的输入层,T为预期输出数据,上标为训练数据号。

(3)由计算从第一层直至输出层各节点的输出,其中上标为BP网络的层标号,F为神经元的激励函数为BP网络层的节点的输出,为层的节点到层的节点的连接权值,。

(4)计算输出层每个节点的误差值,中表示训练的数据号,表示此训练号的输出层第节点的预期输出,表示输出层(层)第节点的实际输出。

(5)计算一层每个节点的误差值。

(6)依次计算前面各层每个节点的误差值。

(7)利用权值修正公式,修正所有神经元的联接权值。

,

称为学习速率,取值范围。

(8)利用阈值修正公式,修正所有神经元的阈值。

(9)返回

(2),输入下一组数据前重复

(2)~(8)的过程。

由此可见,BP算法的主要思路是从后向前逐层传播输出层的误差,并用此误差修正前层权值。

对于BP神经网络,有一个重要定理,对于任何闭区间内的连续函数,都可以用一个三层的BP网络逼近,本文要研究的问题就是BP网络的隐层神经元个数,神经元不同的传递函数及BP网络不同的训练函数对网络的性能影响。

3实验仿真

按照动量学习BP算法的执行步骤编写m函数,采用MATLAB工具箱,搭建SIMULINK系统模块,在不同的误差、隐含节点数、学习率和动量因子等因素下进行仿真,并比较分析。

3.1仿真条件

Ø

理想输入:

x=-1:

0.1:

1

理想输出:

T=[-0.96-0.577-0.0729-0.3770.6410.660.460.1336-0.201-0.434-0.5-0.393-0.16470.09880.30720.3960.34490.1816-0.03120.21830.3201]

BP网络特征:

1)单输入单输出;

2)三层网络:

输入层,隐含层(激活函数为S型),输出层(激活函数为线性);

训练最大次数:

1e5

隐含层节点数N:

[1020]

学习率lr:

[0.050.25]

动量因子mc:

[00.10]

3.2m函数仿真

隐含节点数为10,lr=0.05,mc=0.05,误差e=1e-3,理想输出与拟合曲线比较如图2所示。

训练完毕后,隐含层权系数为Wij=[-0.023