Hadoop云计算平台搭建最详细过程共22页教案资料Word文档格式.docx

《Hadoop云计算平台搭建最详细过程共22页教案资料Word文档格式.docx》由会员分享,可在线阅读,更多相关《Hadoop云计算平台搭建最详细过程共22页教案资料Word文档格式.docx(23页珍藏版)》请在冰豆网上搜索。

Project

Version

Content

1

Hardwareenvironment

CPU:

Intel2.00GHz

Disk:

150GB

Memory:

2.00GB

Master/NameNodeIP:

192.168.100.90

Slave1/DataNodeIP:

192.168.100.105

Slave2/DataNodeIP:

192.168.100.106

2

Operationsystem

Ubuntu-12.04

64-bit

3

JDK

/usr/bin/jvm/jdk1.7.0_51

4

Hadoop

hadoop-1.2.1.tar.gz

/home/majiangbo/hadoop-1.2.1

5

Zookeeper

zookeeper-3.4.6.tar.gz

/home/majiangbo/hadoop-1.2.1/zookeeper-3.4.6

6

HBase

Hbase-0.94.20.tar.gz

/home/majiangbo/hadoop-1.2.1/hbase-0.94.20

7

Pig

pig-0.12.0.tat.gz

/home/majiangbo/hadoop-1.2.1/pig-0.12.0

8

Hive

hive-0.12.0.tar.gz

/home/majiangbo/hadoop-1.2.1/hive-0.12.0

9

Ganglia

/home/majiangbo/hadoop-1.2.1/

10

Eclipse

Eclipsestandard4.3.2

/home/majiangbo/eclipse

11

Hadoopforeclipseplugin

Hadoop-eclipse-plugin-1.2.1.jar

/home/majiangbo/eclipse/plugins

12

Chukwa

(可选)

并且所有机器均需配置SSH免密码登录。

二.Hadoop集群安装部署

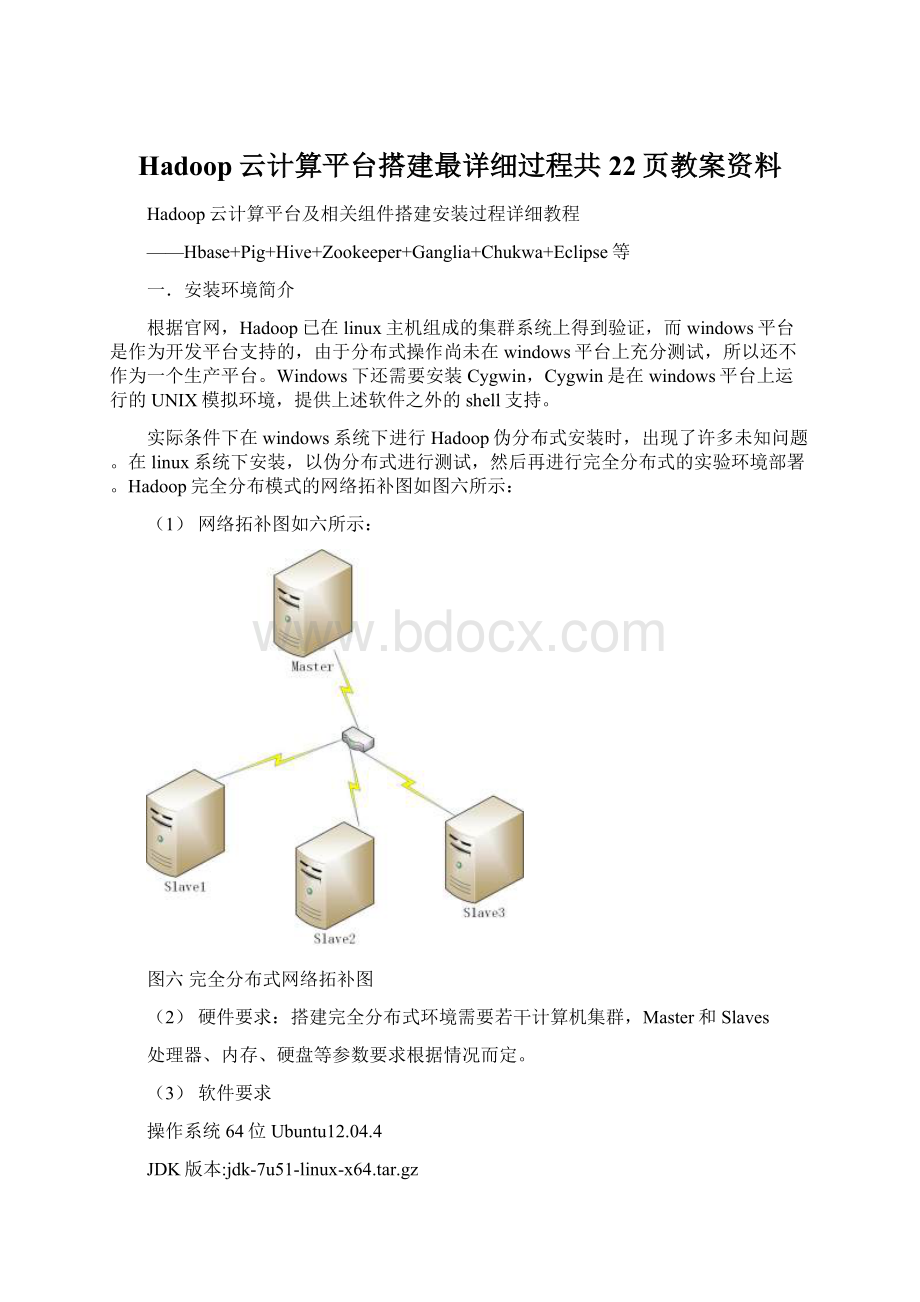

目前,这里只搭建了一个由三台机器组成的小集群,在一个hadoop集群中有以下角色:

Master和Slave、JobTracker和TaskTracker、NameNode和DataNode。

下面为这三台机器分配IP地址以及相应的角色:

192.168.100.90——master,namenode,jobtracker——master(主机名)

192.168.100.105——slave,datanode,tasktracker——slave1(主机名)

192.168.100.106——slave,datanode,tasktracker——slave2(主机名)

实验环境搭建平台如图七所示:

图七hadoop集群实验平台

并且,Hadoop要求集群上每台的用户账户名和密码相同。

具体安装步骤如下:

1.下载和安装JDK,版本为jdk-7u51-linux-x64.tar.gz

(1)JDK的安装目录为/usr/lib/jvm,创建此文件夹,在终端输入命令:

mkdir/usr/lib/jvm

(2)权限不够的话重新改下用户密码就可以了,命令:

sudopasswd,之后重新输入密码。

(3)移动jdk到/usr/lib/jvm,并解压,然后为了节省空间删除安装包。

命令:

mvjdk--7u51-linux-x64.tar.gz/usr/lib/jvm

tar–zxvfjdk--7u51-linux-x64.tar.gz

rm–rfjdk--7u51-linux-x64.tar.gz

2.配置环境变量

在终端输入命令:

sudogedit/etc/profile

打开profile文件,在文件最下面输入如下内容,如图八所示:

图八JAVA环境变量设置

即为:

#setjavaenvironment

exportJAVA_HOME=/usr/lib/jvm/jdk1.7.0_51

exportCLASSPATH=”.:

$JAVA_HOME/lib:

$CLASSPATH”

exportPATH=”$JAVA_HOME/:

$PATH”

这一步的意义是配置环境变量,使系统可以找到jdk。

3.验证JDK是否安装成功

(1)输入命令:

java–version,如图九所示。

如果出现java版本信息,说明当前安装的jdk并未设置成ubuntu系统默认的jdk,接下来还需要手动将安装的jdk设置成系统默认的jdk。

图九java版本信息

(2)手动设置需输入以下命令:

sudoupdate-alternatives–install/usr/bin/javajava/usr/lib/jvm/jdk1.7.0-51/bin/java300

sudoupdate-alternatives–install/usr/bin/javacjavac/usr/lib/jvm/jdk1.7.0_51/javac300

sudoupdate-alternatives–configjava

然后输入java–version就可以看到所安装的jdk的版本信息。

4.三台主机上分别设置/etc/hosts和/etc/hostname

Hosts这个文件用于定义主机名和IP地址之间的对应关系,而hostname这个文件用于定义你的Ubuntu的主机名。

(1)修改/etc/hosts,命令sudogedit/etc/hosts

127.0.0.1localhost

192.168.100.90master

192.168.100.105slave1

192.168.100.106slave2

(2)修改/etc/hostname,命令sudogedit/etc/hostname(修改完重启有效)

master

以及slave1,slave2

5.在这两台主机上安装OpenSSH,并配置SSH可以免密码登录

(1)确认已经连接上网,输入命令:

sudoapt-getinstallssh

(2)配置为可以免密码登录本机,接下来输入命令:

ssh-keygen–tdsa–P‘’–f~/.ssh/id_dsa

解释一下,ssh-keygen代表生成密匙,-t表示指定生成的密匙类型,dsa是密匙认证的意思,即密匙类型,-P用于提供密语,-f指定生成的密匙文件。

这个命令会在.ssh文件夹下创建id_dsa以及id_dsa.pub两个文件,这是ssh一对私匙和公匙,把id_dsa.pub追加到授权的key中。

输入命令:

cat~/.ssh/id_dsa.pub>

>

~/.ssh/authorized_keys

(3)验证ssh是否已经安装成功,输入命令:

ssh–version。

将文件复制到slave主机相同的文件夹内,输入命令:

scpauthorized_keysslave1:

~/.ssh/

scpauthorized_keysslave2:

(4)看是否可以从master主机免密码登录slave,输入命令:

sshslave1

sshslave2

6.配置两台主机的Hadoop文件

首先到Hadoop的官网下载hadoop-1.2.1.tar.gz包,默认讲Hadoop解压到/home/u(你的Ubuntu用户名)/目录下

(1)进入hadoop内的conf文件夹,找到hadoop-env.sh,修改:

exportJAVA_HOME=/usr/lib/jvm/jdk1.7.0_51,指定JDK的安装位置,如图十所示:

图十JAVA_HOME路径设置

(2)修改core-site.xml,这是Hadoop的核心配置文件,这里配置的是HDFS的地址及端号:

<

configuration>

property>

<

name>

fs.default.name<

/name>

value>

hdfs:

//master:

9000<

/value>

/property>

hadoop.tmp.dir<

/tmp<

/configuration>

(3)修改hdfs-site.xml

dfs.replication<

2<

(4)修改mapred-site.xml

mapred.job.tracker<

master:

9001<

(5)修改conf/masters

(6)修改conf/slaves

slave1

slave2

7.启动hadoop

在启动之前,需要格式化hadoop的文件系统HDFS,进入hadoop文件夹,输入命令格式化:

bin/hadoopnamenode–format,如图十一所示:

图十一hadoop格式化

输入命令,启动所有进程:

bin/start-all.sh,如图十二所示:

图十二hadoop启动信息

查看是否所有进程启动,输入命令:

jps,如图十三所示:

图十三jps查看进程

8.最后验证hadoop是否成功启动

打开浏览器,查看机器集群状态分别输入网址:

(1)输入http:

50070,如图十四,可看到:

图十四namenode状态

点击livenodes,可以看到当前slave1和slave2两个节点信息,如图十五:

图十五datanode节点状态

(2)输入http:

50030,如图十六,可看到:

图十六jobtracker状态

点击2nodes查看tas