各厂商高端存储产品技术对比共22页word资料.docx

《各厂商高端存储产品技术对比共22页word资料.docx》由会员分享,可在线阅读,更多相关《各厂商高端存储产品技术对比共22页word资料.docx(15页珍藏版)》请在冰豆网上搜索。

各厂商高端存储产品技术对比共22页word资料

各厂商高端存储产品的技术对比

1背景信息

存储(即智能磁盘阵列)已经成为企业IT支撑系统越来越重要的一个分支。

目前全球范围公认的主流存储解决方案供应商主要有HP、EMC、IBM等。

随着技术的发展和市场的分化,上述几个主流厂商都向市场提供两个系列的存储产品:

即高端存储和中端存储两个系列,分别满足不同级别和不同规模的应用需求。

为了更好地进行产品选型,我们需要对各厂商的产品进行深入分析对比,以作为我们选择的重要依据。

本文首先对各厂商的高端存储进行分析,中端存储的分析将在其他文件中提供。

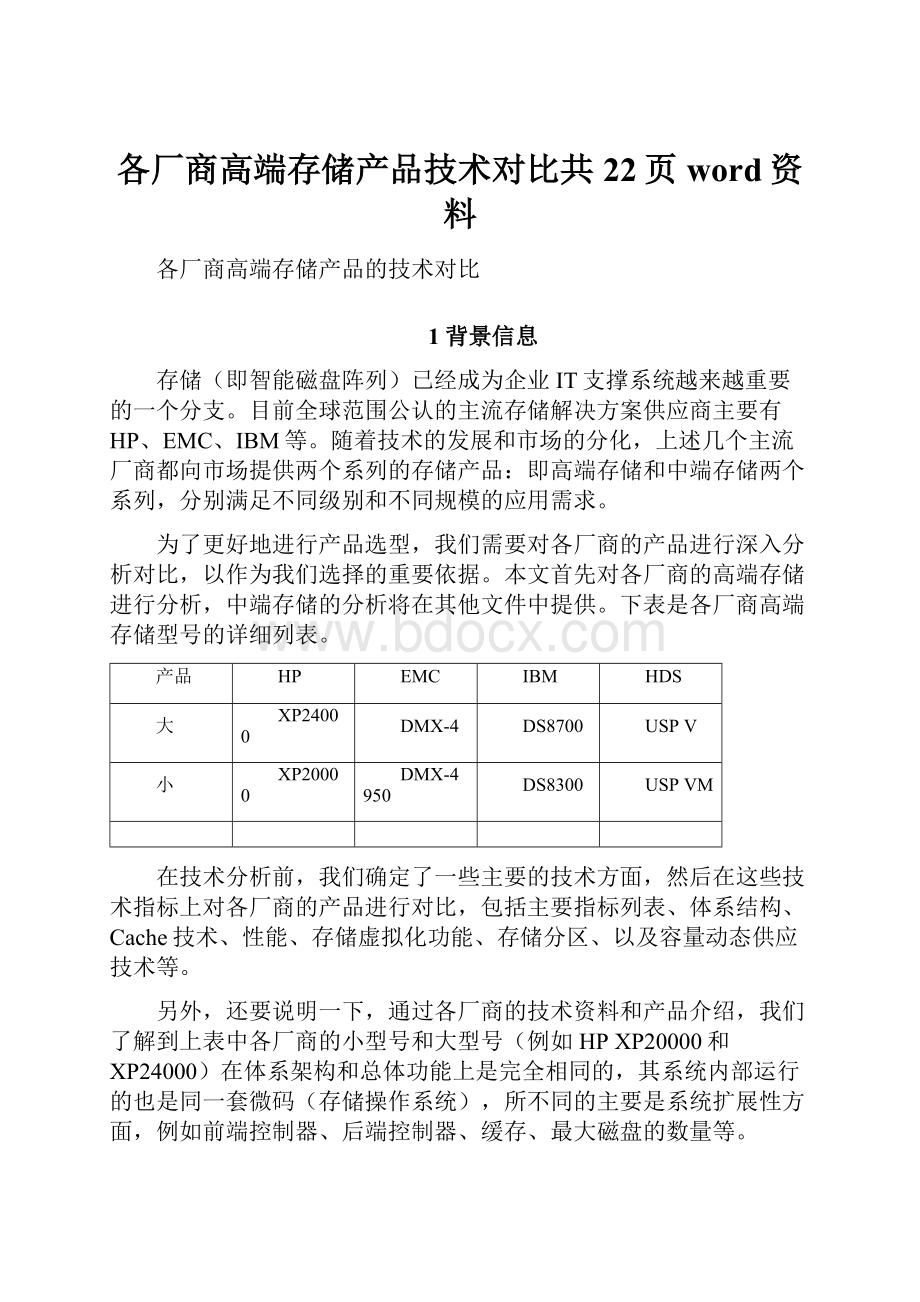

下表是各厂商高端存储型号的详细列表。

产品

HP

EMC

IBM

HDS

大

XP24000

DMX-4

DS8700

USPV

小

XP20000

DMX-4950

DS8300

USPVM

在技术分析前,我们确定了一些主要的技术方面,然后在这些技术指标上对各厂商的产品进行对比,包括主要指标列表、体系结构、Cache技术、性能、存储虚拟化功能、存储分区、以及容量动态供应技术等。

另外,还要说明一下,通过各厂商的技术资料和产品介绍,我们了解到上表中各厂商的小型号和大型号(例如HPXP20000和XP24000)在体系架构和总体功能上是完全相同的,其系统内部运行的也是同一套微码(存储操作系统),所不同的主要是系统扩展性方面,例如前端控制器、后端控制器、缓存、最大磁盘的数量等。

2体系结构分析

体系结构决定着产品的本质特性:

一个产品拥有优秀、均衡的体系结构,这个产品才能拥有良好的可靠性和稳定性,才能拥有高的性能。

2.1HPXP系列产品体系结构——先进的统一星型网络架构

HPXP系列产品作为高端存储,拥有一个适合存储系统的、没有潜在瓶颈的、全光纤交换式和点对点直连相混合的统一星型网络体系架构UniversalStarNetwork(USN),如下图所示。

图中CHA为前端通道控制器,DKA为后端磁盘控制器,SMA是控制缓存,CMA是数据缓存,CSW是内部缓存交换机。

HPXP系列产品的技术白皮书列举了USN统一星型网络体系结构拥有2项核心技术:

第一项:

数据缓存读写采用全光纤交换式架构。

交换式体系结构又称CrossBar结构,是一种高带宽、大吞吐率和无阻塞的体系结构,已经广泛应用在IT行业、电信行业的高端设备上。

不论是大型UNIX主机(HPSuperdome、SunEnterpriseServer25K、IBMP590等),以太网核心交换机(Cisco)、存储网核心交换机(如Brocade、McData以及CiscoSANDirector),甚至是电信交换机等均采用了无阻塞CrossBar技术作为其系统架构,这已经是业界发展的方向。

Cache是存储系统的核心部件,XP把整个系统的所有缓存Cache分为两个独立部分:

数据缓存(如上图CMA所示)和控制缓存(上图SMA所示)。

其中数据缓存用来存放服务器/主机读写的数据,控制缓存是用来存放数据缓存的索引(我们称之为metadata)以及系统通信数据的共享区的。

存储系统把数据缓存在逻辑上分为若干个page(大小为4K,8K,16K等),每个page有一个线性地址(即pageID)。

每次读写都是以page为单位进行,即使是只需要读一个byte,最后对缓存的读写也是以一个page进行的。

因此对于数据缓存来说,最重要的是需要持续的高带宽和大吞吐率,XP在数据缓存读写上采用交换式结构设计——这是真正的根据存储系统的特点而设计的。

oXP24000从内部交换机到数据缓存设计有64路1.0625GB/s的通路连接起来,数据缓存共有68GB/s的带宽;

oXP20000从内部交换机到数据缓存设计有8路1.0625GB/s的通路连接起来,数据缓存共有8.5GB/s的带宽;

其次是控制缓存采用点对点直连技术。

如上文所述,控制缓存主要用来存放数据缓存的索引和共享通讯数据。

其中数据缓存的索引是一张二元表,其数据结构如下:

某个数据块在磁盘数据卷上的地址

某个数据块在数据缓存上的地址

在微观上,服务器对存储的一次读写的详细过程如下:

业务软件读某个数据>数据库演变为读某个数据库表纪录>数据库底层演变为读某个逻辑卷的某个数据块>操作系统卷管理软件演变为读某个数据卷的某个数据块>XP24000演变为某个LUN的某个page>XP24000在控制缓存中查找索引,判断是否该数据page在数据缓存中。

如果返回一个非0值,说明该数据在数据缓存中,这次读操作为读命中readhit;如果返回为一个0值,这说明此次操作为readmiss,系统将在共享缓存中写入该数据块pageID,并通知后端磁盘控制器将数据块读入到数据缓存中。

XP任何一个操作,都需要访问控制缓存。

而且对控制缓存的读写有如下特点:

o每次对控制缓存的访问的数据量很小,一般就是一个长整数(即pageID);

o读写并发度很高,因为一次数据读写可能导致多次控制缓存的读写;

o控制缓存中还包含了大量存储控制器之间的通信数据,但每次访问的数据量都不大。

o因此对控制缓存的技术要求是:

控制器到控制缓存的通道要多,每条通道的带宽不必很宽。

XP就是遵循这个设计原则,对控制缓存的读写设计为点对点直连结构:

vXP24000每个控制器(包括前后端控制器)都通过4路150MB/s的通路直接连接到每个控制缓存卡上,因此系统满配置32块控制器的情况下,一共设计有4*32*2=256路150MB/s的通路,整个带宽为38.4GB/s;

vXP20000每个控制器都通过2路150MB/s的通路直接连接到每个控制缓存卡上,因此系统满配置8块控制器的情况下,一共设计有2*8*2=32路150MB/s的通路,整个带宽为4.8GB/s;

结论

HPXP采用数据缓存交换式结构,控制缓存点对点直连结构是最符合存储系统对数据访问和管理的特点的,这种统一星型网络结构是最稳定和均衡、最先进和最高性能的体系架构。

这是其他厂商所无法相比的。

2.2EMCDMX-4/DMX-4950体系结构

EMC高端存储系统2个型号DMX-4/DMX-4950采用的是类似的结构,但又有不同。

我们先分析一下DMX-4的结构,再阐述DMX-4950结构的不同之处。

DMX-4采用的是DMX结构,即直连矩阵结构DirectMatrixArchitecture。

EMC称这种点对点DMX结构是能够彻底消除系统带宽瓶颈的“先进”架构,是比已变成工业界事实标准的CrossBar高端系统架构还要优越的体系结构?

我们分析一下实际情况。

下图就是DMX体系结构示意图。

从图中可知,DMX结构中主要可描述如下:

前端8个各类通道控制器与8块Cache卡点对点直接相连,共64个连接通路;

8个后端磁盘控制器也与8块Cache直接相连,共64个连接通道;

这里有一点最重要,就是所有通道和磁盘控制器均连接到一个称之为“ControlandCommunicationSignals”的卡上,如图中所标示的。

这个卡实际上是一个Multiplexer。

Multiplexer是什么东西呢?

它实际上是一个多路复用器,DMX-4/DMX-4950采用这种多路复用器对多个通道控制器和磁盘控制器访问同一个Cache卡可能产生的冲突进行控制。

现在很多人都不知道Multiplexer是什么东西。

实际上在早期IBM大型机上使用的SNA网络上就是使用的这种“多路复用器”,直到网络交换机出现以后,才被市场所淘汰。

与交换技术和交换机相比,Multiplexer是一种原始和低级的复用设备,其延迟和效率都非常低,仅适合对数据量不大的某个控制信号使用,而采用到存储系统中来控制多路对Cache卡的冲突,很难适应高端存储系统可靠性和稳定性不断提高的要求,其本身已经为市场所淘汰。

另外需要指出的是,DMX-4950中,Cache卡只有2块,前端通道控制器与后端磁盘控制器共用一个控制器,共用一个带宽,因此其带宽很小,该产品的可靠性和性能可想而知。

而相比之下,HDSUSPVM所有的控制器都是互相独立的,不是共享同一块控制器。

2.3IBMDS8000体系结构——落后的双控制器结构

虽然DS8000系列产品被IBM称之为高端存储系统,但是其采用的是典型的双控制器结构,这种架构是中端存储系统采用的结构。

因此有不少第三方分析师把DS8000定位为一个具有高端的可扩展性能力的中端存储产品。

请看下图。

资料来源:

IBMDS8000Redbook

如图所示,DS8000实质上是由左右两边2台简装的IBMp570小型机作为控制器,共享内部总线(RIO-Gloop)的这样一个双控制器共享总线结构。

这个结构是典型的中端存储的结构,下图是各厂商中端存储的体系结构,这些中端存储包括HDSAMS1000、EMCCX3-80、IBMDS4800。

大家请看看有何不同?

体系结构决定着系统的档次和定位,这就是为什么众多第三方独立咨询机构都把DS8000产品定位为中端存储产品的本质原因。

HDSAMS系列存储系统架构图

总之,DS8000是由2台简装的p570,其上运行简化的unix操作系统和阵列控制软件,通过共享总线,外挂接口卡以及若干磁盘组成。

特别要指出的是,2台p570上运行的unix简化版和阵列控制软件,并不是存储系统上的微码,而是普通服务器上的Cluster软件和相关的应用软件,其执行效率和响应速度都无法满足存储系统对微码的要求。

存储系统的微码需要简化、高效、执行速度快、周而复始地完成服务器/主机对数据的访问请求,以及相关存储软件功能(例如数据本地复制克隆快照、远程数据复制等),而DS8000显然难于满足这个要求。

更重要的是,这种设计最致命的是影响系统的可靠性和稳定性。

众所周知,双机热备集群技术对于普通应用系统来说,基本能满足业务要求——在一台小型机故障的情况下,在有限时间里业务能切换到另一台小型机上,但是所有使用过cluster的客户都很清楚,这个有限时间是在分钟一级——就是配置得非常优化的应用系统,这个时间也往往要5分钟以上。

5分钟对服务器来说,可能是可以忍受的,而且也仅仅影响到这台服务器上的业务。

但对于存储系统来说,特别是高端存储系统,这几乎是致命的。

存储系统是业务IT支撑平台最中心的设备,在数据集中化趋势越来越明显的情况下,众多客户整个企业可能所有的业务均整合在同一台存储系统中,这台高端存储系统需要支撑所有服务器和主机,每秒钟可能会发生几百甚至几千个I/O,DS8000一旦出现一台p570故障,系统需要在几分钟之后才能把这部分数据切换到另一台p570上,系统会怎样,众多业务服务器/主机会怎样,整个企业前端业务会怎样?

尊敬的客户,您敢用吗?

而这一点在中端存储上都不会出现,因为中端存储采用的系统微码的实时性都要高于DS8000,例如HDSAMS1000采用的是VxWorks的切换时间都在毫秒级,对前端服务器的读写没有影响。

这是客户反映的IBMDS8000不稳定的根本原因。

3Cache技术分析

存储系统中数据最终是存放在若干个磁盘。

由于磁盘的读写本质上是一个机械过程,其速度比CPU速度要低1到2个数量级。

因此对于存储系统来说,一边是服务器/主机高速请求,另一边是磁盘低速读写,因此必须通过相应部件和技术来调和这个高低矛盾。

这个部件和技术就是高速缓存(Cache)和缓存管理技术。

本小节就着重分析各厂商的Cache管理技术。

3.1HPXP20000/XP24000缓存技术

XP20000/XP24000在Cache设计方面拥有多项专利技术。

如下图所示。

XP采用控制缓存、控制链路与数据缓存、数据链路分离设计技术。

HP实现的是集中式缓存设计——控制缓存相当于数据缓存的集中索引。

XP拥有2块独立的控制缓存卡,互为镜像保护,不存在单点故障。

任何一个读写操作以前,均要通过控制缓存,迅速检索出某个卷的某个数据块在数据缓存的线性地址,然后再依据该地址对数据块进行操作。

这种集中式缓存设计拥有业界最高的缓存管理效率;

XP具备缓存智能调整策略,可自动识别读、写缓存的比例已达到缓存利用的最佳效率。

30%容量是基本读缓存,30%是基本写缓存,40%是智能调整部分,因此XP24000可根据业务特点灵活调整,使得系统能自动吻合客户需求,表现最高的系统效率;

3.2EMCDMX-4缓存技术

DMX-4/DMX-4950采用的是典型的分布式缓存设计。

DMX-4的缓存满配置8块缓存卡中,每块缓存卡互相独立。

DMX-4缓存为混合缓存,既包括数据信息,也包括控制信息,而不存在独立和集中的控制缓存卡,每块缓存卡上分配一定地址范围作为该缓存卡的控制信息或索引。

即每块缓存卡部分内容为控制信息,其他为数据信息,这种无集中控制缓存机制的设计就是分布式缓存架构。

在分布式缓存结构中,对任一数据块的访问,必须对缓存卡进行遍历查询,至少要遍历缓存卡的控制信息区域。

因此该缓存设计模式效率是比较低的,这就是EMC不参加SPC性能测试的原因之一吧。

3.3IBMDS8000缓存技术

IBMDS8000为了提高数据写入到Cache的可靠性,在设计上引入了一个NVM的机制。

如下图所示,IBM在常规缓存(IBM也称之为volatilememory,即读Cache)外,专门增加了一块永久内存模块(PersistentMemory,也称为NVM)用来做写Cache,所有外部服务器/主机写入I/O全部先写入这个永久内存模块,然后在两台p570上分别配置独立永久内存模块,交叉将双方的写数据写入对方的写Cache中实现镜像。

如下图所示。

但是非常遗憾的是,DS8100设计的NVS镜像后最大只能为4GB,DS8300设计的NVS镜像后最大只能为8GB,根本无法满足一般应用的正常需求。

一旦某些业务要处理大批新数据时,这是NVS写Cache显然不够用,系统将频繁地根据LRU算法更新NVS的空间,从而导致NVS的抖动,这将会急剧降低系统的总体性能。

如移动公司每个月底将数据写入到数据仓库系统中时,将造成大量数据写,系统的性能会明显降低,甚至出现“假死”现象,实际上就是系统休克。

4缓存并发访问能力比较

由于缓存在提高存储系统,特别是高端存储系统的整体性能所充当的关键作用,使得缓存的设计、缓存的管理机制,特别是缓存访问的并发程度,变成影响存储性能的核心因素。

下面就对几个产品的缓存并发数做一个详细说明,希望能进一步加深客户对高端存储系统的认识。

HPXP24000

EMCDMX-4

IBMDS8300

Cache并发访问数

320

32

16

HPXP20000

EMCDMX-4950

IBMDS8100

Cache并发访问数

40

8

8

从两个表可以明确看出,HP各款高端存储的缓存并发度都极大地超过其它产品,因此尽管HP缓存容量比较小,但性能却大大超过竞争对手。

4.1HPXP24000缓存并发数

XP24000将缓存分开设计为数据缓存和控制缓存。

其中数据缓存并发度为64路,是指由内部缓存交换机到数据缓存的通道数共有64路,每路1.062GB/s带宽;控制缓存并发度为256路,只是前端通道控制器和后端磁盘控制器到控制缓存的直连通道数共有256路,每路150MB/s带宽;数据缓存和控制缓存总的通道数为320路,因此一共是320路并发访问数。

为了便于理解下面4个图,简单说明一下图中相关名词:

CHA——ChannelAdapter,前端通道适配器,也称通道控制器,用于连接外部服务器/主机;

DKA——DiskAdapter,后端磁盘适配器,也称磁盘控制器,用于连接内部磁盘;

SMA——SharedMemoryAdapter,共享缓存适配器,也称控制缓存卡,用于存放系统用的控制信息,索引,内部通讯数据等;

CMA——CacheMemoryAdapter,缓存适配器,也称数据缓存卡,用于存储外部服务器/主机读写的数据;

XP24000控制缓存并发度为256路

XP24000数据缓存并发度为64路

4.2HPXP20000缓存并发数

如上文所分析,XP20000将缓存分开设计为数据缓存和控制缓存。

其中数据缓存并发度为8路,控制缓存并发度为32路,一共是40路并发访问数。

XP20000控制缓存并发度为32路

XP20000数据缓存并发度为8路

4.3EMCDMX-4/DMX-4950缓存并发数

请到EMC官方网站上下载EMCDMX-4技术规格文件,其中“EMCSymmetrixDMX-4SpecificationSheet”中“SystemResources”部分,最后一行“Concurrentmemorytransfers 32 4perGlobalMemoryDirector”。

这里简单说明一下:

---所谓“GlobalMemoryDirector”就是指DMX-4的缓存卡;

---DMX-4最少配置为4块缓存卡,最多为8块,每块卡系统设置为4个区(region),每个区同一时刻只允许1路I/O访问,因此并发访问为16路~32路;

---DMX-4950固定配置只有2块缓存卡,因此一共只允许8路并发。

4.4DS8300缓存并发数

这是DS8300两台p570控制器的互连图(interconnection),DS8100只有Loop0,而DS8300支持2个RIO-G互联环路即Loop0和Loop1。

其中I/Oenclosure中有连接服务器的HostAdapter和连接磁盘的DeviceAdapter,所有外部服务器提出的I/O请求以及对磁盘发起的I/O请求,都必须经过这个RIO-G。

ProcessorComplex0和1就是指p570服务器,每个服务器通过2个端口连接到RIO-G环路上,每个端口支持2路并发环路访问,一共可支持8路并发访问。

因此DS8100可支持8路,而8300可支持16路并发访问。

4.5小结

高速缓存是影响高端存储的关键部件,高速缓存的并发访问可以成倍地提高存储系统的综合性能,并发访问数没有提高上去,后端的磁盘通路再多有什么用呢?

(注:

磁盘再快,都只有CPU/Memory的1/100~1/10。

)

5IO性能

存储性能衡量的指标通常只有两个:

一个是持续访问带宽,另一个是IOPS。

持续访问带宽代表了存储单位时间的最大吞吐量,核心就是磁盘阵列的Cache访问带宽。

XP24000的Cache持续带宽是106GB/s,DMX-4是32GB/s,DS8300也只有16GB/s。

XP20000的Cache持续带宽是13.3GB/s,DMX-4950是8GB/s,DS8100也只有8GB/s;

IOPS值代表每个IO的块大小一定的情况下,存储每秒钟能随机处理的IO数量。

IOPS代表了最理想情况下存储在OLTP环境下的随机IO的处理能力。

IOPS各个厂商有自己公布的值,但是出入很大而且没有一个独立的标准。

因此真正可以比较的是第三方独立存储性能组织SPC的测试值。

SPC有自己公开的测试标准,也是一个业界公认的独立的衡量标准。

从目前在SPC已有测试结果看,目前高端只有HDSUSPV和IBMDS8300Turbo参加测试了。

由于USPVM与USPV、DS8100与DS8300是统一系列不同产品,因此通过比较USPV/DS8300,可以在一个基础数据之上进行类比分析,得到一个相对客观的结论。

5.1测试结果公开网站

http:

//storageperformance.org/results/benchmark_results_spc1

5.2DS8300测试结果

DS8300Turbo性能曲线图,数据来源SPC

说明:

DS8300Turbo100%负载点IOPS值为123033.4,此时系统的响应时间已经为17ms左右。

5.3XP24000测试结果

XP24000性能曲线图,数据来源SPC

说明:

XP24000100%负载点IOPS值为200245.73,此时系统的响应时间仅为5ms左右。

5.4对比

100%负载点时,XP24000性能(每秒响应主机读写次数)是DS8300的1.6275倍,系统响应时间(主机读写平均等待时间)前者是后者的是0.2941倍,因此系统综合性能效益表现HDSUSPV是IBMDS8300Turbo的5.5338倍。

5.5DMX-4/950测试结果

EMCDMX-1到DMX-4所有产品都没有进行公开测试,不知其确切原因。

但从众多第三方的信息了解到,EMC主动不参加SPC的第三方独立测试的可能性大。

6存储虚拟化整合技术

6.1HPXP20000/XP24000虚拟化

存储虚拟化管理是目前存储界最尖端技术。

现在得到客户认同,并真正可付诸实施的产品就是HP的XP20000/XP24000。

IDC、Gartner、ESG等独立咨询机构都给予了高度评价。

XP24000可以将连接在同一个SAN上或者是直连的其他外部存储系统(如EMCCX/DMX、IBMDS4000/DS6000/DS8000、HPEVA等等)映射成内置卷,然后对其进行虚拟化管理。

虚拟化以后的设备对主机透明,主机不必关心虚拟化存储池内的不同设备,只需面对XP24000即可。

存储虚拟化可实现数据的分级存储。

对于不少用户的业务系统,这一功能非常有效:

用户可以选择将使用频率最高、访问最密集的数据存放在XP24000内部磁盘的一级存储上,而将那些需要归档或者是访问品率降低的老数据转移到由XP24000管理的外部存储设备上,这些外部设备可以选择容量更大,成本更低的存储来实现,也可使用客户已有的旧设备。

所有应用访问都不用关心任何后台存储环境的真实变化,仅仅需要访问XP24000虚拟化平台阶。

这样既满足了用户各种集中访问的需要,又能依据数据的时效性和重要性,灵活地进行数据部署,最大限度地降低建设和维护成本,真正实现数据生命周期管理。

需要指出的一点是,XP24000虚拟化机制具有“性能遗传”能力。

高性能的虚拟化平台可替代原有旧存储的传统控制器,并大幅度提高被虚拟化磁盘阵列的I/O响应能力,彻底改善低端盘阵或者就盘阵的性能问题,大大提高了低端盘阵和旧盘阵的使用价值。

同时XP24000并不将用户锁定在虚拟化引擎上,而是完全开放的,在虚拟化的同时也支持外部盘阵数据的独立使用。

XP24000虚拟化平台对外部存储管理的过程中,采用外部存储本身的数据格式,完全维护了数据在外部存储上原有的方式,因此在数据迁移过程中,不会对原有的数据格式做任何修改,这样使得原有存储系统上数据得到充分保护,各个方向的数据迁移非常平化。

就是未来客户要更换虚拟化平台,也会发现外部存储系统离开XP24000数据照常使用。

这给客户拥有了更多的方案选择权。

6.2IBM和EMC虚拟化技术

IBMDS8000存储自身没有虚拟化能力,不能整合外挂任何外部盘阵,而需要借助专门的设备执行虚拟化功能,即SVC(SANVolumeController)。

IBMSVC由多个LinuxPC服务器构成,挂接到SAN网络后,会识别并管理SAN网络中的物理存储设备,将物理LUN虚拟化以后成为逻辑LUN提供给主机访问。

主机的I/O访问会先经过SVC,然后到达存储。

SVC在主机的数据访问通道上提供复制、数据迁移等服务。

总之,SVC相当于在主机和存储之间,插入一台服务器,将